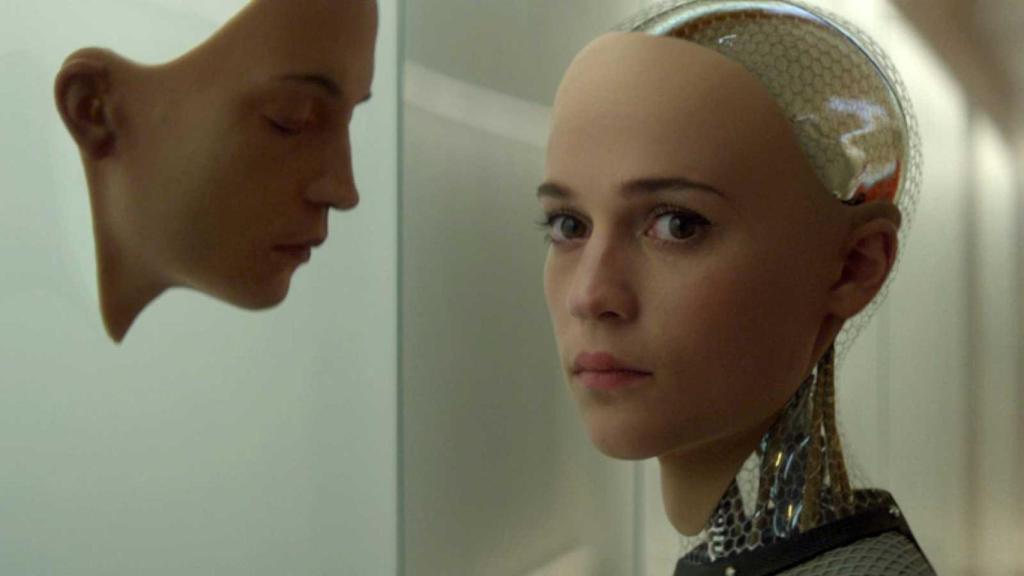

Alicia Vikander en 'Ex machina' (2014), de Alex Garland

Tiempo muerto para la inteligencia artificial: ¿hacia dónde vamos?

Salta el debate sobre el intercambio constructivo, la cultura de cooperación y los ideales éticos de esta tecnología que ya invade todas las áreas de la sociedad

¿Cuánto tiempo más podré estar ocupándome de esta sección antes de que me sustituya una máquina inteligente? No es esta una pregunta baladí pues no es difícil aventurar que una de esas máquinas podrá, con sus mastodónticas bases de datos, identificar asuntos de actualidad y componer artículos semejantes al que ahora, estimado lector, está usted leyendo. Lo hará, además, a una velocidad inigualable para cualquier humano y con un estilo literario no desdeñable.

Dada la popularidad que recientemente ha alcanzado la puesta en funcionamiento del ChatGPT –desarrollado por la empresa OpenAI–, por el momento en la versión GPT-4, no es sorprendente que la inteligencia artificial (IA) haya pasado a ocupar un puesto preferente en las noticias diarias, así como en comentarios de todo tipo de medios de información.

Y a todo este revuelo se ha añadido la publicación, el pasado 22 de marzo, de una carta abierta, firmada por conocidos expertos en IA, en la que se pide “que todos los laboratorios de IA detengan durante al menos seis meses el desarrollo de los sistemas de IA más poderosos que GPT-4”. “Los sistemas de IA que compiten en inteligencia con los humanos –precisa la carta– pueden plantear riesgos profundos a la sociedad y la humanidad […]. Como se afirma en los ampliamente apoyados Principios Asilomar, la IA representa un cambio profundo en la historia de la vida en la Tierra, y debería ser planificada y utilizada con cuidado y recursos mesurados”.

¿Es ético desarrollar técnicas para conseguir grandes bases de datos destinadas a vender los productos que una empresa produce?

La utilización del nombre “Asilomar” merece una primera reflexión. Inmediatamente después de que se introdujesen, en torno a 1970, las primeras técnicas de ADN recombinante (cortar y pegar trozos de ADN), se reconoció que sería posible construir moléculas de ADN recombinante in vitro, generándose especulaciones y debates acerca de las implicaciones de la tecnología genética en los seres vivos, incluidos los humanos.

Parecía claro entonces que la biología molecular, en forma de ingeniería genética o biotecnología, podría permitir seleccionar si no individuos sí algunos de sus genes; crear, en definitiva, nuevos genes y por tanto nuevas formas de vida, algo que terminó sucediendo. Específicamente, en 1971 se propuso un experimento con el que se pretendía insertar el cromosoma del virus SV40 en una cepa de la bacteria Escherichia coli. La perspectiva de que una bacteria –especialmente una que aparece de manera natural en el intestino humano– pudiese ser tratada para transportar el ADN de un virus capaz, bajo ciertas condiciones experimentales, de provocar tumores en roedores, alarmó a algunos biólogos moleculares.

La Academia Nacional de Ciencias de Estados Unidos solicitó que se estableciese una moratoria mundial voluntaria en esa área de investigación debido a los riesgos potenciales e impredecibles que podría acarrear para la salud humana. Con este fin se celebró una reunión internacional en febrero de 1975 en el Centro de Conferencias de Asilomar (California), en la que participaron 140 científicos. Pero lo que se aprobó allí no fue una moratoria, sino unos protocolos de seguridad que se aconsejaba siguiesen los laboratorios implicados en esas investigaciones, protocolos que aún continúan aplicándose.

Los “Principios Asilomar de IA” mencionados en la carta abierta a la que me refería anteriormente, han sido elaborados por el Future of Life Institute, una organización privada, sin fines de lucro, fundada en 2014 con el objetivo de reducir los riesgos catastróficos y existenciales a los que se enfrenta la humanidad, en particular los asociados a la IA. Los 23 puntos que contiene son razonables, pero, me temo, irrealizables, nada comparable a los que surgieron del Asilomar biotecnológico.

Puntos admirables como que “debería existir un intercambio constructivo y saludable entre los investigadores en IA y los responsables políticos”, “fomentar una cultura de cooperación, confianza y transparencia entre los investigadores y quienes desarrollan la IA”, o que “la superinteligencia solamente debería desarrollarse en el servicio de unos ideales éticos compartidos, y para el beneficio de la humanidad y no para el de un Estado u organización”.

Pero, ¿existen realmente valores éticos o comerciales que compartan naciones como Estados Unidos, China, la Unión Europea o Rusia? Y qué decir de las empresas dedicadas a la IA. ¿Cooperarán? Por otra parte, ¿es ético desarrollar técnicas, ampliamente utilizadas, para conseguir grandes bases de datos destinadas a implementar tácticas para vender los productos que una empresa produce, sean estos los que sean, innecesarios la mayor parte de las veces, o, lo que es peor, que fomenten el cambio climático?

Y en este punto vuelvo de nuevo a la carta abierta que pide una moratoria en la investigación sobre IA. Es cierto que los peligros a los que alude son posibles y temibles, pero también lo es que detrás de la petición de esa moratoria puede que se encuentren motivos económicos vinculados al hecho de que algunas empresas dedicadas a la IA ven peligrar su situación, y el valor de sus acciones, al verse adelantadas por OpenAI.

El primer firmante de la carta, Yoshua Bengio, que ha recibido los premios Turing y Princesa de Asturias, no está, creo, ligado a ninguna de las grandes tecnológicas del campo, pero el cuarto, el muy conocido Elon Musk, abandonó OpenAI cuando no le dejaron ser presidente. Y no se debe olvidar que en sus múltiples actividades no se ha preocupado por las consecuencias que algunas de estas –como el turismo espacial– pueden acarrear para la humanidad.

[ChatGPT, ¿sustituto o complemento?]

El problema de cómo controlar una nueva tecnología no es nuevo. ¿Se controló una tecnología tan potencialmente dañina como la que surgió del descubrimiento de la fisión del uranio? Y ahora, en una economía mundial basada en el crecimiento continuo –y en este punto no hay diferencias en regímenes políticos tan diferentes como los de China y Estados Unidos–, en un mundo en el que existen empresas que en no pocos apartados compiten en influencia y recursos con Estados, ¿es posible controlar ya el desarrollo de la IA?

Como historiador he aprendido que “la tecnología siempre gana”. Y, lo que es más importante, ¿sabemos realmente hacia dónde conduce esta nueva “inteligencia”? Por el momento, a mí no se me ocurre mejor paliativo que desarrollar la inteligencia humana a través de la educación, la cultura y la ética, promoviendo debates serios e informados. Solo podremos controlar las máquinas inteligentes del futuro si nosotros, el conjunto de la ciudadanía, actuamos también con inteligencia.