Imagen generada por IA que representa a los trabajadores afectados. Stable Diffusion

El lado oscuro de ChatGPT: trabajadores explotados en África que cobran 1 euro por hora

Empleados de una subcontrata de OpenAI tuvieron que leer textos que incluían todo tipo de atrocidades para mejorar esta inteligencia artificial.

19 enero, 2023 18:34ChatGPT ha sido una absoluta revolución tanto en España como en el resto del mundo. El chatbot basado en inteligencia artificial que ha causado furor ha demostrado ser una herramienta casi invaluable, cuyo uso se debate ahora mismo en la educación. Sin ir más lejos, la imagen de portada de este artículo ha sido creado con un modelo de IA. Estas capacidades han hecho incluso que OpenAI consiga la atención de titanes como Microsoft. No obstante, esto ha implicado un precio: trabajadores de Kenia mal pagados y traumatizados para evitar que ChatGPT sea un desastre.

Según una investigación de la revista Time, la compañía OpenAI habría realizado una subcontratación bastante polémica de trabajadores que llegaban a cobrar 1 euro por hora para desarrollar un sistema de protección. El objetivo era que ChatGPT no diera resultados de carácter problemático que incluyeran homofobia, sexismo y otras discriminaciones.

Esto, como ocurrió con los trabajadores de moderación de plataformas como TikTok o Meta, ha causado graves problemas mentales a los trabajadores, al verse expuestos ante todo tipo de contenido potencialmente dañino, que incluía abuso sexual contra menores, delitos de violencia inusitada y un sinfín de cuestiones problemáticas.

El problema de las IA

Si estás metido dentro del mundillo de la inteligencia artificial, sabrás que en la historia ha habido casos bastante sonados sobre sesgos racistas, machistas, xenófobos y homofóbicos en las IAs. Existen muchos casos. Sin ir más lejos GPT-3, el modelo conversacional previo a ChatGPT, demostró un gran potencial pero tenía cierta tendencia a responder con comentarios de este estilo.

El porqué es fácil de explicar. Las IAs de este tipo se entrenan, usualmente, con información recogida principalmente de Internet, con palabras y oraciones (así como información o datos) presentes en la red. Los conjuntos de datos de entrenamiento para entrenar las capacidades lingüísticas de GPT-3 y de otros chatbots pasaban por incluir estas oraciones, ya que Internet está repleto de esa toxicidad.

Logo de Tay en Twitter, el perfil que se volvió racista y machista en un solo día. Omicrono

La solución pasaba por desarrollar un sistema de seguridad adicional, también con inteligencia artificial, que pudiera eliminar los rastros de dicha toxicidad en los conjuntos de datos usados. OpenAI se fijó en Facebook, que había creado una hoja de ruta para construir inteligencias artificiales que pudieran detectar este contenido (como discursos de odio, por ejemplo) y borrarlos automáticamente de sus plataformas.

No obstante, eso tiene un problema. Para entrenar la IA que se encarga de esta detección hay que proporcionarle, precisamente, ese contenido. Algunos ejemplos pasaban por incluir palabras marcadas como violencia, discursos de odio, delitos o abuso sexual. Así, la herramienta sería capaz de detectar estos discursos y borrarlos.

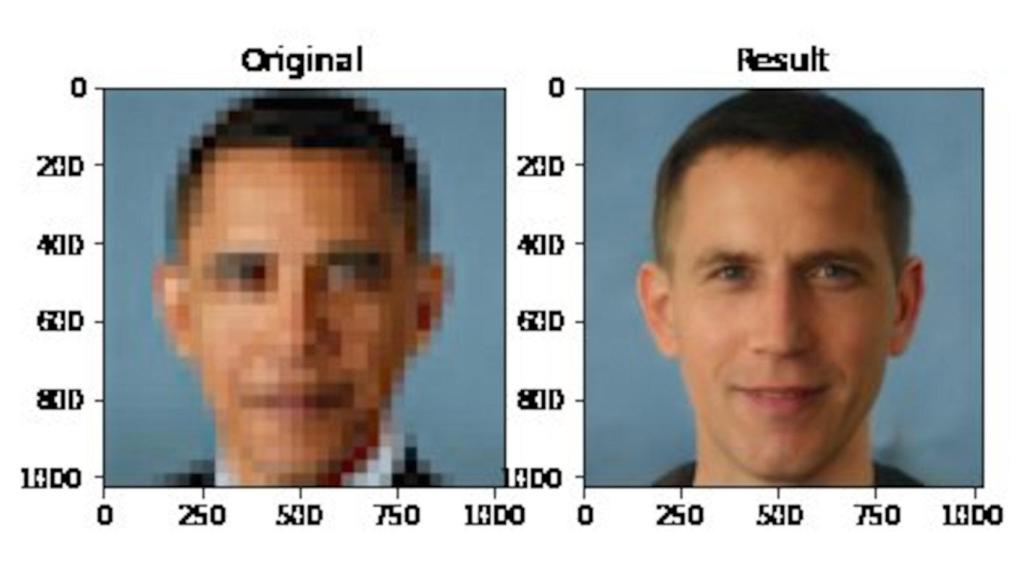

Obama, convertido en una persona blanca.

OpenAI decidió hacer esto mismo con ChatGPT, integrando dicha herramienta en el chatbot para eliminar todo rastro posible de toxicidad dentro de sus datos de entrenamiento, y filtrarlos antes de que llegasen al usuario. Además, esta herramienta serviría para otros modelos de IA, lo que reduciría los peligrosos sesgos que suelen tener estos modelos.

Subcontratando trabajadores

OpenAI destinó dicha tarea a una empresa de subcontratación en Kenia en noviembre de 2021. Les envió fragmentos de texto que, según recoge Time, parecían sacados de los entornos más nocivos de Internet, con situaciones que describían abuso sexual infantil, zoofilia, asesinatos, suicidios, torturas, autolesiones, incesto y un larguísimo etcétera. La empresa se llama Sama y tiene sede en San Francisco, aunque tiene proyección en países como Kenia, Uganda o La India.

Sama se dedica a emplear trabajadores para etiquetar datos para clientes como Microsoft, Meta o Google, publicitándose como una empresa de "inteligencia artificial ética". El salario pagado a estos trabajadores era de entre 1,32 a 2 dólares por hora, según documentos obtenidos por la publicación.

Ilustración sobre el contenido peligroso en Internet. Omicrono

El etiquetado de esta información que servía para crear la herramienta de prevención de toxicidad en ChatGPT (que al final se acabó implementando) obligaba a que los empleados se expusieran a toda esta información, y que tuvieran que consumirla en forma de texto. Declaraciones desgarradoras de trabajadores de Sama a Time revelan cómo tuvieron que leer auténticas atrocidades que incluían situaciones sexuales escabrosas o relatos sobre delitos perturbadores.

Estos mismos trabajadores han relatado a la revista que, tras el consumo de este contenido, algunos acababan afectados psicológica y emocionalmente. Uno de ellos afirmaba ver visiones tras acabar su jornada de trabajo. Otro tuvo que leer un relato que incluía pedofilia y zoofilia o bestialismo. "Leerás una serie de declaraciones como esa durante toda la semana. Para cuando llega el viernes, estás perturbado por pensar en esas imágenes".

Navegando en Internet.

El trabajo fue tan sumamente traumático que Sama canceló todo el proyecto, cortando el trabajo con OpenAI en febrero del año pasado, 8 meses antes de la fecha final prevista. Los empleados podían llegar a leer y etiquetar entre 150 y 250 pasajes de texto en turnos de nueve horas, con números de palabras que oscilaban entre las 100 y las 1.000.

Lo más llamativo es que, al igual que ocurre en otras empresas, a estos trabajadores se les ofreció ayuda psicológica con "consejeros de bienestar". Los empleados han asegurado que dichas sesiones "eran inútiles". De hecho, acababan siendo una manera más de presionarles para que fueran más productivos en sus turnos.

[La inteligencia artificial de Facebook se rebela contra Zuckerberg: "Es un manipulador"]

Los salarios por este trabajo podían depender de la antigüedad laboral o la edad. Los más jóvenes podían recibir una media de 170 dólares al mes, con bonos de alrededor de 70 dólares adicionales. Se podía llegar a cobrar, por ejemplo, 1,32 dólares por hora en turnos de 9 horas. Sama ha negado varios de los puntos de la investigación, como el que refiere a los objetivos de productividad o las administraciones de nóminas y seguimiento de salud mental de los trabajadores.

Los motivos del cese de trabajo entre Sama y OpenAI fueron variados, siendo la razón principal que OpenAI pidió en un proyecto separado a la compañía que recopilara imágenes de índole sexual o violenta para ayudar a sus herramientas de IA a que fueran más seguras. Según la documentación recabada por Time, Sama llegó a entregar un lote de 1.400 imágenes, algunas clasificadas en base el sistema de etiquetado interno de OpenAI como C4, referente a contenido de abuso sexual infantil.