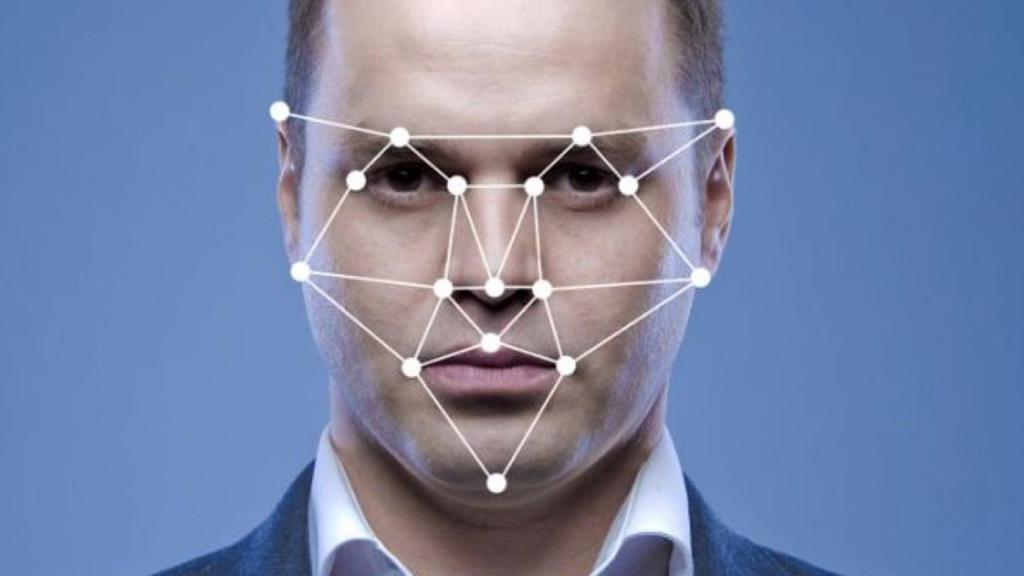

Una representación de la inteligencia artificial.

Microsoft retirará una polémica herramienta de reconocimiento facial que detecta emociones

Una investigación interna de la compañía había determinado que había cuestiones muy importantes a resolver con respecto a este software.

Hace poco saltaba la polémica. Un ingeniero de Google era despedido después de afirmar que el modelo LaMDA de inteligencia artificial con el que estaba trabajando había conseguido consciencia, convirtiéndose en un ser sintiente. Esto abrió la puerta a que muchos consideraran las implicaciones morales y éticas de la implementación de la IA en cuestiones humanas como los sentimientos. La polémica vuelve a saltar, esta vez involucrando a Microsoft.

[Así funciona Clearview, el polémico reconocimiento facial que usa Ucrania para identificar rusos]

Y es que según detalla The Verge, Microsoft está impidiendo el acceso público a un set de herramientas de reconocimiento facial y análisis facial basada en inteligencia artificial. La clave es que en este set estaban presentes herramientas de identificación de emociones de sujetos a partir del multimedia.

La compañía de Redmond ha estado eliminando el acceso público a este set de herramientas, limitando el acceso a algunas de sus funciones específicas. No obstante, otras quedarán eliminadas por completo, dando la opción a los usuarios a que puedan solicitar el uso de Azure Face, un servicio de reconocimiento facial explicándoles cómo exactamente implementarán esta tecnología.

Microsoft y la IA

Microsoft asegura que el acceso a nuevos clientes a estas herramientas se terminó el día 21 de junio. Los clientes ya existentes verán su acceso revocado el 30 de junio de 2023, y aunque parece que esto implique su final, Microsoft asegura que seguirá usando estas funciones en algunos productos. Un ejemplo es Seeing AI, una app que usará la visión con inteligencia artificial para describir el entorno a personas con discapacidad visual.

Pero ¿por qué ocurre esto? Según Microsoft, esto es parte de una revisión más concienzuda de las políticas de ética respecto a IA de la compañía. Estos estándares, conocidos como Responsible AI Standards redactados en el año 2019 especifica la necesidad de rastrear qué agentes usan sus servicios de IA y establece que se necesita una mayor supervisión sobre la aplicación de estas herramientas. Ya en 2020 Microsoft se comprometió a no vender estos sistemas a departamentos de policía hasta que se estableciera una regulación legislativa.

Inteligencia artificial.

La clave la da Natasha Crampton, directora responsable de IA en Microsoft. Detalla cómo los expertos han resaltado "la falta de consenso científico sobre la definición de 'emociones', los desafíos en cómo las interferencias se generalizan entre casos de uso, regiones y datos demográficos y la mayor preocupación por la privacidad en torno a este tipo de capacidad".

Según explica Sarah Bird, directora y gerente de producto en la unidad Azure de Microsoft, se hace referencia a los trabajos tanto internos como externos con investigadores para desarrollar un estándar que usase esta tecnología y que se encontraron problemas de confiabilidad.

Reconocimiento facial

"Estos esfuerzos plantearon preguntas importantes sobre la privacidad, la falta de consenso sobre una definición de emociones y la incapacidad de generar el vínculo entre la expresión facial y el estado emocional en casos de uso, regiones y datos demográficos", asegura Bird.

Reconocer emociones

Y es que las herramientas de reconocimiento de 'emociones' basadas en IA han sido objeto de escrutinio por parte de los expertos. Las expresiones faciales son tremendamente subjetivas, incluso las establecidas como universales y pueden cambiar enormemente entre diferentes culturas y poblaciones.

Algunos de hecho llegan a dejar claro que mantener en un mismo status las manifestaciones externas de emociones y los sentimientos intrínsecos de los humanos ni siquiera es algo científico. Todo ello sin contar cómo los sistemas de reconocimiento facial han errado en el pasado identificando de manera desproporcionada a mujeres y personas con tonos de piel más oscuros, generando incluso polémicas de todo tipo.

Reconocimiento facial.

De hecho, esta clase de tecnología ya ha sido usada con anterioridad, por ejemplo en entornos laborales, para determinar en entrevistas de trabajo las emociones de una persona. Estos sistemas han sido criticados debido a que los sistemas de reconocimiento facial se entrenan en bases de datos predominantemente blancas y masculinas, generando un posible sesgo.