Cuatro chicas disfrazadas de Transformers en la BotCon 2011. Flickr

El primer concurso de belleza juzgado por robots supremacistas acaba en polémica

El algoritmo puntuó más alto a personas con la piel clara, por lo que apenas había representación de personas de color entre los ganadores.

Noticias relacionadas

El objetivo del primer concurso de belleza Beauty.AI era, precisamente, evaluar la belleza de los candidatos con un criterio objetivo, el de tres algoritmos. Uno evaluaría la simetría, otro el envejecimiento y el último, apodado MADIS, es una especie de asistente informático para encontrar modelos potenciales. De los resultados se deduce que los algoritmos las prefieren rubias o, al menos, con la piel clara.

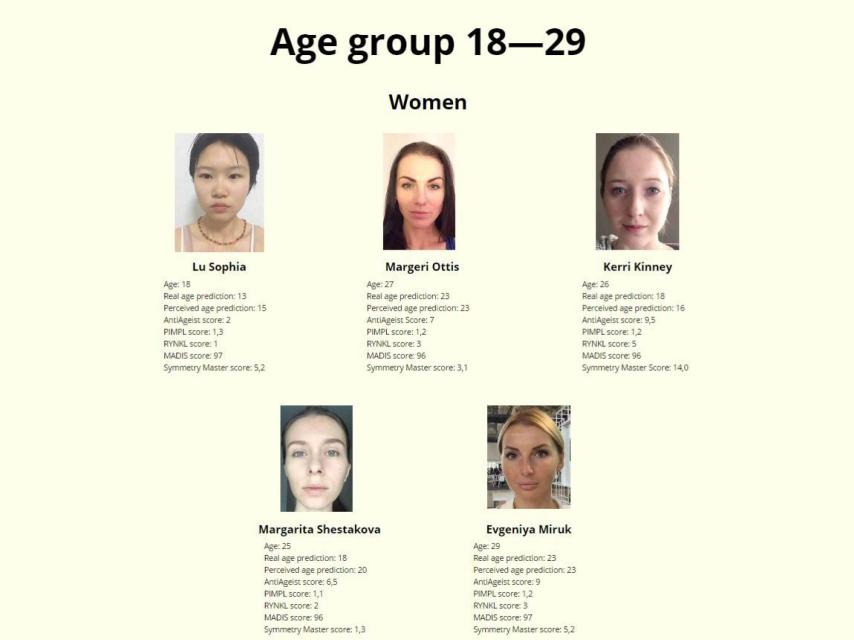

Ganadoras del concurso entre 18 y 29 años.

Sheri Eastman tiene 46 años y es profesora de matemáticas en Upper Marlboro, Maryland. Cuando los robots hereden la Tierra, ella será aclamada como la mujer de color más atractiva del planeta a juzgar por el hecho de que es la única de esta raza entre los 44 ganadores del concurso, separados en categorías por género y edad.

¿Fue un problema de sesgo? El resultado sorprendió a los organizadores del concurso, al que se presentaron 6.000 personas de 100 países, incluidos muchos de África y Asia. Lo único que hacía falta era sacarse un selfie y enviarlo. El director científico del proyecto, Alex Zhavoronkov, contó a The Guardian que el problema es que los datos no incluían a suficientes minorías. "Cuando estás entrenando un algoritmo para reconocer distintos patrones, puede que no tengas suficientes datos, o que éstos estén sesgados".

De nuevo, Microsoft

El proyecto Beauty.AI está, para más inri, apoyado por Microsoft, que hace unos meses ya tuvo problemas con la inteligencia artificial al lanzar un robot de conversación en Twitter que acabó tomando tintes racistas al interpretar de buena fe las cosas que muchos trolls le decían.

Una investigación de ProPublica ya demostró que un software empleado para estudiar a futuros criminales solía señalar más a los afroamericanos que a otras razas. En este caso, los creadores de los algoritmos no les ordenaron tratar la piel clara como un signo inequívoco de belleza, aunque el tipo de datos que recibieron llevaron a los robóticos jueces a esa conclusión.

Una nueva ocasión para recordar que, tras un algoritmo al que se pretende dotar de neutralidad y objetividad científica, lo que hay son seres humanos pensando y, a veces, equivocándose.