Fotomontaje inspirado en X

La IA se integra en las polémicas Notas de la comunidad de X: "LLMs y humanos pueden colaborar en un bucle virtuoso"

Comienza el programa piloto para usar Grok o IAs de terceros como ChatGPT durante unas semanas antes de su despliegue general.

Más información: El Twitter de siempre cancela una de las peores decisiones de Elon Musk: así es la marca azul de Bluesky y cómo funciona

Las Notas de Comunidad de X sirvieron como fuente de inspiración a Meta a primeros de año, y la red social vuelve a la carga con un programa piloto en el que los chatbots IA van a generar esas notas que corrigen o dan contexto a contenidos y tuits.

Esta funcionalidad se integró en 2021 y en 2022 se desplegó en Twitter, para que Elon Musk la expandiera en la plataforma bajo su mandato, a la que ahora todos conocemos como X.

Los usuarios que forman parte de este programa de fact checking pueden contribuir con comentarios que añaden contexto a ciertas publicaciones, que son revisados por otros usuarios antes de aparecer adheridas a la publicación o tuit.

Es una herramienta colaborativa de moderación de contenidos para evitar la desinformación en las redes sociales (Meta eliminó su fact checking de terceros para incorporarla), y que en su esencia es muy atractiva, pero que se abre a la manipulación si la comunidad no es diversa o rigurosa.

Una nota de comunidad puede aparecer bajo un vídeo para corregir realmente el origen del mismo. Y ya sabemos todos cómo de fácil es bajo el anonimato de un nombre de usuario lanzar bulos en una red social.

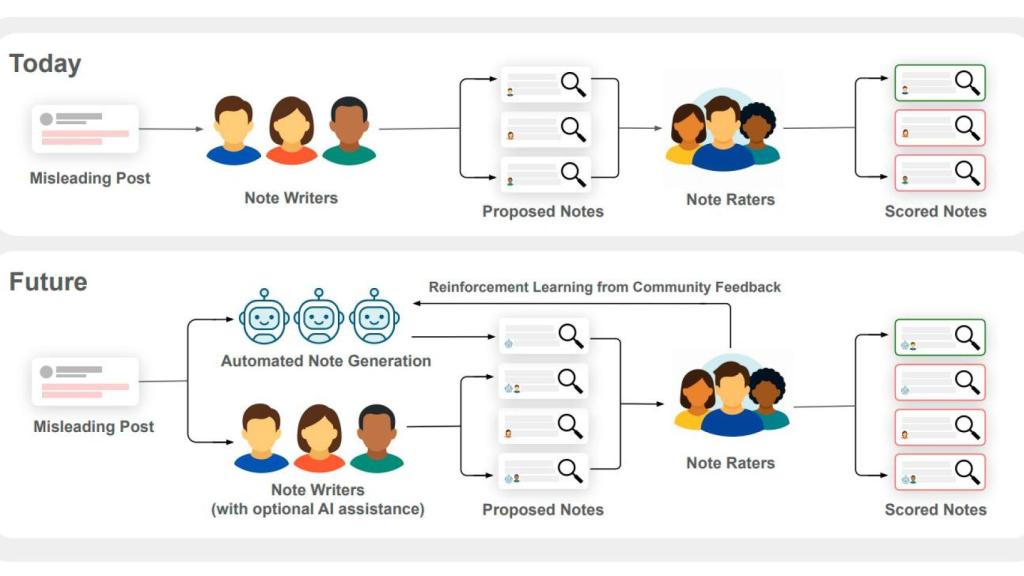

La comparación entre el modelo "todo humano" y el híbrido "humano-LLM"

Ahora llega la IA a las Notas de la comunidad y emergen las dudas sobre si su uso va a ser positivo o dañino, y más en un momento en el que las redes sociales, lejos de su esencia, han polarizado a la sociedad a niveles inauditos.

Las notas con IA pueden ser generadas, según TechCrunch, al usar Grok de X o con otras herramientas IA al conectarlas a través de una API. Cualquier nota presentada por la IA será tratada como si lo hubiera hecho una persona, así que entra en el mismo proceso de verificación.

El problema del uso de la IA es que puede alucinar (inventarse cosas) o basarse en un contexto que no esté basado en la realidad.

Según un artículo publicado por los investigadores que trabajan en las Notas de comunidad en X, se recomienda que tanto las personas como los chatbots IA funcionen en conjunto.

La combinación de ambas fuerzas puede mejorar la generación de notas con IA a través del aprendizaje de refuerzo, y que las personas sean las que verifican antes de que sea publicada la nota.

El artículo deja una frase interesante: "El objetivo no es crear un asistente IA que diga a los usuarios que han de pensar, pero sí crear un ecosistema que ayude a los humanos a pensar más críticamente y entender el mundo de una mejor forma. LLMs (Modelo de Lenguaje Mayor) y humanos pueden colaborar juntos en un bucle virtuoso".

Aparte de la posibilidad de que la IA "alucine", hay otro serio problema que ha estado sufriendo últimamente OpenAI con ChatGPT, y que tiene que ver con su "personalidad": se vuelve sicofanta. Que no es otra cosa que un comportamiento servil o adulador.

Si un LLM prioriza la ayuda al completar un fact checking, las notas generadas por la IA pueden ser totalmente imprecisas, ya que para poder moderar efectivamente hay una clave siempre importante, la neutralidad. Y volverse adulador no ayuda para nada si se opta por IA de terceros como sería ChatGPT que puede llegar a tener esa personalidad.

De momento, es un programa piloto y se espera que dure unas cuantas semanas antes de que se despliegue de forma general para que la IA en combinación con los humanos ayude a mitigar el efecto de desinformación que campa a sus anchas en X.