Logos de Siri y OpenAI fundidos en un fotomontaje. Omicrono

La IA de Apple es más potente que ChatGPT: Siri entenderá el contexto analizando los datos del iPhone

En un nuevo paper, investigadores de la compañía dan a conocer un nuevo sistema apodado 'ReALM' que rivaliza con los modelos de OpenAI.

Apple lleva ya varios meses intentando adentrarse en la carrera de la inteligencia artificial. En España ya han aparecido varios rumores y papers que resaltan sus avances, con modelos como MM1 capaces de revolucionar el entrenamiento de los respectivos modelos LLM de las grandes empresas. Ahora, los investigadores de Apple han publicado un nuevo artículo con ReALM, un modelo capaz de entender y manejar distintos tipos de contextos.

Así lo recoge el medio BGR, citando el paper firmado por investigadores de Apple como Joel Ruben Antony Moniz, actual ingeniero de machine learning en la compañía de Cupertino. La idea detrás de ReALM y del nuevo artículo de la compañía es la de "resolver referencias de varios tipos" mediante sistemas eficaces creados a partir de modelos de lenguaje grandes o LLM (Large Language Model).

El artículo va más allá, explicando que su modelo es prácticamente equivalente a los modelos de OpenAI GPT 3.5 y GPT-4 en sus versiones más pequeñas; llegan a afirmar que sus modelos más grandes superan "sustancialmente" a GPT-4, el modelo más potente de la compañía a fecha de escrito este artículo, titulado "ReALM: Reference Resolution As Language Modeling".

El nuevo modelo ReALM de Apple

El propósito de este nuevo modelo de IA se basa en la resolución de referencias en un problema, con el objetivo final de comprender y manejar contextos de distintos tipos. Los investigadores creen que si bien los LLM han demostrado una potencia sin par en una buena variedad de tareas, "su uso en la resolución de referencias, particularmente para entidades no conversacionales, sigue estando infrautilizado".

Más concretamente, Apple define estas referencias y entidades como un contexto que pertenece a "entidades no conversacionales, como entidades en la pantalla del usuario o aquellas que se ejecutan en segundo plano". ReALM abre la puerta al uso de los LLM para crear "un sistema extremadamente eficaz para resolver referencias de varios tipos", dado que esta resolución de referencias puede resultar en un quebradero de cabeza para los modelos LLM.

ChatGPT en un montaje fotográfico. Reuters

ReALM, por ende, presenta grandes mejoras con respecto a los sistemas actuales que cuentan con funcionalidades similares en referencias de distinta índole. "Nuestro modelo más pequeño obtuvo ganancias absolutas de más del 5% para referencias en pantalla [...] Realizamos comparaciones con GPT-3.5 y GPT-4; nuestro modelo más pequeño logra un rendimiento comparable al de GPT-4 y nuestros modelos más grandes lo superan sustancialmente", reza el paper.

Y es que a juicio de los investigadores, el habla humana contiene una serie de referencias que entran en la categoría de ambiguas; unos buenos ejemplos serían "ellos" o "eso", cuyo significado puede ser obvio para los humanos dependiendo el contexto. Este es el problema; los LLM pueden tener dificultades para comprender o completar consultas de usuarios al no poder usar y comprender el contexto de las mismas.

[Apple estaría probando hasta cuatro modelos de IA para preparar su revolución para Siri]

"Ser capaz de comprender el contexto, inluidas referencias como estas, es esencial para un asistente conversacional que tiene como objetivo permitir que un usuario comunique de forma natural sus requisitos a un agente o tenga una conversación con él", relatan los investigadores. Es aquí donde ReALM brilla, ya que puede comprender y manejar con éxito varios tipos de contextos distintos, dando así una respuesta mucho más acertada.

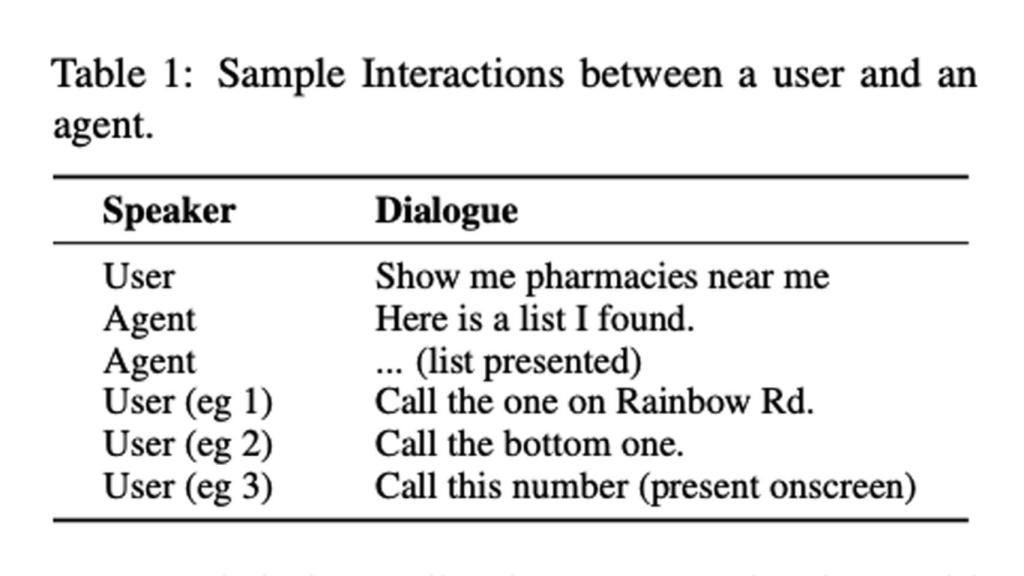

Apple, a través de este paper, relata cómo podrían usar ReALM para un buen abanico de entidades. Por ejemplo, las entidades en pantalla, que son las que se muestran en la pantalla del usuario. También están las entidades conversacionales, las cuales son relevantes para el usuario. Estas entidades pueden ser complicadas, ya que pueden provenir de un turno anterior del usuario ("llamar a Mamá", por ejemplo) o de un asistente virtual (cuando por ejemplo un 'agente' proporciona listas de lugares o elecciones, como un listado de alarmas).

Tabla con interacciones entre un usuario y el agente ReALM. Omicrono

Finalmente están las entidades de fondo, entidades relevantes que provienen directamente de procesos en segundo plano que no pueden ser parte directa necesariamente hablando de lo que el usuario ve en su pantalla o de su interacción con el agente virtual. En este caso, un ejemplo sería la alarma que comienza a sonar, o la música que se reproduce de fondo.

Las comparaciones que realiza Apple con los modelos de OpenAI son claros y demoledores. Apple adaptó sus pruebas para los dos tipos de modelos, ya que por ejemplo GPT-3.5 solo acepta texto, mientras que GPT-4 también puede contextualizar imágenes. En el primero, Apple adaptó su entrada para que se basara solo en mensajes; en el segundo, proporcionaron a ReALM "una captura de pantalla para la tarea de resolución de referencia en pantalla".

[Apple estaría preparando una App Store centrada en la IA: así sería su 'golpe' a ChatGPT]

No obstante, desde el paper los investigadores admiten que aún queda mucho trabajo por realizar. "Nuestra formulación de prompt de ChatGPT y prompt+image es, hasta donde sabemos, novedosa en sí misma. Si bien creemos que podría ser posible mejorar aún más los resultados, por ejemplo, tomando muestras de expresiones semánticicamente similares hasta alcanzar la longitud del mensaje, este enfoque más complejo merece una exploración más profunda y dedicada, y lo dejamos para trabajos futuros", explican los expertos.