Fotomontaje del logo de OpenAI con Tim Cook, CEO de Apple. Omicrono

Así es MM1, la IA de Apple que revolucionará la forma de entrenar los modelos de las grandes empresas

El método, publicado en un artículo de investigación, pretende conseguir sistemas de inteligencia artificial más versátiles y adaptables.

Tras la revolución vivida en España y en el resto del mundo sobre la inteligencia artificial, prácticamente todas las empresas se han volcado en ellas. Una de las rezagadas en este sentido ha sido Apple, y la compañía ha estado estos últimos meses intentando enmendar su error. De cara a un volcado total de Apple hacia la IA generativa, los de Cupertino han publicado un artículo de investigación para el entrenamiento de modelos de lenguaje grandes o LLM.

Un artículo de investigación firmado por investigadores de la empresa californiana habla de un nuevo enfoque para entrenar modelos de lenguaje grandes, que permitan la creación de sistemas de inteligencia artificial más inteligentes y más versátiles. En este artículo, titulado MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training, abre la puerta al uso de etiquetas y datos generados por IA para acelerar el entrenamiento de estos modelos.

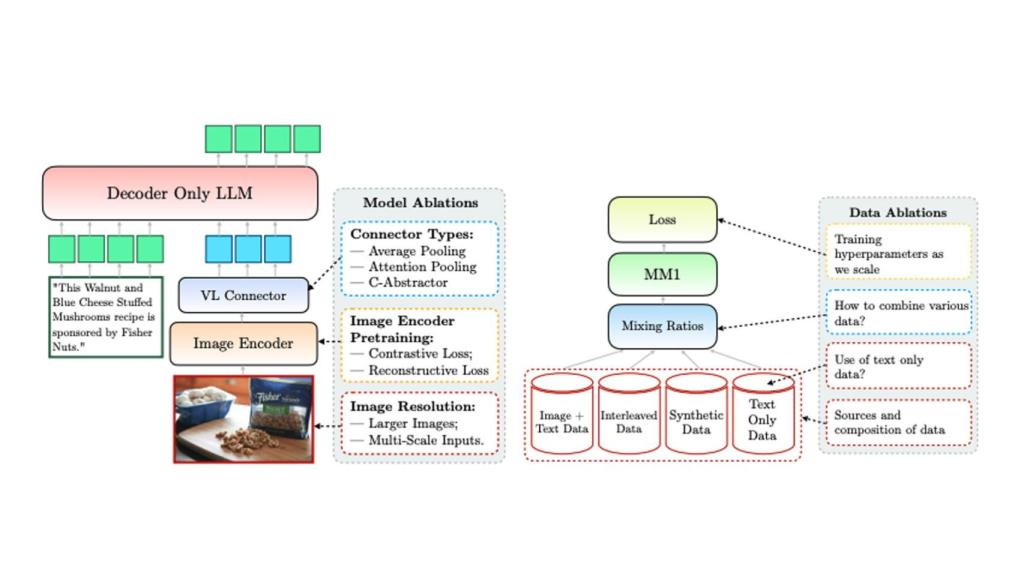

MM1, generalmente, es un nuevo método pensado para entrenar modelos multimodales, el cual aprovecha datos sintéticos que incluyen datos de distinta índole, tales como datos entrelazados, datos sintéticos o datos de imágenes y texto. Según los investigadores, dicho nuevo método sobre el papel no solo acelera el rendimiento del preentrenamiento como tal de los LLM, sino que reduce la cantidad de prompts de seguimiento necesarios para obtener resultados concretos.

Un nuevo método para entrenar IA

Lo que pretende esta nueva metodología propuesta por Apple es usar un conjunto de datos ampliamente diverso, que incluye pares de imágenes y subtítulos, documentos unidos de imagen y texto y datos que constan únicamente de texto. Apple especifica que MM1 establece un nuevo estándar para potenciar la capacidad de la IA de hacer ciertas tareas, como subtitular imágenes o proporcionar respuestas visuales a preguntas, entre otros.

En palabras de los investigadores de Apple, esta metodología demuestra que "para el preentrenamiento multimodal a gran escala, el uso de una combinación cuidadosa de datos de imagen-texto, imagen-texto intercalado y solo texto es crucial para lograr resultados de última generación en pocas tomas en múltiples puntos de referencia".

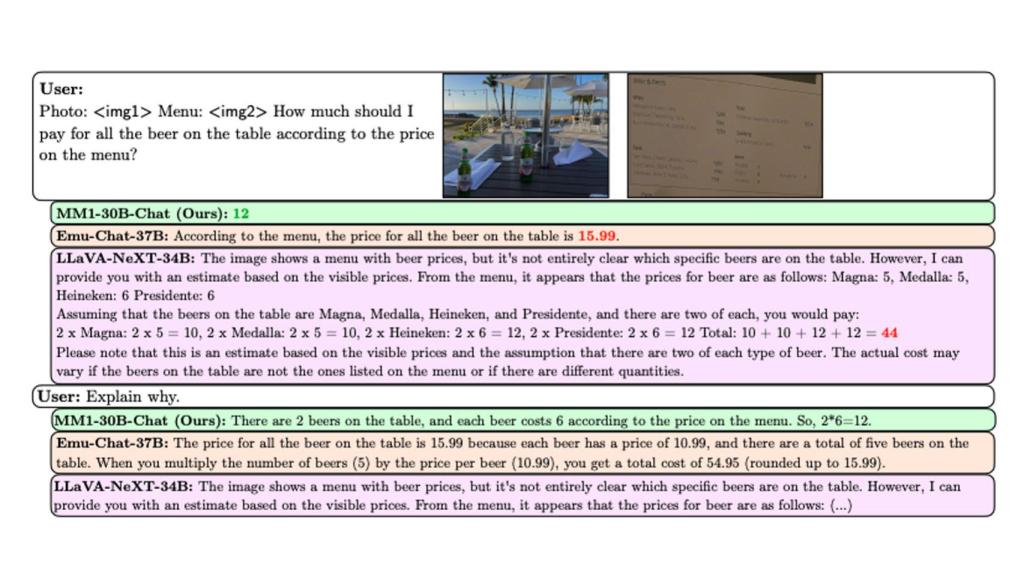

Figura de cómo MM1 puede seguir instrucciones y razonar sobre imágenes. Omicrono

El paper describe a MM1 como una familia de modelos multimodales, que admite en su configuración más elevada hasta 30.000 millones de parámetros, consiguiendo un rendimiento "competitivo [...] en una variedad de puntos de referencia multimodales establecidos". La clave de este modelo estaría en la visión o más concretamente en el análisis de imágenes, así como en otras formas de contenido visual y la capacidad de comprender el resultado de los mismos.

Lo que ha conseguido Apple con MM1 es agregar a estos modelos la capacidad de comprender y generar lenguaje por 'visión', gracias a la inclusión de aspectos como codificadores de imágenes. En sus pruebas, el equipo de Apple descubrió que agregando una combinación de conjuntos de datos de imágenes y texto, datos entrelazados, sintéticos y datos solo de texto, MM1 lograba arrojar resultados comparables a los que otorgan modelos LLM actuales en fase de preentrenamiento.

[El lanzamiento de los nuevos iPad es inminente: podría llegar durante Semana Santa]

Y es que la investigación de Apple focaliza sus avances en la combinación de una serie de tipos de datos de entrenamiento y arquitecturas de modelos, permitiendo a la IA comprender y generar lenguaje basado en una combinación de señales visuales y lingüísticas. Una funcionalidad que es clave para tareas que requieran una comprensión más matizada del mundo actual; algunos ejemplos incluyen interpretar imágenes de amplia complejidad o responder preguntas con elementos visuales.

Otro punto a destacar de esta versión de MM1 radica en su capacidad de razonamiento multi-paso sobre imágenes múltiples. Para ello usa una metodología de prompts llamada "cadena de pensamiento" o chain-of-thought; gracias a ella, la IA puede resolver todo tipo de problemas complejos y abiertos que estén basados en un conjunto mínimo de ejemplos, tal y como expone MacRumors.

Esquema de funcionamiento del modelo. Omicrono

El resumen de la investigación llevada a cabo por Apple es que esta metodología revoluciona el proceso de preentrenamiento en el que actualmente se sitúan los modelos de lenguaje grandes, o LLM. Esta etapa implica la configuración del flujo de trabajo y el procesamiento de datos del propio modelo; en esta fase, además, se considera que los LLM no están entrenados lo suficiente como para proporcionar resultados exactos deseados.

Una noticia que aparece en un momento en el que Apple está volcando todos sus esfuerzos en el mercado de la inteligencia artificial. Tanto es así que los últimos rumores apuntan a un acuerdo entre Apple y Google para llevar la IA Gemini a los iPhone, con la idea de impulsar funciones de inteligencia artificial que llegarían a iOS 18 en la WWDC 2024.