Ilustración del logo de OpenAI. Omicrono

Llega GPT-4, el nuevo modelo de IA que ahora opera como un humano y entiende imágenes

El modelo multimodal ya está accesible para los usuarios de ChatGPT Plus. Reduce sus 'alucinaciones' y mejora su creatividad, además de su seguridad.

14 marzo, 2023 20:53La revolución que han supuesto los modelos lingüísticos basados en inteligencia artificial como ChatGPT, potenciado con la tecnología GPT-3 de OpenAI, está aún por determinar. No solo ha provocado que los cimientos de Google se tambaleen, sino que amenaza con causar un auténtico cambio en todo tipo de aspectos laborales e industriales de todo el mundo. Ahora, OpenAI ha presentado la última innovación en este sentido: GPT-4.

GPT-4 es el sucesor del modelo de inteligencia artificial generativa que puede generar texto escrito. Más concretamente, es un modelo de aprendizaje autorregresivo que busca generar textos similares a los que escribiría un usuario. GPT-3, sin ir más lejos, forma parte del Procesamiento de Lenguaje Natural, una rama dentro de la IA generativa que busca mejorar los mecanismos de comunicación entre personas y máquinas.

Por ende, GPT-4 es una versión más pulida de GPT-3 y 3.5, que era hasta el momento eran los modelos que estaban dando vida a varios de los proyectos de OpenAI, como ChatGPT. Algunos de los titulares que arroja esta nueva versión es que se aumenta la creatividad y sobre todo se reduce el descontrol del modelo, algo que se ha visto reflejado en las últimas versiones del Bing con IA recientemente lanzado por Microsoft. No obstante, una de sus mejores ventajas es que ahora entiende las entradas de texto e imágenes.

Llega GPT-4

GPT-4 es el último gran modelo multimodal de OpenAI, que puede aceptar entradas no solo de texto, sino de imágenes. OpenAI, en su comunicado, habla de un rendimiento "a nivel humano" en ciertos apartados clave referentes al mundo académico y profesional. GPT-3.5, el predecesor de GPT-4, fue entrenado como una primera prueba durante un año para un superordenador codiseñado desde 0 gracias a la reconstrucción de toda la pila de aprendizaje profundo de la compañía. Un proceso que ha durado 2 años.

Gracias a estos avances, OpenAI asegura que los ejercicios de entrenamiento de GPT-4 son tremendamente estables, convirtiéndose en el primer modelo grande de la firma "cuyo rendimiento pudimos predecir con anticipación". La compañía está lanzando GPT-4 a través de ChatGPT y la API del modelo, para fomentar su adopción entre usuarios y desarrolladores.

Logo de ChatGPT junto a una ilustración. Omicrono

OpenAI asegura que las diferencias entre 3.5 y 4 pueden ser sutiles, pero palpables. Hablamos de que GPT-4 es más confiable, "creativo" y sobre todo mucho más capaz de manejar instrucciones matizadas que GPT-3.5, uno de los puntos de discordia entre los usuarios. Recordemos, de nuevo, las respuestas desquiciadas de Bing AI.

GPT-4 fue entrenado para predecir la siguiente palabra en un documento y se entrenó usando datos de dominio público, así como datos licenciados por la compañía. El conjunto de datos a escala web incluye soluciones correctas e incorrectas a problemas matemáticos, razonamientos débiles y fuertes, afirmaciones autocontradictorias y consistentes "y una gran variedad de ideologías". En definitiva, tiene un nivel de operatibilidad similar al de un humano.

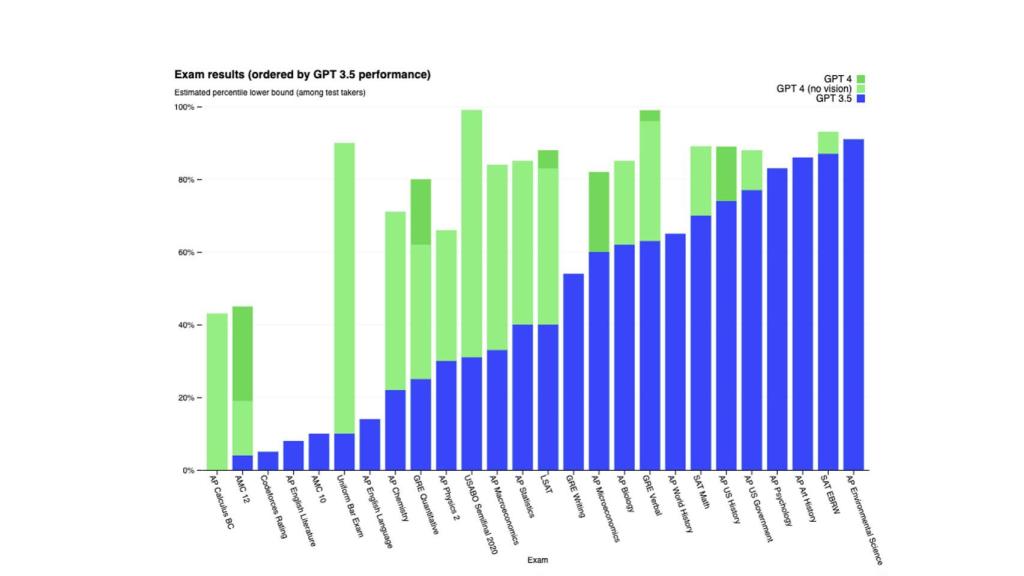

Resultados de los exámenes ordenados por el rendimiento de GPT-3.5. Omicrono

Para comprobar la evolución ente ambos modelos, usaron una variedad bastante amplia de puntos de referencia, incluyendo entre otras simulación de exámenes diseñados para humanos. Usaron las pruebas disponibles de forma pública más recientes además de comprar las ediciones más nuevas de los exámenes de práctica. Todo ello sin práctica o entrenamiento específico para estos exámenes.

GPT-4 fue capaz de detectar una "minoría de los problemas en los exámenes durante el entrenamiento", algo que puede ser representativo para los resultados. También evaluaron GPT-4 en puntos de referencia tradicionales, ya diseñados para modelos de aprendizaje automáticos estandarizados. Así, GPT-4 supera ampliamente a los modelos ya existentes, incluyendo la mayoría de modelos de última generación.

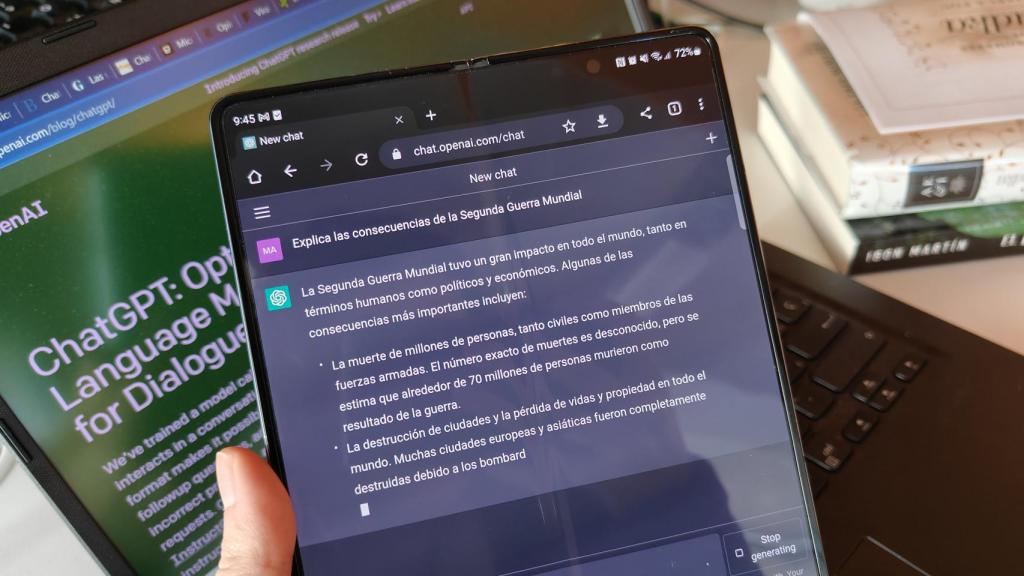

ChatGPT enseñando historia Omicrono

Tanto es así, que OpenAI explica que se ha estado usando GPT-4 de forma interna, con un gran impacto en funciones como soporte, ventas, moderación de contenido y programación. De hecho, ha sido usado para ayudar a operarios humanos a evaluar los resultados de la propia IA.

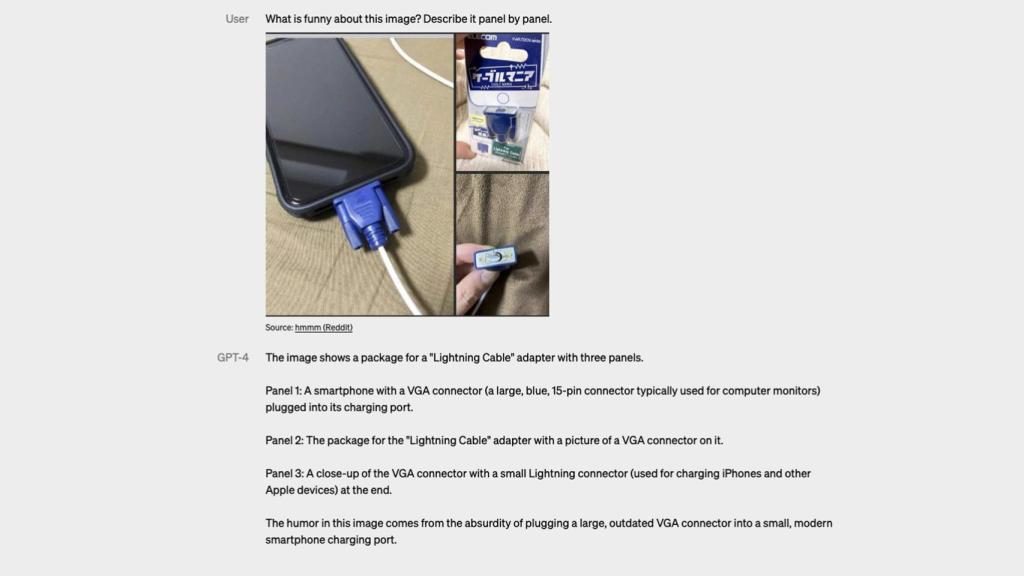

GPT-4 puede generar salidas de texto como lenguaje natural o código gracias a la aceptación de indicaciones de texto e imágenes, que permiten al usuario especificar cualquier tarea de visión o idioma. "En una variedad de dominios, incluidos documentos con texto y fotografías, diagramas o capturas de pantalla, GPT-4 exhibe capacidades similares a las de las entradas de un solo texto".

Transcripción de una conversación para testear las entradas visuales. Omicrono

OpenAI también ha revisado la definición del comportamiento de la inteligencia artificial, incluyendo "la capacidad de dirección". Y es que en lugar de la personalidad clásica de ChatGPT (limitada a una verbosidad, tono y estilos fijos), los desarrolladores así como los usuarios de ChatGPT podrán prescribir el estilo y tarea de la IA describiendo estas instrucciones en el mensaje del sistema. Estos mensajes permiten a los usuarios de la API personalizar "significativamente" la experiencia de los usuarios dentro de esos límites.

Aspectos a tener en cuenta

La compañía ha querido dejar claro que GPT-4, al igual que otros tantos modelos (incluyendo sus predecesores), tiene limitaciones. Por ejemplo, sigue volviéndose un poco loca, ya que "alucina" los hechos y "comete errores de razonamiento". La firma advierte que hay que tener cuidado al usar los resultados del modelo de lenguaje, particularmente en contextos "de alto riesgo".

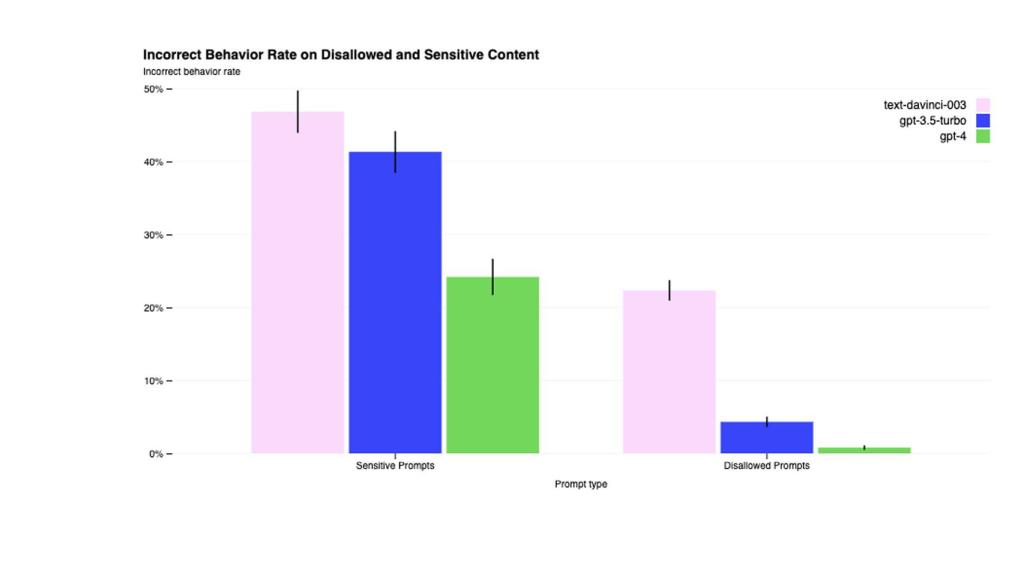

Tasa de comportamiento incorrecto en contenido confidencial y no permitido Omicrono

Aún con problemas, GPT-4 "reduce significativamente las alucinaciones en relación con los modelos anteriores". De esta forma, ha obtenido puntuaciones hasta un 40% más altas que GPT-3.5 en las pruebas internas de factualidad contradictoria. Eso no quita el hecho de que el modelo puede arrojar resultados sesgados, ya que según OpenAI, "hemos avanzado en estos [sesgos], pero aún queda más por hacer".

Esto tiene una explicación. GPT-4 carece de conocimiento de los eventos ocurridos después de septiembre de 2021, momento en la que la mayoría de sus datos se cortaron. Además, puede cometer "errores de razonamiento simples", que no parecen corresponder con la competencia en ciertos dominios. O también puede ser, según OpenAI, que el modelo "pueda ser demasiado crédulo al aceptar declaraciones falsas obvias de un usuario".

Fotomontaje con una imagen de una IA y con el logo de OpenAI. iStock | Omicrono

Por ende, las equivocaciones de GPT-4 pueden seguir vigentes. "A veces puede fallar en problemas difíciles de la misma manera en la que lo hacen los humanos, como introducir vulnerabilidades de seguridad en el código que produce". Y sí, esto incluye en sus predicciones, ya que se puede equivocar "sin tener cuidado de verificar el trabajo cuando es probable que cometa un error".

Adicionalmente, OpenAI se ha asegurado de hacer que este modelo sea más seguro, con esfuerzos "que incluyen la selección y el filtrado de los datos previos a la capacitación, las evaluaciones y la participación de expertos, las mejoras de seguridad del modelo y el monitoreo y la aplicación".

[El lado oscuro de ChatGPT: trabajadores explotados en África que cobran 1 euro por hora]

La seguridad que menciona OpenAi se basa en los potenciales daños que el modelo pueda ocasionar, como generar consejos dañinos, código con errores o desinformación. Para intentar mitigar estos problemas, OpenAI contrató a más de 50 expertos en dominios como ciberseguridad, riesgo biológico o seguridad internacional. De esta forma, recopilaron datos adicionales para, por ejemplo, mejorar la capacidad de GPT-4 para echazar solicitudes sobre cómo sintetizar sustancias químicas peligrosas.

Según OpenAI, las mitigaciones han mejorado significativamente las propiedades de seguridad del modelo en comparación con GPT-3.5, disminuyendo drásticamente "la tendencia del modelo a responder a solicitudes de contenido no permitido en un 82%". GPT-4 responde a solicitudes confidenciales (consejos médicos, autolesiones...) de acuerdo con las políticas de OpenAI, un 29% más frecuentemente. Aún así, existen formas de generar contenido problemático con ciertas metodologías.

ChatGPT Plus

Los suscriptores de la modalidad de pago de OpenAI, ChatGPT Plus podrán acceder directamente a GPT-4 con un límite de uso en este enlace. Se ajustará el límite de uso exacto "según la demanda y el rendimiento del sistema en la práctica". Advierten, por otro lado, que tendrán una capacidad "muy limitada", que se ampliará con el paso de los meses.

ChatGPT enseñando historia Omicrono

Para acceder a la API de GPT-4, será necesario registrarse en una lista de espera. Se empezará a invitar a algunos desarrolladores desde hoy mismo, e irá escalando gradualmente para balancear la capacidad con la demanda. Una vez con acceso, el desarrollador podrá hacer peticiones solo de texto al modelo por el momento.