Estudio del cerebro Omicrono

Esta inteligencia artificial recrea tus sueños en tiempo real: el avance para unir cerebro y máquina

Un estudio consigue generar vídeos de gran calidad recreados al analizar la actividad cerebral mientras los participantes veían la televisión.

4 junio, 2023 02:22Si hace un año la capacidad de crear un vídeo realista partiendo de una simple frase podría sorprender a muchos en España y el resto del mundo, la idea de generar imágenes con la mente traspasa la ciencia ficción para presentar una realidad difícil de asimilar. Lo cierto es que, poco a poco, los avances en inteligencia artificial y la decodificación de la actividad cerebral están confluyendo para facilitar el estudio de la mente humana, además de sentar las bases de una comunicación entre mente y máquina que de paso a un mundo de cíborgs que ya adelantó el cine a su manera.

Los investigadores de la Universidad Nacional de Singapur y la Universidad China de Hong Kong han utilizado modelos generativos de inteligencia artificial, herramientas capaces de crear imágenes desde cero, para reconstruir la actividad cerebral en vídeos de "alta calidad". Jiaxin Qing, Zijiao Chen y John Helen Zhou detallan en su informe las mejoras que han conseguido con respecto a estudios anteriores.

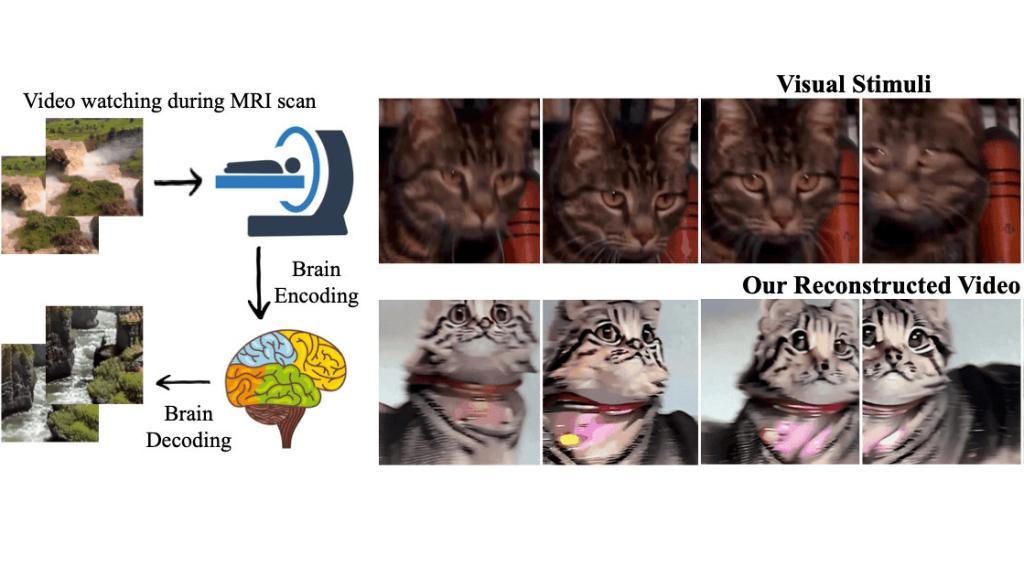

Así ha nacido Mind-Video, un sistema que transforma en GIFs lo que el cerebro está analizando, aunque sea un lindo gatito. Este proyecto ha obtenido mejores resultados y una comprensión más profunda de lo detallado en un trabajo anterior. En aquel estudio de la Universidad de Osaka, los investigadores descubrieron que podían reconstruir imágenes de alta resolución a partir de la actividad cerebral con una técnica que también usaba datos de resonancia magnética funcional y la IA Stable Diffusion.

[Stentrode, el implante cerebral que sirve para enviar mails con la mente y tratar el párkinson]

Así, este nuevo estudio supone un paso más en el camino que la comunidad científica está recorriendo para poder leer la mente humana a través de la inteligencia artificial o viceversa, controlar la tecnología sólo con el pensamiento. "Creemos que este campo tiene aplicaciones prometedoras a medida que se desarrollan grandes modelos, desde la neurociencia hasta las interfaces cerebro-computadora", han dicho los autores.

Recreando las ideas

Mind-Video surge de la combinación de datos de fMRI y el sistema de aprendizaje profundo Stable Diffusion. El fMRI es un proceso denominado resonancia magnética funcional y mide los pequeños cambios en el flujo sanguíneo que ocurren con la actividad del cerebro. En medicina se utiliza para detectar anomalías o evaluar los efectos de un derrame, por ejemplo. Aquí se ha usado para decodificar las señales generadas mientras una persona veía un vídeo, es decir, estudiar cómo analiza el cerebro las imágenes que vemos en un televisor.

Por su parte, Stable Diffusion es una de las grandes inteligencias artificiales generativas que han roto los esquemas que había sobre la capacidad de esta tecnología. Igual que otros modelos como DALL-E, Midjourney o Make-a-Video (Meta), puede crear imágenes desde cero partiendo de una simple descripción o input, también conocido como prompt. En este caso, la IA se ha modificado para que genere contenido utilizando los datos captados por fMRI.

🧵🧠 We're witnessing incredible scientific progress in image & text reconstruction from fMRI nowadays. But what about reconstructing video from fMRI? Allow me to introduce our recent preprint: Mind-Video https://t.co/VL2KXz8o9Khttps://t.co/KyNtsCxDIJhttps://t.co/bhjz0PDlS6 pic.twitter.com/3g9fmujSu3

— Zijiao Chen (@ZijiaoC) May 22, 2023

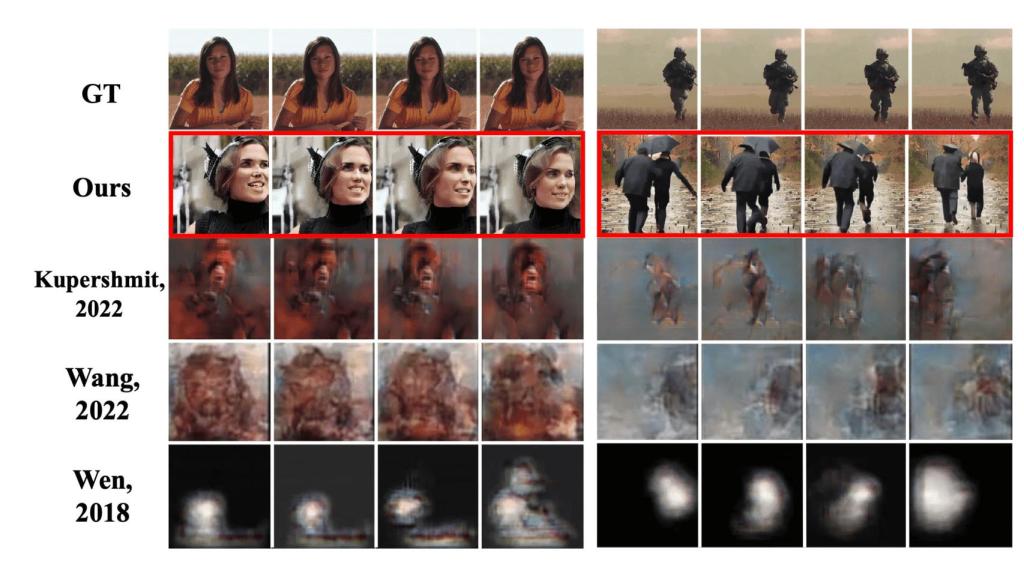

De esta forma, los participantes del experimento veían un sencillo vídeo de personas caminando por una calle y su cerebro se ponía a trabajar. Esa actividad daba como resultado un segundo vídeo similar creado por la IA. Así, se ha conseguido demostrar que lo obtenido se corresponde con la actividad cerebral del individuo. El contenido generado por inteligencia artificial muestra muchos paralelismos con los vídeos que los sujetos estaban viendo en la pantalla, desde la temática hasta los colores eran similares.

La muestra presentada es un gran número de imágenes en movimiento comparadas con el contenido original. Por ejemplo, en un lado se muestran caballos comiendo y, al lado, otro vídeo de peor calidad con caballos de un tono castaño similar. Las escenas de la derecha presentan una resolución característica del trabajo que ofrece actualmente Stable Diffusion, con saltos de frames constantes y poca definición, pero con formas y tonos que permiten reconocer el objeto o animal que se ha representado.

Resultados de Mind-Video Omicrono

Lo mismo ocurre con vídeos de personas hablando a cámara, andando por la calle o peces nadando en el mar. Los responsables del proyecto aseguran que los vídeos tenían una precisión del 85 %, una mejora con respecto a los enfoques anteriores. En otra imagen se puede ver a un hombre de avanzada edad andar por un parque junto a lo que parece ser un perro, mientras que en la escena generada de forma artificial se representa a dos personas acompañadas de una mascota. La representación no es idéntica, pero en todos los casos la esencia del vídeo se recrea de forma fiel.

Tras finalizar el experimento, los investigadores han identificado tres hallazgos relevantes. El primero se refiere al predominio de la corteza visual como componente importante para la percepción visual. En segundo lugar, está el codificador fMRI, el cual ha demostrado comenzar con información estructural y luego evolucionar a características más abstractas en capas más profundas. Este mismo sistema ha sido capaz de adquirir información más matizada a medida que se ha ido entrenando.

Comparativa de resultados entre proyectos anteriores y actual Omicrono

El equipo de investigación describe Mind-Video como una tubería de dos módulos diseñada para cerrar la brecha entre la decodificación cerebral de imágenes y vídeos. Ambos módulos se entrenan juntos para después converger en un mismo esfuerzo. El estudio reconoce haber encontrado algunas dificultades para obtener buenos resultados. Por ejemplo, el contenido se genera con retraso en comparación con la actividad neuronal, limitando el estudio en tiempo real de las respuestas cerebrales a diferentes estímulos.

Cerebro-máquina

Estos experimentos ofrecen una forma única de comprender cómo el cerebro representa el mundo e interpreta la conexión entre los modelos de visión por ordenador y nuestro sistema visual. Poder leer la mente, más allá de las dudas en cuanto a proteger la intimidad de cada persona, puede favorecer la comprensión de uno de los órganos más importantes y más desconocidos, además de mejorar el tratamiento de ciertas patologías, así como el análisis de los sueños.

No obstante, lejos de las mejoras médicas, esta tecnología abre la puerta a la creación de un lenguaje común entre el cerebro y las máquinas, una interfaz que permita al ser humano controlar la tecnología solo con el pensamiento. Pacientes con parálisis ya se están beneficiando de proyectos neuronales que han conseguido que escriban correos con la mente gracias a implantes.

¿Y si en el futuro pudiéramos visualizar un dibujo o un esquema y generarlo al momento en la pantalla del móvil para compartirlo con un amigo o un familiar? Es un ejemplo simple de algo que para muchas personas puede abrir todo un mundo de posibilidades, con una tecnología que puede incluso devolver la vista a las personas ciegas, como han sugerido algunos de los impulsores de proyectos relacionados.