Google Nest Hub de segunda generación Omicrono

Controla al Asistente de Google con la mirada: así funciona Look and Talk

El asistente analiza el tono de la voz, la postura corporal y la mirada entre otros detalles para reconocer la intención de la persona.

Aquellos usuarios que en España cuentan con el asistente virtual de Google en un altavoz en sus casas o en otros dispositivos, saben que para comenzar una conversación deben pronunciar las palabras mágicas "Ok, Google". Esta forma de activar el sistema podría empezar a desaparecer con Look and Talk (Mirar y hablar) una nueva técnica que la empresa está desarrollando para facilitar la comunicación.

[La nueva IA de Meta supera a Google Translate: traduce 200 idiomas en tiempo real]

La compañía aspira a que sus altavoces inteligentes puedan conversar con los usuarios de una forma más fluida, sin necesidad de claves o comandos. Para ello, además de mejorar la comprensión del lenguaje y los acentos por parte de su inteligencia artificial, explica que quiere entender las expresiones faciales y comunicación no verbal de las personas.

En la conferencia de desarrolladores Google I/O de 2022 presentó el proyecto Look and Talk que, de momento, funciona solo en Nest Hub Max y en inglés. En su blog técnico detalla cómo funciona esta nueva tecnología y cómo ha sido su creación para en el futuro hablar con las máquinas igual que con otras personas.

Mirar y hablar

Entre sus muchos programas para crear herramientas digitales accesibles para todas las personas con problemas de movilidad y del habla, Google lleva años trabajando en el reconocimiento de los gestos corporales y el tono de la voz. Así surgieron aplicaciones como Look to Speak, que ayuda a las personas a hablar y navegar por el teléfono con la mirada.

"En las conversaciones naturales no decimos los nombres de las personas cada vez que nos dirigimos a ellas", explican. La clave Ok, Google suena forzada en muchas ocasiones, pero sirve para activar la escucha del equipo y evitar que esté permanentemente analizando los que se dice en casa.

Google Look And Talk

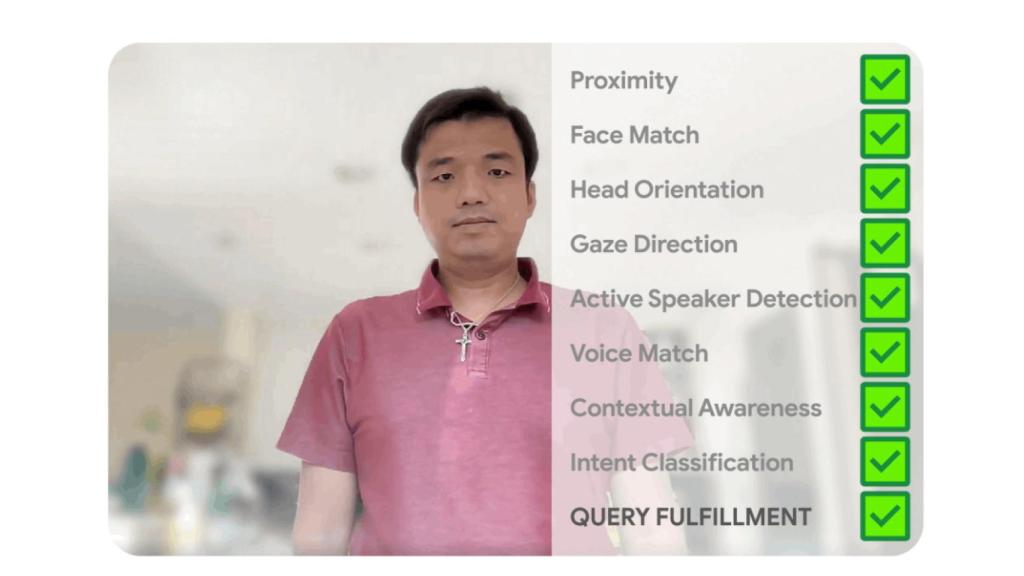

Con esta nueva tecnología la activación se realizaría al mirar directamente al dispositivo. El Google Nest Hub, por ejemplo, detectará la actitud y expresión de la persona que tiene delante que quiere entablar una conversación. Para ello se analiza la orientación de la cabeza, la mirada e incluso la dirección del cuerpo del sujeto.

Esa información se recoge en vídeo, por lo que el dispositivo debe contar con una cámara y colocarse en una posición óptima para ver la sala. A esto se suma el análisis del audio que recogen los micrófonos. El audio debe determinar que la persona habla con Google y no con otra persona de la habitación.

Look and Talk Omicrono

La voz debe coincidir con las que las de los miembros de la familia que el sistema ha registrado previamente, es decir, la función Voice Match que ya está en uso. Además, se estudia el tono de la voz, la velocidad y otras señales con las que entender que se trata de una consulta o petición.

Cuando todos estos parámetros coinciden y se entiende que el contexto y la intención son óptimos, el asistente se activa para escuchar las órdenes de su interlocutor. Resulta todo un avance que los altavoces inteligentes que empiezan a verse por todas las casas puedan, no solos comprender frases o conversaciones completas en voz alta, sino analizar los gestos, la comunicación no verbal.

Aunque esta novedad está limitada a un reducido número de dispositivos y solo en conversaciones en inglés, más adelante Google ampliará sus avances a otros idiomas y regiones. Su asistente funciona actualmente en 95 países y reconoce más de 29 idiomas.