Fotomontaje con una imagen de una IA y con el logo de OpenAI. iStock | Omicrono

España inicia la investigación contra ChatGPT por vulneración de la protección de datos

La Agencia Española de Protección de Datos ha anunciado que realizará de oficio una serie de actuaciones de investigación a la desarrolladora OpenAI.

13 abril, 2023 18:32Que ChatGPT está en el punto de mira no es ningún misterio. Países como Italia ya han decretado un bloqueo preventivo de la herramienta debido a preocupaciones en torno a cuestiones de privacidad y desinformación. Esto ha suscitado una oleada de reacciones por parte de otros países, que también han expresado su intención de, como mínimo, investigar a OpenAI, desarrolladora de ChatGPT. Esto es lo que España acaba de anunciar: investigará a la empresa propietaria de ChatGPT.

Tal y como ha anunciado la Agencia Española de Protección de Datos (AEPD), se han iniciado, de oficio, "actuaciones de investigación" a OpenAI por un posible incumplimiento de la normativa de protección de datos. De esta forma, España pone las bases para una investigación que, en su peor escenario, podría implicar seguir los pasos de Italia y bloquear ChatGPT en nuestro país.

En el comunicado, la AEPD explica cómo la semana pasada, la agencia solicitó al Comité Europeo de Protección de Datos (EDPB) que se incluyera a ChatGPT como tema en su última reunión plenaria, al "considerar que los tratamientos globales que pueden tener un importante impacto sobre los derechos de las personas requieren de acciones armonizadas y coordinadas a nivel europeo".

España investigará a OpenAI

Actualmente, OpenAI es la empresa que desarrolla tanto ChatGPT como los modelos de inteligencia artificial generativa que da vida a la herramienta, como es el caso de GPT-4. Debido al gran interés que generaron estas herramientas en la sociedad, empresas como Microsoft realizaron fuertes inversiones en la compañía para integrar sus modelos en sus servicios.

El motivo que llevó a Italia a bloquear ChatGPT era el mismo que ha impulsado la investigación de la AEPD: el incumplimiento de las leyes de protección de datos establecidas en la Unión Europea. Además, otras acusaciones hablaban de cómo ChatGPT no tenía herramientas para verificar la edad de sus usuarios, lo que podía exponer a menores a desinformación o respuestas no demasiado aptas para ellos.

Fotomontaje con el logo de OpenAI y una ilustración de una IA. Omicrono | iStock

Desde que la AEPD solicitó a la EDPB la inclusión de ChatGPT como tema de conversación, se le han unido otras agencias de protección de datos nacionales que también han detallado sus inquietudes sobre la herramienta. Sin ir más lejos, la Comisión Nacional de Informática y de las Libertades de Francia (CNIL) hizo algo muy similar, realizando una investigación en base a varias quejas interpuestas contra el chatbot.

Varios países involucrados

Pero la AEPD y la CNIL no son las únicas agencias gubernamentales que están pendientes de todo este tema. Desde el bloqueo de Italia, surgieron países como Irlanda o Alemania que estaban realizando sus propias consideraciones al respecto. La segunda fue muy tajante; aunque no haya planes por parte de Alemania para realizar el bloqueo, no les temblará la mano en caso de tener que hacerlo.

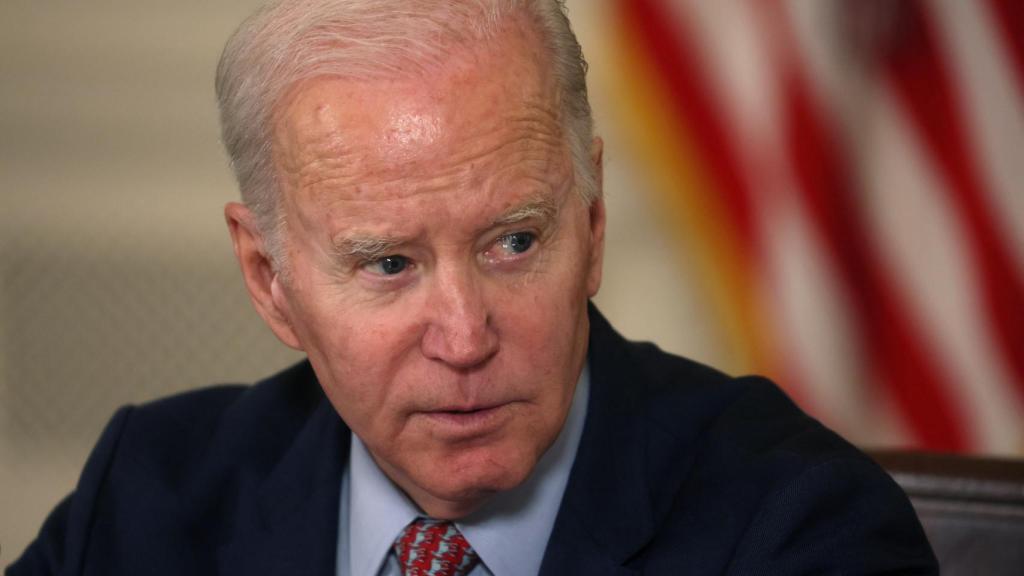

Joe Biden ante el Consejo de Asesores sobre Ciencia y Tecnología del Presidente (PCAST) Omicrono

Por si fuera poco, la lista va aumentando. Tal y como expone el The Wall Street Journal, la administración de Joe Biden ha abierto la puerta a la idea de regular las herramientas de inteligencia artificial, en clara alusión a ChatGPT. Y es que no son pocas las voces que no solo inciden sobre los problemas de privacidad que pueden conllevar estas herramientas, sino que advierten de la capacidad de las mismas para lanzar comentarios dañinos o difundir información falsa.

El Departamento de Comercio de los Estados Unidos emitió el pasado martes una solicitud pública formal de comentarios sobre lo que ellos mismos apodaron como 'medidas de responsabilidad'. En estas medidas se incluía la pregunta sobre si estos modelos de IA deberían pasar por un proceso de certificación antes de su lanzamiento.

Lo más llamativo es que la lista podría crecer a medida que se produzcan hipotéticos bloqueos por parte de más países. Sin ir más lejos y tal y como recoge también el The Wall Street Journal, las organizaciones de regulación de contenido en Internet de China propusieron la aplicación de medidas para controlar el contenido generado por estas herramientas.