Persona usando WhatsApp Omicrono

Así es la polémica ley contra la pornografía infantil que quiere leer tus chats de WhatsApp

Hasta 300 expertos han firmado una carta para criticar la propuesta europea que comparan con poner una cámara dentro de las casas.

4 julio, 2023 14:03Europa está inmersa en una nueva era de legislación tecnológica, no solo por la primera ley sobre inteligencia artificial que se está elaborando en el mundo, sino también por diferentes proyectos de ley que se han propuesto tanto en Reino Unido como dentro de la Unión Europea contra el contenido pornográfico infantil y que han sido criticado por socavar la privacidad de los ciudadanos. WhatsApp ha llegado a amenazar con abandonar Reino Unido y ahora un manifiesto de 300 científicos de 32 países, incluida España, crítica la medida europea.

El cifrado de extremo a extremo es uno de los puntos en cuestión dentro de esta nueva disputa entre defensores y detractores de la posible legislación, un método que protege los mensajes de miradas ajenas en Apple, WhatsApp, Telegram y Signal, pero que el Ministerio del Interior de España ha pedido prohibirlo al Consejo Europeo para facilitar la acción policial.

El objetivo es dar más control y acceso a las autoridades para luchar contra la pornografía infantil que circula por la red, incluso en las herramientas de mensajería protegidas como WhatsApp o iMessage de Apple. Los firmantes de este nuevo manifiesto aseguran que la revisión que sugiere la ley no se puede realizar a día de hoy sin el uso de un software espía dentro de cada dispositivo. Lo comparan incluso con instalar cámaras dentro de cada vivienda.

¿Cómo funcionaría?

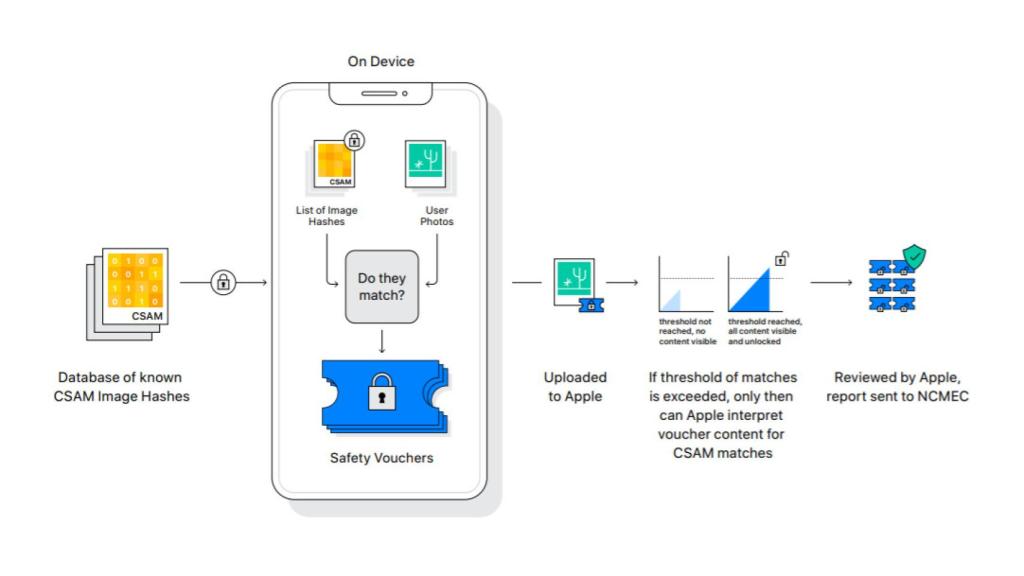

El sistema designado por la ley se asemeja a lo presentado por Apple en 2021 que levantó bastante polémica. De esta forma, se asigna un extenso número o hash a cada imagen conocida por las autoridades como contenido pedófilo o ilegal. La tecnología hash analiza la imagen sin necesidad de visualizarla o abrir el archivo. Convierte cada fotografía en un número único que describe su contenido, como una huella dactilar digital, pero que para cualquier usuario sería imposible comprender.

Si se detectan suficientes coincidencias entre el código de la imagen y el del contenido ya catalogado como ilegal, se crea una alerta. En el caso del sistema que Apple pretendía establecer hace dos años, un positivo activaba medidas de seguridad como difuminar la imagen y bloquearla para que no se pueda compartir. También se incluían avisos a los padres en caso de que fuera en el móvil de un menor o alertas a las autoridades para poder revisar el contenido.

Apple tecnología hash Omicrono

La teoría parece segura, pero es la práctica la que preocupa a los firmantes, por un lado, los delincuentes pueden variar una imagen ligeramente para alterar el hash y esquivar la detección, así como pueden crearse imágenes legítimas con hashes que coincidan con la búsqueda policial para saturar los sistemas de las autoridades. Por otro lado, los denunciantes aluden a regímenes menos democráticos para sugerir que es posible ampliar la base de datos hash para detectar también contenido crítico con el gobierno y así detectar a disidentes.

"Como científicos, no esperamos que sea factible en los próximos 10 a 20 años desarrollar una solución que pueda ejecutarse en los dispositivos de los usuarios sin filtrar información ilegal y que pueda detectar contenido conocido de forma fiable, es decir, con un número aceptable de falsos positivos y negativos", dice la carta.

[Twitter no detecta la pornografía infantil: avisan de un nuevo fallo en su sistema]

La ley europea también exige el uso de herramientas de inteligencia artificial para analizar el contenido, a lo que los expertos contestan dudando de la eficacia de las técnicas de aprendizaje automático cuando el comportamiento a identifica no se define con precisión. "Eso se debe a que los sistemas de IA carecen de contexto y sentido común. Hay algunas tareas para las que los sistemas de inteligencia artificial se adaptan bien, pero la búsqueda de un delito delicado y muy matizado, que es el comportamiento de preparación, no es una de estas tareas", se puede leer en el manifiesto.

Cifrado de extremo a extremo

Para poder revisar esas imágenes, vídeos o mensajes en busca de un hash positivo, es necesario poder acceder al contenido que se comparte en aplicaciones como WhatsApp, protegido por el cifrado de extremo a extremo. El mensaje se cifra en el dispositivo que lo envía y se descifra en el del receptor para que por el camino nadie pueda verlo. "El cifrado es la única herramienta que tenemos para proteger nuestros datos en el ámbito digital; se ha demostrado que todas las demás herramientas están comprometidas", declaran en el manifiesto.

Este es el caso en el que la carta compara a la propuesta de la UE con una cámara espía dentro de las casas de los ciudadanos. Se refieren a las técnicas de Escaneo del lado del cliente o CSS que analizarían el contenido antes de ser cifrado y enviado o tras recibirlo y descifrarlo. Para ello, el software debe estar dentro del dispositivo implicado en la conversación, de ahí que los firmantes lo llamen software espía.

"La regulación propuesta perjudicará la libertad de los niños para expresarse ya que sus conversaciones también podrían estar disparando las alarmas. (...) Estas tecnologías cambian la relación entre las personas y sus dispositivos, y será difícil reintroducir esos matices", termina diciendo la carta que firman casi 20 expertos de España, entre otras nacionalidades.