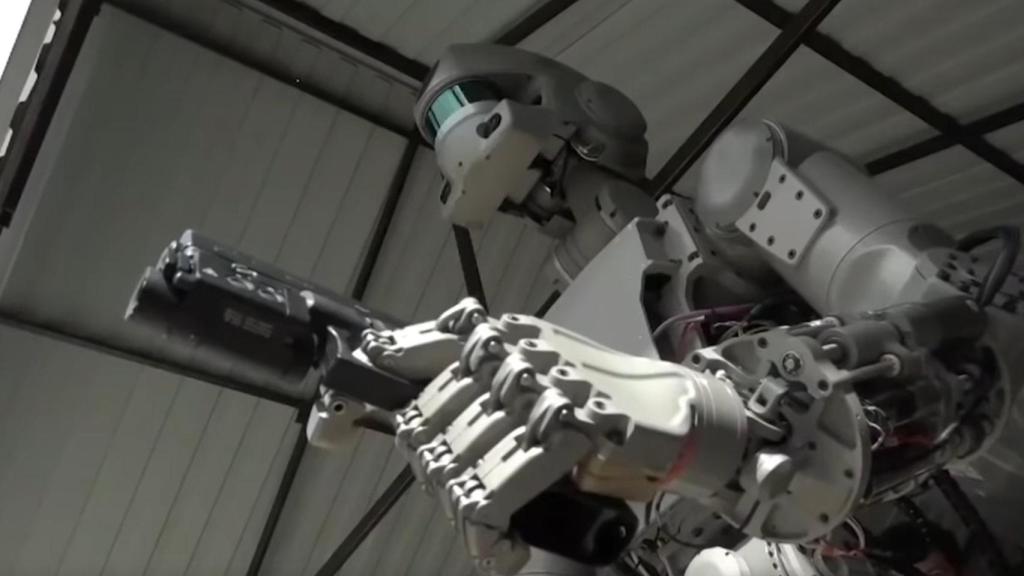

Robot con un arma.

Los 'padrinos' de la IA exigen controles de seguridad urgentes para evitar una "catástrofe"

Numerosos académicos y expertos han pedido medidas contundentes ante la carrera de la IA que se está gestando en los últimos años.

24 octubre, 2023 11:39En contraste a los avances que la inteligencia artificial está realizando de la mano de ciertas empresas, muchos expertos están advirtiendo de sus peligros a futuro. En España no son pocas las voces que avisan de la necesidad de una normativa que regule esta tecnología para paliar sus mayores desventajas. Los últimos en hacerlo han sido un grupo de expertos en el campo, que han lanzado un manifiesto sobre el tema.

El manifiesto, que cuenta con la autoría de hasta 23 expertos de todo el mundo, se ha publicado bajo el título "Managing AI Risk in a Era of Rapid Progress". Entre algunos nombres nos encontramos a David Krueger, de la Universidad de Cambridge o a Dawn Song, de la Universidad de California, en Berkeley, entre muchos otros.

El texto deja claro varios puntos, especialmente basados en la problemática que suponen los avances tan rápidos que se están realizando en la inteligencia artificial. Este documento, además, llega poco antes de la cumbre de seguridad de IA que se celebrará en Bletchley Park, en el Museo de Bletchley Park, en Reino Unido. Esta congregará a políticos, académicos y empresarios tecnológicos.

Nuevo manifiesto contra la IA

El documento, que se puede leer íntegramente en este enlace, alude sobre todo al ritmo del progreso que está sufriendo la inteligencia artificial. El propio texto comienza precisamente referenciando este punto, explicando cómo los primeros modelos de GPT no eran casi funcionales y cómo los actuales son, quizás, demasiado poderosos.

"En 2019, GPT-2 no podía contar hasta 10 de forma fiable. En tan solo 4 años, los sistemas de aprendizaje profundo pueden escribir software, generar escenas fotorrealistas bajo demanda, asesorar sobre temas intelectuales y combinar lenguaje y procesamiento de imágenes para dirigir robots", cita el documento.

Ilustración del logo de OpenAI. Omicrono

Si bien los autores admiten que los sistemas actuales "todavía carecen de capacidades importantes", la problemática para ellos reside en la carrera entre las empresas que actualmente se está llevando a cabo. Esta carrera, que a ojos de los autores sirve "para crear sistemas de IA generalistas que igualen o superen las capacidades humanas", es claramente el foco del problema actual.

Temen que la IA sea capaz de superar las condiciones humanas en campos mucho más generalistas. Algo que ya se ha visto, pero en "dominios limitados, como el plegamiento de proteínas o los juegos de estrategia. En comparación con los humanos, los sistemas de inteligencia artificial pueden actuar más rápido, absorber más conocimiento y comunicarse con un ancho de banda mucho mayor", explican.

ChatGPT Omicrono

Estamos hablando de auténticos expertos y académicos en el campo de la inteligencia artificial. Por ejemplo, entre los autores están Geoffrey Hinton y Yoshua Bengio, dos de los conocidos como tres 'padrinos' de la inteligencia artificial. En 2018, Hinton y Bengio consiguieron el premio ACM Turing, el equivalente en los Nobel de la IA. De hecho, están invitados a la cumbre de Bletchley Park.

El medio The Guardian cita declaraciones de algunos expertos que dejan claro que la IA no son "juguetes", y creen que aumentar las capacidades de la inteligencia artificial antes de que el humano pueda hacerlas segura "es completamente imprudente", detalla Stuart Russell, profesor de informática en la Universidad de California, Berkeley. Autor que, precisamente, pone su firma en el documento.

[Estos son los trabajos que desaparecerán por la inteligencia artificial, según la propia ChatGPT]

Entre los principales puntos que el documento pide llevar a cabo en las cúpulas gubernamentales actuales nos encontramos dar acceso a auditores independientes a laboratorios de IA o establecer un sistema de licencias para la construcción de modelos de vanguardia, entre otros. También se pide responsabilidad a las empresas para que se hagan cargo de los daños causados por estos sistemas.

Los expertos piden, por ejemplo, que los gobiernos asignen al menos un tercio de los fondos de investigación y desarrollo de IA a la seguridad y ética de estos sistemas. Lo mismo ocurre con las empresas; que un tercio de los recursos de I+D destinados a la inteligencia artificial se dedique a estos campos.

Logo de ChatGPT junto a una ilustración- Omicrono

Los peligros mencionados en el texto son variados, incluyendo la creación de sistemas completamente autónomos que puedan llegar a influir en el transcurso de los acontecimientos a nivel mundial. De hecho, aseguran que de no tomar medidas, estos sistemas podrían "amplificar la injusticia social, socavar nuestras profesiones, erosionar la estabilidad social, permitir actividades criminales [...] y debilitar nuestra comprensión compartida de la realidad [...]".

También te puede interesar...

- Uno de los padres de la inteligencia artificial abandona Google y avisa de sus grandes riesgos

- Uno de los padrinos de la IA: será más inteligente que los humanos, pero es "ridículo" tenerle miedo

- Granjas de clics hechas con inteligencia artificial: webs falsas que te inundan con desinformación

- "No sabemos si podremos controlar la IA si llega a cobrar conciencia", advierten los científicos