Los Objetivos de Desarrollo Sostenible (ODS) 5 -igualdad- y 9 -industria, innovación e infraestructura- están intrínsecamente relacionados con los algoritmos y el sesgo en la contratación. Además, usemos o no inteligencia artificial (IA), cuando se necesita un nuevo trabajador en una empresa, lo primero que pasa por nuestra mente es un pensamiento: "Hay que crear un nuevo puesto". Este suele ir acompañado de otro sobre la persona que podría encajar en él.

En esta fase temprana, en la que las compañías suelen ya tener una idea de sus necesidades de talento y del perfil de la persona que encaja, los primeros prejuicios pueden hacer su aparición.

Si hay que sustituir a una persona contratada, es probable que la empresa busque a otra con el mismo perfil. Si hay que crear un nuevo puesto, los responsables de la contratación probablemente tendrán ya una idea del perfil que buscan.

El primer paso del proceso de contratación es la búsqueda de candidaturas a través de anuncios, avisos de empleo y contactos individuales. Durante este proceso, si las empresas no tienen cuidado, podrían darse los primeros casos de discriminación.

Aunque las herramientas estén lejos de ser perfectas, ayudan a las compañías a crear ofertas de empleo más inclusivas

Un ejemplo claro es un anuncio en el que "se busca camarera". Realmente, lo que debería anunciarse es una oferta de "personal de servicio" o "camarero o camarera".

Por suerte, ya existen algunas tecnologías basadas en la IA que pretenden evitar algunos de estos sesgos y discriminaciones. Las aplicaciones que ayudan a las empresas a crear descripciones de puestos de trabajo, por ejemplo, están diseñadas para llegar a más solicitantes y fomentar una reserva de talento mayor y más diversa, centrándose especialmente en la diversidad de género.

Aunque, como dice el investigador Aaron Rieke, estas herramientas estén lejos de ser perfectas, ayudan a las compañías a crear ofertas de empleo más inclusivas.

Pero según Rieke y su equipo, los problemas también pueden surgir en la fase de publicidad: muchas empresas utilizan herramientas de publicidad digital de pago para difundir las oportunidades de empleo a un mayor número de posibles candidatos.

Sin embargo, como argumenta otra experta, Pauline Kim, "no informar a la gente de una oportunidad de trabajo es una barrera muy eficaz para solicitar ese puesto". Por ello, Rieke concluye que "la complejidad y la opacidad de las herramientas de publicidad digital dificultan, si no imposibilitan, que las personas en búsqueda de trabajo agraviadas detecten patrones discriminatorios de publicidad en primer lugar".

Llega a una conclusión similar en relación con las herramientas de emparejamiento. Y afirma que "las que se basan en aproximaciones atenuadas de relevancia e interés podrían acabar reproduciendo los mismos sesgos cognitivos que pretenden eliminar".

Un ejemplo de discriminación sería un anuncio de "se busca camarera". Lo que debería anunciarse es una oferta de "personal de servicio" o "camarero o camarera"

Durante la fase de selección, las empresas evalúan a las candidaturas -tanto antes como después de que se presenten- analizando sus experiencias, habilidades y personalidades.

En esta fase, las empresas suelen juzgar a las candidaturas basándose en sus propios prejuicios. Por ejemplo, pueden rechazar a mujeres de entre 25 y 40 años porque están en edad de criar a sus hijos.

Rieke y su equipo también han comprobado las herramientas basadas en la IA para apoyar la fase de selección. Estas evalúan, puntúan y clasifican a las candidaturas en función de sus cualificaciones, habilidades sociales y otras capacidades. Y así ayudar a los responsables de la contratación a decidir quién debe pasar a la siguiente fase.

Estas herramientas ayudan a las empresas a reducir rápidamente su grupo de candidaturas para que puedan dedicar más tiempo a considerar las que se consideran más fuertes. Un alto número de solicitantes de empleo son rechazados automática o sumariamente durante esta etapa.

Por lo que respecta a la fase de selección, Rieke concluye que el modelo resultante reflejará muy probablemente los prejuicios interpersonales, institucionales y sistémicos previos cuando los sistemas de selección pretenden replicar las decisiones de contratación anteriores de una empresa.

Esto significa que este tipo de instrumentos de selección también están muy sesgados. La herramienta de reclutamiento de IA de Amazon fue algo parecido. Se trataba de un caso bien documentado, que demostró que la herramienta replicaba el sesgo institucional contra las mujeres.

El proceso de entrevista es una oportunidad para que las empresas evalúen a las candidaturas de forma más directa e individualizada. Sin embargo, las empresas deben evitar hacer preguntas que hagan suposiciones sobre las candidaturas fundamentadas en su esfera protegida, como sus planes familiares, etc.

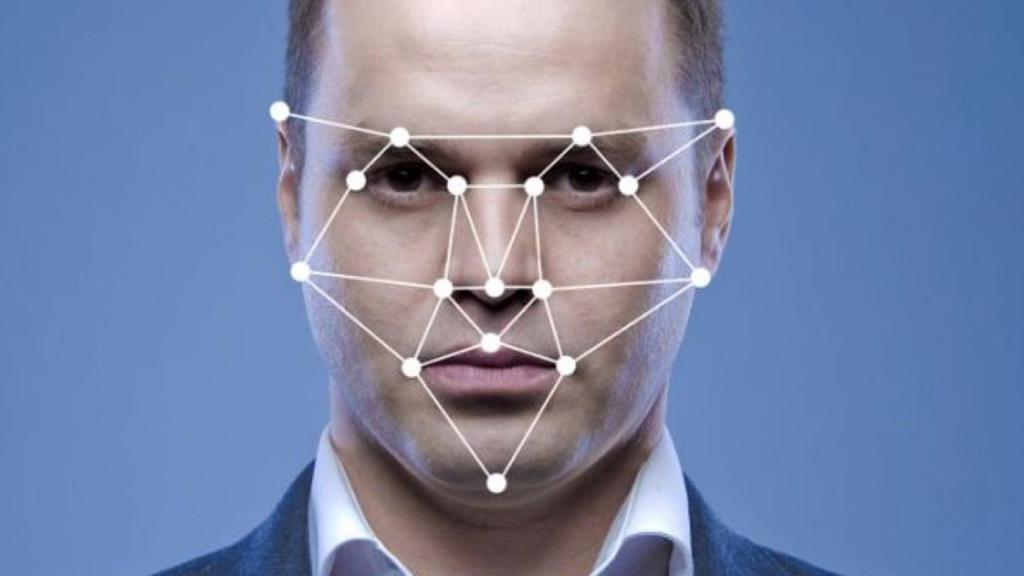

Los sistemas de análisis facial podrían penalizar a personas en las entrevistas por discapacidades visibles

Existen herramientas basadas en la IA que afirman medir el rendimiento de las candidaturas en las entrevistas de vídeo mediante el análisis automático de las respuestas verbales, el tono e incluso las expresiones faciales.

En su investigación, Rieke y su equipo se centraron en una herramienta de la empresa HireVue. Este instrumento permite a las empresas solicitar a las candidaturas respuestas grabadas en las entrevistas y luego calificar las respuestas en comparación con las de las personas actualmente contratadas que han tenido éxito.

Más concretamente, HireVue analiza los vídeos mediante aprendizaje automático. Extrae señales como expresiones faciales, contacto visual, indicaciones vocales de entusiasmo, elección de palabras, complejidad de las mismas, temas tratados y agrupaciones de palabras.

El uso de herramientas como HireVue plantea cuestiones en múltiples frentes, sobre todo relacionadas con aspectos éticos. Rieke detecta que el software de reconocimiento de voz puede tener un rendimiento deficiente, especialmente en el caso de personas con acentos regionales y no nativos.

Además, los sistemas de análisis facial pueden tener dificultades para reconocer los rostros de las mujeres con piel más oscura. Algunas personas entrevistadas podrían ser premiadas por factores irrelevantes o injustos, como expresiones faciales exageradas. Otras podrían ser penalizadas por discapacidades visibles o impedimentos del habla.

Por otra parte, el uso de este tipo de datos biométricos podría no tener un fundamento legal si se utilizan para predecir el éxito en el trabajo, para tomar o informar sobre las decisiones de contratación.

Existen herramientas de contratación que pretenden predecir si los candidatos podrían infringir las políticas del lugar de trabajo

Durante el último proceso de la contratación, la fase de selección, las empresas toman las decisiones finales de contratación y remuneración. En esta última etapa, las mujeres presentan sistemáticamente ofertas salariales más bajas que los hombres.

En la actualidad existen herramientas de contratación que pretenden predecir si los candidatos podrían infringir las políticas del lugar de trabajo, o estimar qué combinación de salarios y otros beneficios ofrecer.

A Rieke y su equipo les preocupa que esos instrumentos puedan ampliar las diferencias salariales de las mujeres y las personas de color. Como afirma, "los datos de recursos humanos suelen incluir amplias aproximaciones al estatus socioeconómico y racial de una persona, lo que podría reflejarse en las predicciones de requisitos salariales".

En cualquier caso, ofrecer a las empresas una visión muy específica de los requisitos salariales de una candidatura aumenta la asimetría de información entre empresas y candidaturas en un momento crítico de la negociación.

Por lo tanto, se puede llegar a la conclusión de que las herramientas de IA deben ser auditadas: cuantitativamente, utilizando datos demográficos etiquetados para comprobar los resultados, y cualitativamente, interrogando las variables reales y la relación con el trabajo.

Además, es muy importante trabajar en la antidiscriminación en el mundo real para evitar que se replique y concrete en el mundo digital. Porque una vez que los algoritmos están en línea y en uso, es muy difícil detener su utilización.

***Katharina Miller es presidenta de la Asociación europea de mujeres abogadas (EWLA)