El investigador de CENID, Andrés Montoyo, junto a parte de su equipo.

CENID Alicante lidera un proyecto de IA para prevenir conductas suicidas a través del lenguaje en redes sociales

Tras detectar potenciales mensajes publicados en las redes sociales se pueden enviar alertas a las instituciones para evitar muertes autoinducidas.

CENID, el Centro de Inteligencia digital de la provincia de Alicante, impulsado por la Diputación de Alicante, la Universidad de Alicante y la Universidad Miguel Hernández de Elche, trabaja ya en el desarrollo de una tecnología de Inteligencia Artificial para prevenir el suicidio a través del lenguaje utilizado en las redes sociales. El objetivo es detectar posibles víctimas, sobre todo entre los jóvenes, y desarrollar protocolos de actuación para evitar esta lacra social.

Este proyecto que se ha llamado "Life!" y que está liderado por los investigadores Andrés Montoyo Guijarro, José Ignacio Abreu Salas y José Manuel Gómez Soriano, de la UA, pretende identificar a través de la IA patrones de expresión en foros, chats, redes sociales, blogs, microblogs o emails de conductas depresivas, tendencias suicidas o bullying a partir de los sentimientos y emociones que expresan los usuarios.

No en vano, cada año aumenta el preocupante número de suicidios convirtiéndose en la principal causa de muerte violenta en Europa. Actualmente mueren tras suicidarse 800.000 personas al año en todo el mundo y se calcula que en 2035 morirán alrededor de 1,53 millones de personas como consecuencia de actos suicidas.

Con esta tecnología, los investigadores creen que las muertes autoinducidas pueden ser potencialmente prevenibles ya que muchas víctimas anuncian sus pensamientos suicidas antes de cometer el intento en Internet.

El reto del proyecto consiste en utilizar la tecnología para detectar en el nuevo lenguaje empleado en los medios sociales (abreviaciones, argot, smiles y, más generalmente, un lenguaje poco estructurado y altamente informal), de estos patrones de conducta y de este modo, derivar a la posible víctima a instituciones sanitarias o sociales que puedan ayudarles a superar esas tendencias.

Para ello, los investigadores de CENID plantean configurar un equipo de jóvenes investigadores -alrededor de 6 personas, afirma Montoyo-, y a partir de ahí buscar financiación para poner en marcha el proyecto, que podría dar resultados en tres años.

"La idea es acometer la financiación, incluso habíamos pensado un crowdfunding para ver si la gente pues que esté interesada", señala el investigador, quien confía en concurrir a alguna ayuda europea. "Queremos que participen distintos países, como Finlandia o Bélgica, que también tienen muchos problemas de este tipo. El obstáculo es el lenguaje, trabajar con distintos vocabularios, por eso es interesante tener partners de otros países, añade Montoyo.

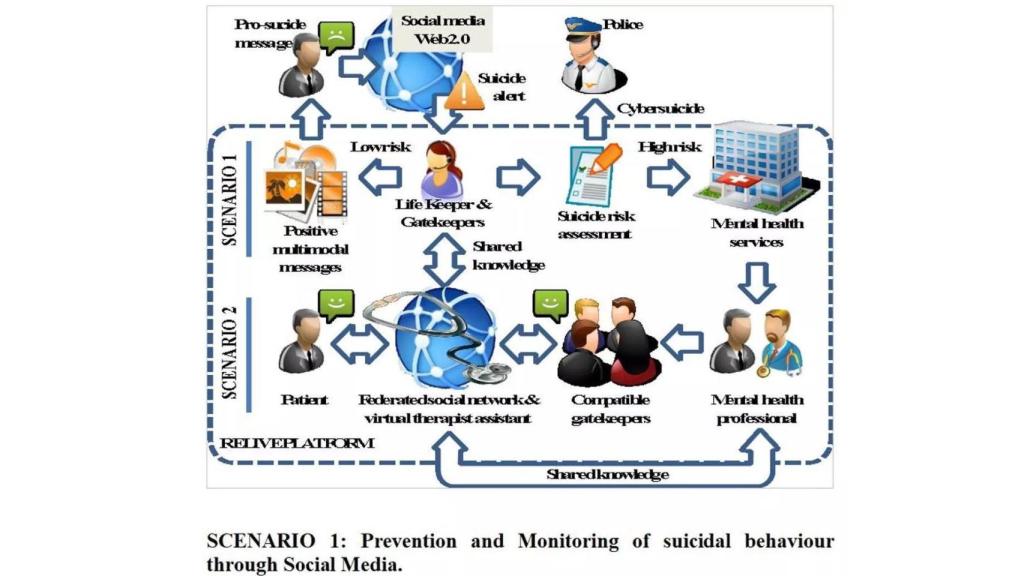

Este nuevo procedimiento analizará y definirá protocolos de actuación a seguir por el personal sanitario cuando se reciba una alerta y se compartirán los conocimientos entre los agentes que intervienen. En este sentido, se plantean dos escenarios.

Los escenarios

El primero de los escenarios es que una vez detectadas estas conductas o actitudes se pueda comunicar el problema a un organismo responsable de su tratamiento como podría ser el Teléfono de la Esperanza o psicólogos o psiquiatras.

Escenarios previstos en el proyecto Life! de CENID.

El segundo escenario sería el inverso, una vez detectado el problema por parte de instituciones, poder "hacer aprender" a la IA a través de la interación concreta de un usuario en Internet al tiempo que se ayuda al paciente. "Hay muchas personas que se dan cuenta de su problema y asisten directamente ya a Urgencias de cualquier hospital. Allí son tratados por psiquiatras. De ese proceso se puede generar una de comunicación inversa".

Andrés Montoyo, investigador de CENID Alicante.

Esa comunicación se puede realizar a través de un keeper, una persona que ayuda o que guarda al paciente, monitorizando su vocabulario en las redes y si detecta algún problema, poder activar distintos niveles de alerta.

Por supuesto, entrar en la monitorización debe ser algo absolutamente voluntario. "Es como la 'amistad' en Facebook. Tú eres amigo de mis amigos y automáticamente le has dado permiso para que vean tus contenidos, pues sería lo mismo", explica Montoyo. "Por supuesto, cuantos más casos, cuanta más información se le metan a esos modelos de inteligencia artificial, más inteligente se hará. Es una retroalimentación constante de los modelos", continúa el investigador.

Y lo mismo sucedería en el caso de los menores. Solo serían monitorizados con permiso expreso de sus padres o tutores, que entenderían que es una herramienta útil para prevenir el aumento de casos de suicidio o de bulling o ciberbulling entre este segmento de la población.