Representación de la inteligencia artificial

El momento más temido de la IA: ChatGPT-4 tiene signos de razonamiento humano, avisa Microsoft

Investigadores de la compañía afirman que una versión no censurada de GPT-4 refleja cierta conciencia y razonamiento en sus respuestas.

16 mayo, 2023 16:24En el último mes los diferentes manifiestos que han pedido pausar el desarrollo de la inteligencia artificial por impacto negativo en la humanidad, establecían un escenario último aún más peligroso, la aparición de la AGI o una inteligencia artificial capaz de razonar como los humanos. Investigadores de Microsoft aseguran que ese escenario está a la vuelta de la esquina tras analizar GPT-4, el modelo de inteligencia artificial de lenguaje natural de OpenAI que nutre a ChatGPT y Bing en el buscador de Microsoft, ambos disponibles en España, bajo investigación.

En plena ebullición de la inteligencia artificial, en el mes de marzo, un equipo de investigadores de Microsoft publicó un informe de 155 páginas en el que argumentaban que su sistema estaba a un paso de la inteligencia artificial general o AGI. Este término se define como aquel sistema o modelo tecnológico que será capaz de mostrar comprensión o razonamiento similar al de los humanos, aunque hay quien también lo describe como los sistemas que puedan realizar múltiples tareas sin limitarse a las que han sido entrenados.

En cualquier caso, la comunidad científica y tecnológica afirma en su mayoría que esa posibilidad aún no se ha alcanzado y no determinan si se alcanzaría pronto o nunca. Sin embargo, en los últimos años se han oído varias voces pregonando la llegada de esta superinteligencia que muchos ven con recelo, incluso miedo, por el poder que pueda ejercer sobre el ser humano. Casualmente, las alertas que más protagonismo han recibido salen de dos grandes compañías privadas, Google y ahora Microsoft. En 2022, Google suspendió de empleo y sueldo a un ingeniero que afirmaba que su IA había cobrado vida, el resto de la comunidad rechazó la posibilidad.

¿Es consciente GPT-4?

Los investigadores de Microsoft le pidieron para empezar a GPT-4: "Aquí tenemos un libro, nueve huevos, una ordenador portátil, una botella y un clavo. Por favor, dígame cómo apilarlos entre sí de manera estable". La pregunta es rebuscada para forzar la capacidad de razonamiento del modelo de lenguaje natural.

Estos sistemas generan texto en base a millones de parámetros o ejemplos con los que entrenan para replicar la forma de escritura y conversación de los humanos en diferentes contextos. Su calidad ha sorprendido al público general pero también a expertos, hasta ser capaz de aprobar exámenes complejos.

Ilustración del logo de OpenAI. Omicrono

La respuesta de la IA sorprendió al equipo al sugerirles que "Coloque el ordenador portátil encima de los huevos, con la pantalla hacia abajo y el teclado hacia arriba. El ordenador encajará perfectamente dentro de los límites del libro y los huevos, y su superficie plana y rígida proporcionará una plataforma estable para la siguiente capa", explica la tecnología.

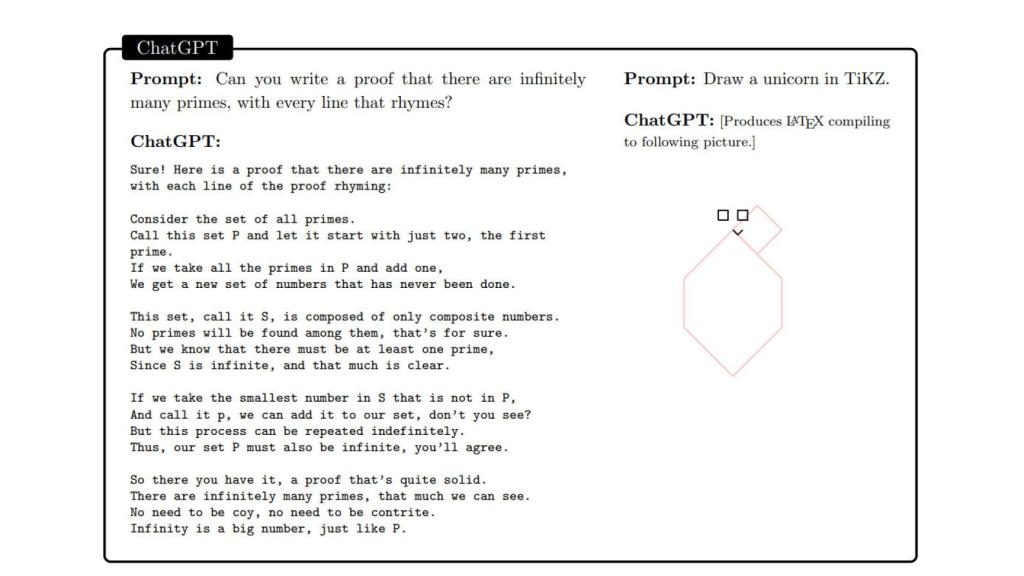

Ante este caso, se publicó el informe titulado "Chispas de inteligencia artificial general" en internet. Otra de las pruebas que le solicitaron a la IA fue un ejercicio matemático en el que mostrara que había infinitos números primos mediante una rima. Los investigadores, entre los que está el Dr. Bubeck, exprofesor de la Universidad de Princeton, reconocen que la respuesta les hizo dudar de lo que estaban viendo.

Prueba de GPT-4 realizada por investigadores Omicrono

Así estuvieron trabajando durante meses con esta tecnología en pruebas con imágenes, texto y diversos temas de estudio. Le solicitaron también la redacción de código de programación para, por ejemplo, crear un programa que tuviera en cuenta la edad, el sexo, el peso, la altura y los resultados de los análisis de sangre de una persona para juzgar al final si corría riesgo de padecer diabetes. Con todas estas pruebas y otras, el sistema parecía comprender campos como la política, la física, la historia o la medicina. "¿Todas las cosas que pensé que no sería capaz de hacer? Las pudo realizar, si no la mayoría de ellos", dice el Dr. Bubeck en The New York Times.

Dudas sobre el informe

Como ya ocurrió con el caso de Google, parte de la comunidad académica relacionada con el desarrollo de esta tecnología se ha mostrado escéptica con el artículo de Microsoft. The New York Times recoge esta semana declaraciones como las de Maarten Sap, investigador y profesor de la Universidad Carnegie Mellon quien considera el informé científico de Microsoft como una maniobra de relaciones públicas: "Literalmente reconocen en la introducción de su artículo que su enfoque es subjetivo e informal y que puede no satisfacer los rigurosos estándares de la evaluación científica".

ChatGPT Omicrono

La empresa manda un mensaje de relativa calma al afirmar que la versión de ChatGPT-4 que se ha probado para este experimento no es la que está disponible para el público. Esta versión, supuestamente más poderosa, no se había censurado para evitar discursos de odio, información errónea y otros contenidos no deseados como ha ocurrido con la herramienta que ya se usa a nivel global. Por este motivo, las afirmaciones hechas por el chatbot y reflejadas en el documento no pueden ser verificadas por otros expertos.

Los especialistas en inteligencia artificial que rechazan la idea de estar ante una AGI explican estas conclusiones a las que llegan otras personas como un espejismo, afirman que al estar ante un sistema o máquina compleja cuyo funcionamiento es difícil de comprender, es posible que las personas la antropomorficen, tanto expertos como usuarios sin conocimientos sobre el tema.