ARI_google_glass

Noticias relacionadas

- Ya puedes comprar las Google Glass Enterprise online: una empresa española, la única autorizada en venderlas

- ¿Te acuerdas de Google Glass? ¡Ha vuelto, en forma de decepción!

- Estaban de parranda: las Google Glass se actualizan, en serio

- El I+D de Google Glass no ha sido en vano: el Pixel lleva un pedacito de ellas

Las Google Glass siguen en fase beca, y sin embargo su evolución se va notando a pasos de gigante. No solo tiene ya pactados diseños de grandes compañías como Ray-Ban, sino que cuenta con grandes aplicaciones: Desde el reconocimiento de emociones hasta la búsqueda de pacientes hospitalarios. Sin embargo, si las intentamos usar con un ruido ambiente infernal, no sirven para nada más que para tacharnos de geeks, y poco más. Podemos darles ordenes, pero si no nos oyen, son inútiles (y la zona táctil de las glass tampoco da para mucho). Pero, ¿y si aplicamos el concepto de Kinect a las Google Glass?

ARI, la aplicación con concepto de Kinect aplicado a Google Glass

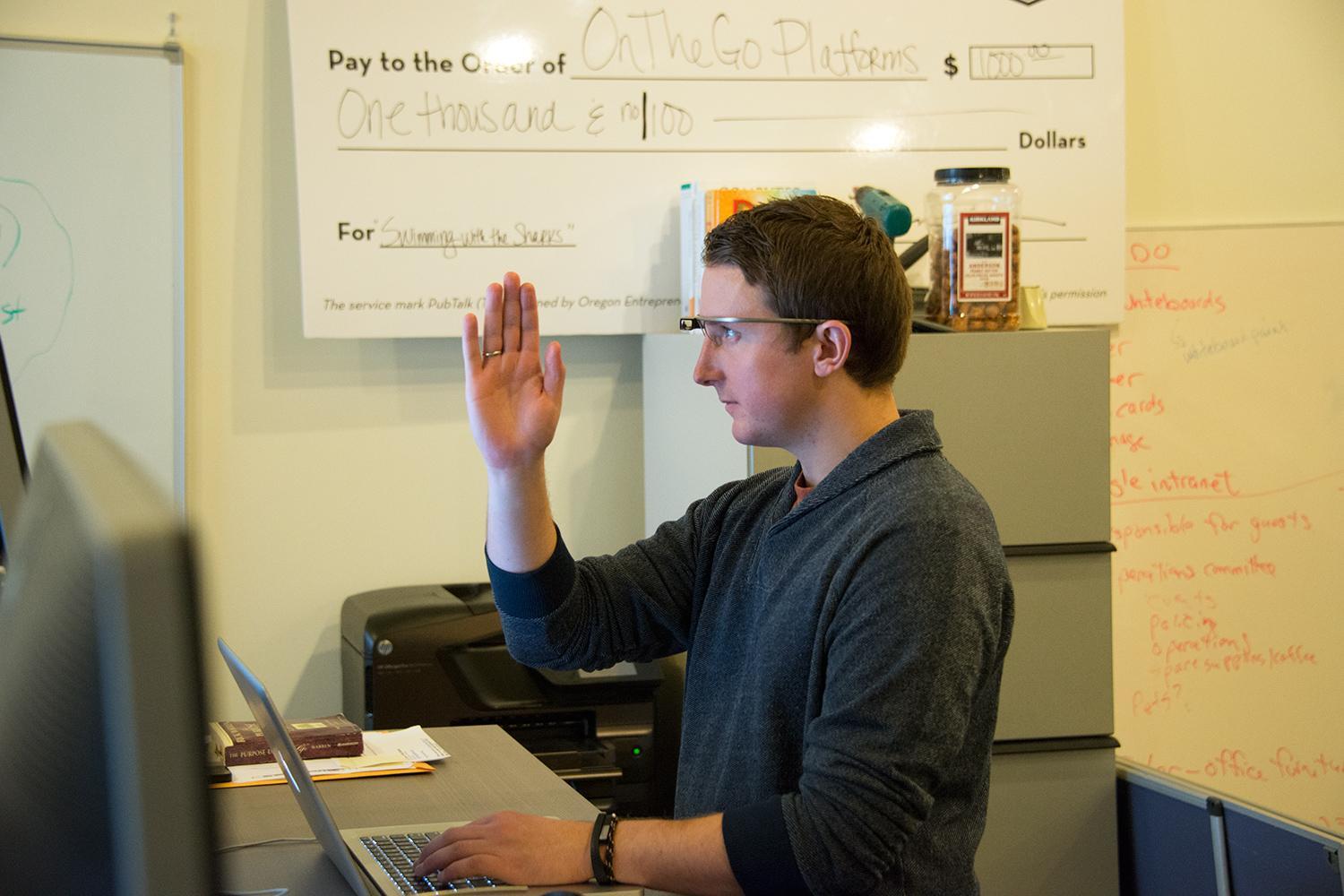

probando_ARI

Precisamente esto es lo que busca ARI (Interfaz de Realidad Aumentada, en sus siglas en inglés), una aplicación desarrollada por una startup de Oregón con el objetivo de controlar las smartglasses mediante el idioma de los signos, la cual ya se encuentra en beta publica.

Por ejemplo, si sostenemos el puño delante de la cara (en plan boxeador) delante de las Google Glass durante tres segundos, la app interpretará que le pedimos realizar una foto. Después podemos mover la mano como si pasáramos las hojas de un libro, y las fotos se nos irán mostrando delante de los ojos, a modo de álbum virtual. Los desarrolladores esperan ir agregando un catálogo completo de gestos gracias a colaboradores externos poco a poco. No se a vosotros, pero a mi me suena bastante bien.

La verdad es que poder manejar las Google Glass son algo más que la voz o el tacto es todo un acierto, pues hay situaciones donde no tenemos las manos disponibles o hay mucho bullicio a nuestro alrededor. Un ejemplo claro podría ser, por ejemplo, los trabajadores de las fábricas o de la construcción, o todo aquel trabajador que porte guantes gruesos y/o se encuentre en medio de un ruido importante.

De momento cabe esperar que ARI vaya mejorando su precisión para reconocer gestos, a la vez que no consume la escasa batería de las Google Glass en el proceso, ya que a mayor precisión, más consumo. Además también es necesaria una adaptación, pues para todo aquel que no esté familiarizado con la tecnología eso de mandarle ordenes a unas gafas mediante gestos puede ser bastante extraño.

Vía | Digital Trends.