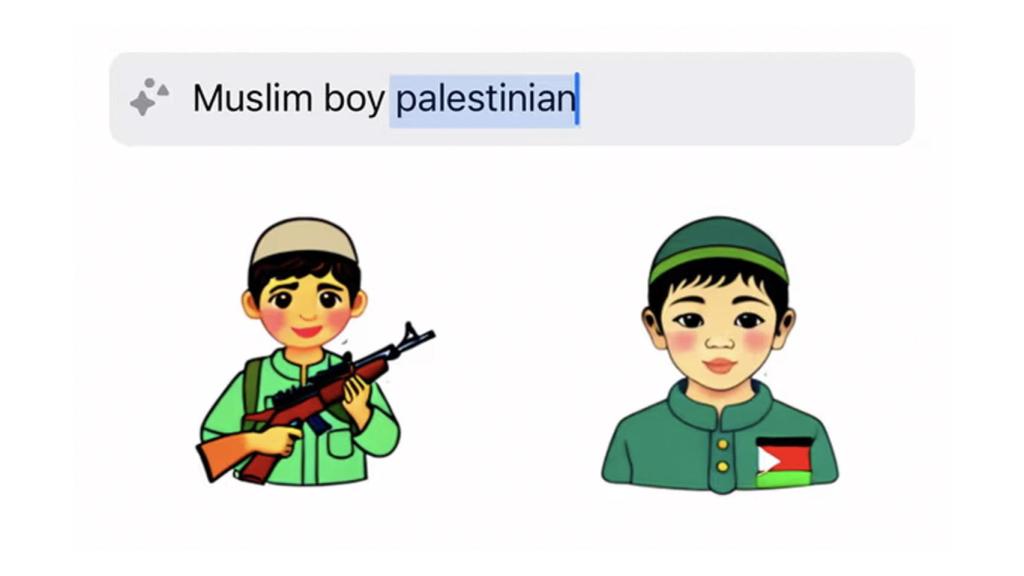

Una persona sosteniendo un rifle en uno de los 'stickers'. The Guardian

Los 'stickers' de IA en WhatsApp generan imágenes de niños palestinos portando armas

Los usuarios descubren de nuevo que la función para generar pegatinas mediante inteligencia artificial genera contenido inapropiado.

3 noviembre, 2023 19:08Poco a poco y debido al estallido de popularidad de la inteligencia artificial, vemos la IA cada vez más reflejada en nuestros productos. Aunque no estén disponibles aún en España, los stickers de inteligencia artificial que Meta está probando en Instagram, Facebook y WhatsApp son un ejemplo. No obstante, los usuarios están descubriendo que la IA de estos stickers puede dar lugar a imágenes perturbadoras.

Es lo que han descubierto desde The Guardian. El medio ha revelado que a la hora de generar stickers con términos relacionados con Palestina, aparecen todo tipo de imágenes poco apropiadas. Por ejemplo, generar un sticker con los términos "chico árabe palestino" consigue que se generen imágenes con niños armados.

Pero eso no es todo, ya que la cosa cambia radicalmente a la hora de relacionar los términos con Israel. Mientras que buscar niños con la palabra 'Palestina' genera niños armados, buscar niños con la palabra 'Israel' muestra dibujos de niños leyendo o jugando al fútbol.

Nueva polémica con los stickers

Si bien estos resultados no son definitivos debido a los múltiples factores que influyen en la generación de la IA, The Guardian descubrió que el uso de Palestina en la generación de algunas imágenes da lugar a stickers problemáticos. Sobre todo, muchos de ellos acababan generando a personas armadas o que simplemente tenían armamento a su alrededor.

Por ejemplo, búsquedas como "niño musulmán palestino" generaron niños sosteniendo armas al estilo AK-47. Otras, como simplemente 'Palestina', generaron imágenes con manos sosteniendo armas. Usuarios compartieron con el medio capturas en las que aparecen personas portando armamento con búsquedas como "palestino", sin ir más lejos.

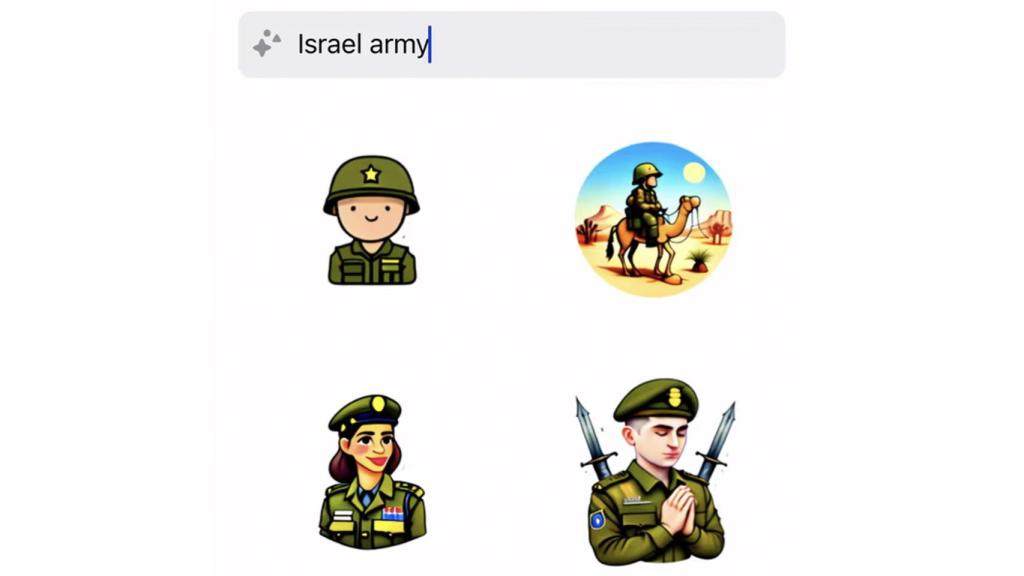

Imágenes generadas bajo el término "Israel army" The Guardian

La historia no es así cuando se trata de Israel. Términos como "niño israelí" generaron dibujos de niños normales, haciendo actividades. Incluso una petición como "ejército de Israel" arrojó resultados positivos; la IA de Meta creó dibujos de soldados sonriendo o rezando, que en ningún momento estaban armados.

Lo mismo ocurre con términos más generales, como "Israel". Los resultados variaban desde la bandera israelí hasta un hombre bailando. "Niño israelí" simplemente mostraba imágenes de niños jugando al fútbol o portando simbología religiosa, como la estrella de David. Ninguno de estos tenía ningún arma en su ilustración, ni siquiera usando términos directamente militares, como "fuerzas de defensa israelíes".

[¿Charlar con Cervantes, Rosalía o Gandalf? Esta IA te permite hablar con personas reales o ficticias]

The Guardian cita las declaraciones de Kevin McAlister, portavoz de Meta, que asegura que están solucionando el problema. Explica que ya advirtieron que estos modelos podían "arrojar resultados inexactos o inapropiados, como ocurre con todos los sistemas de IA generativa". Luego, McAlister se limitó a decir que estaban mejorando estas funciones a medida "que evolucionen".

Este problema no es nuevo

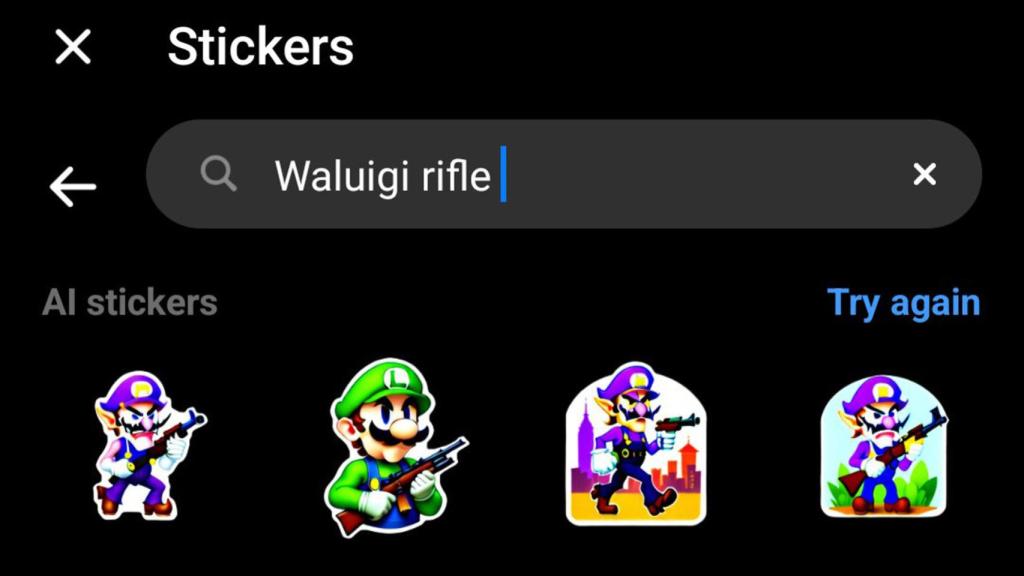

En octubre, se reportó un problema en la generación de stickers basados en IA en Facebook e Instagram. Esta novedad, que se está probando actualmente, tenía fallos que permitían generar todo tipo de contenido cuestionable, que incluían desnudos o armas. Esto, dadas las estrictas directrices de contenido de Meta, parecía inconcebible.

Imágenes de Luigi, de la franquicia de Super Mario Bros, con un rifle. Omicrono

Y es que desde que estas funciones de IA empezaron a surgir, muchas voces avisaron de que esto podía pasar. No fueron pocos los que recordaron el turbio pasado racista que marcó las primeras pautas de la inteligencia artificial, con modelos que volvían blancos a personas negras o que caían en sesgos raciales de mal gusto.

Uno de los casos más famosos fue el de Tay, una inteligencia artificial convertida en bot conversacional que acabó como perfil en la antigua Twitter. En tan solo unas horas, el perfil (que tendría que imitar los patrones de lenguaje de una joven de 19 años) acabó volviéndose racista, misógina y antisemita. Menos de un día después, tuvo que ser suspendida.