Cómo se creó El Equipo E, el vídeo viral de las Elecciones Generales

El vídeo del Equipo E es lo que se conoce como un deepfake, cada vez más populares en redes sociales para crear memes o incluso vídeos falsos para propaganda.

Noticias relacionadas

Las Elecciones Generales han pasado, y puede que no estemos más cerca de un gobierno estable, pero al menos tenemos los memes. Eso es lo que están pensando los internautas, que en las últimas 48 horas se han "lucido" con sus creaciones.

La actualidad política está dando para mucho material, pero el más sorprendente que hemos visto hasta ahora no es una imagen, ni siquiera un gif animado, sino un vídeo completo sobre el Equipo E.

Esta parodia del famoso Equipo A protagonizada por los líderes de los principales partidos españoles (y Albert Rivera) está dando vueltas por redes sociales por su gran calidad.

El deepfake del Equipo E

En vez de usar a actores maquillados para que se parezcan a los originales, los creadores del vídeo, FaceToFake, prefirieron usar una tecnología que está en boca de todo el mundo, el aprendizaje automático, para crear un "deepfake".

Los "deepfakes" son vídeos modificados por aprendizaje automático, y normalmente consisten en intercambiar la cara de una persona por la de otra. Aunque esta tecnología lleva años en desarrollo, no fue hasta principios de 2018 que realmente estuvo al alcance de todo el mundo con el lanzamiento de FakeApp, una app que facilitaba la creación de deepfakes.

Como estamos en Internet, la primera reacción de mucha gente fue crear pornografía con sus actores y actrices favoritos; pero pronto nos dimos cuenta del potencial que tenía esta tecnología.

Los "deepfakes" ya se han usado para crear vídeos falsos, en los que políticos aparecen en medio de actos ilegales, o realizando afirmaciones polémicas. Pero también se ha usado para crear humor, como es el caso del Equipo E.

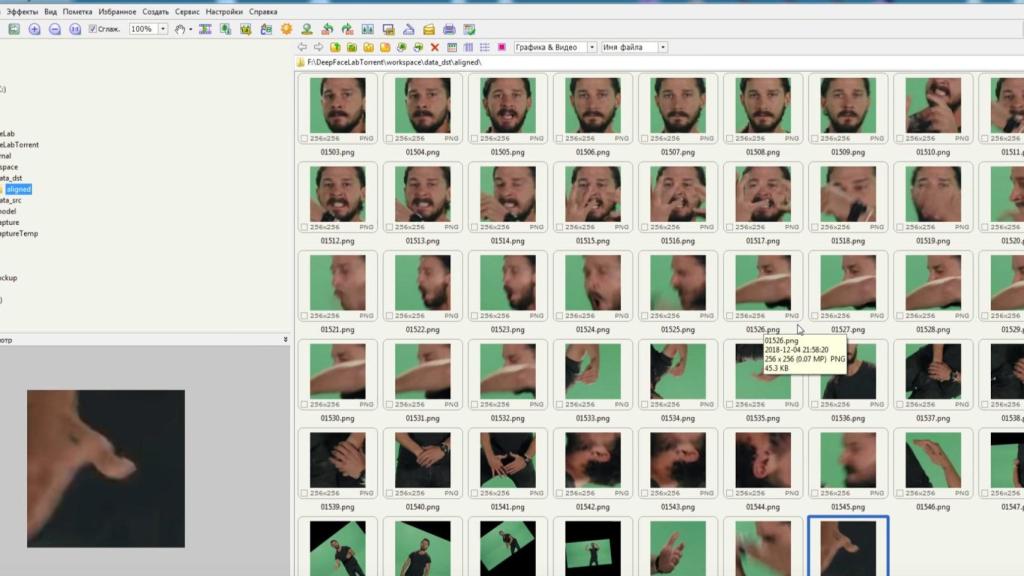

En este caso concreto, se ha usado DeepFaceLab, una app que se instala fácilmente en cualquier sistema Windows moderno, y permite usar la potencia de una tarjeta gráfica Nvidia o AMD (se recomienda lo primero) para crear "deepfakes".

Un "deepfake" normalmente parte de dos vídeos: la base que queremos modificar, y otro vídeo con la persona que queremos insertar; el programa analiza este segundo vídeo, aprendiendo cómo la persona habla, cierra los ojos y mueve los músculos de la cara. A continuación, analiza el vídeo a modificar y aplica la cara; la clave es que imita los movimientos de la persona original, incluyendo gestos, guiños y "tics".

Es gracias a esto que se consigue un resultado tan sorprendente, como por ejemplo, Santiago Abascal como M.A., con quien ha imitado la tonalidad de la piel.

Pero los "deepfakes" no siempre son tan graciosos. La posibilidad de usarlos para distribuir "fake news" o noticias falsas es real, y las redes sociales no parecen listas para ello. Facebook ha permitido este tipo de vídeos falsos en su red, incluso si muestran a candidatos políticos haciendo algo ilegal. Al igual que con las noticias falsas, su defensa es que los usuarios deberían ser los que decidan por su cuenta, y para ello ha creado sus propios "deepfakes" para demostrar cómo son.

Curiosamente, al mismo tiempo que este vídeo del Equipo E se ha hecho viral, Twitter ha pedido ayuda a los usuarios para decidir qué hacer con este tipo de vídeos. Su propuesta es mostrar un aviso al lado de los vídeos, avisando que han sido modificados; pero la duda es si será suficiente.