Una persona utilizando las Ray-Ban de Meta. Omicrono

Las gafas inteligentes de Meta ayudarán a las personas ciegas: ahora pueden describir lo que el usuario ve con más detalle

Las Ray-Ban de Meta incorporan dos nuevas funciones diseñadas para ayudar a las personas ciegas o con baja visión aprovechando su cámara y Meta AI.

Más información: Así son las gafas inteligentes que ayudan a las personas ciegas a 'ver' a través del sonido

Las gafas inteligentes Ray-Ban, de Meta, están ganando cada vez más popularidad en España y todo el mundo. Un dispositivo que cuenta con una cámara y con Meta AI, el asistente basado en inteligencia artificial (IA) de la firma, que es capaz de realizar una gran variedad de funciones,desde capturar fotos y vídeos para compartirlos en redes sociales hasta hacer llamadas de voz; y que cada poco tiempo se va actualizando con más características. Si recientemente se anunció la traducción de conversaciones en tiempo real, ahora la firma ha confirmado la llegada de una función para describir lo que el usuario ve con más detalle, ideal para personas ciegas o con baja visión.

Meta, compañía liderada por Mark Zuckerberg y propietaria de Facebook, WhatsApp e Instagram, ha anunciado a través de un comunicado oficial la incorporación de dos nuevas funciones para sus gafas inteligentes Ray-Ban que han sido diseñadas para ayudar a las personas ciegas o con baja visión. Aprovechando la cámara del dispositivo y Meta AI, ahora los usuarios pueden recibir descripciones más detalladas de lo que tienen delante siempre que pregunten al asistente inteligente de Meta sobre su entorno.

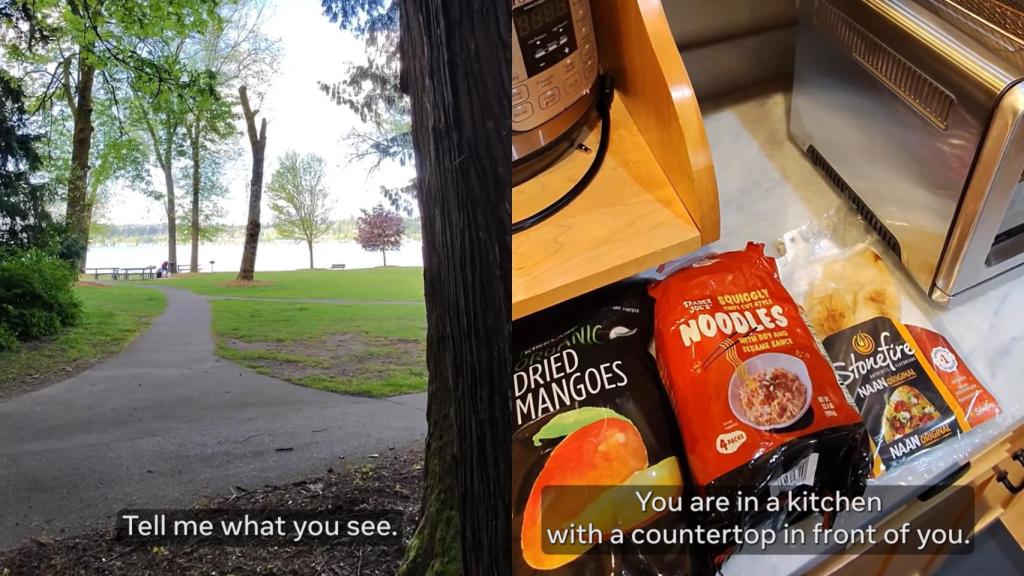

La compañía, que en el comunicado ha compartido un breve vídeo sobre esta función, ha señalado que esta función permite a Meta AI proporcionar respuestas detalladas en las gafas Ray-Ban Meta según lo que el usuario tenga delante. En el clip, que dura apenas un minuto, se puede ver cómo una persona ciega le pregunta a Meta AI por lo que tiene justo enfrente y esta le describe detalladamente que está en un parque junto al agua, con zonas de césped "bien cuidadas". También se muestra otro ejemplo en una cocina.

Captura del vídeo de la nueva función de Meta que describe lo que el usuario. Omicrono

Meta AI describe al usuario que tiene delante una cocina con comida variada en la encimera, "incluyendo noodles y naan". Una nueva e interesante función que se puede activar en la sección de 'Accesibilidad' de los ajustes del dispositivo a través de la aplicación Meta AI. Eso sí, a pesar de que esta característica está ya disponible, por el momento está limitada a los usuarios de Estados Unidos y Canadá. Sin embargo, Meta ha señalado que estas respuestas detalladas "se expandirán a otros mercados en el futuro", aunque no ha ofrecido más detalles al respecto.

Por lo que se desconoce la fecha en la que llegará a otros territorios y qué países tendrán acceso a ella. Por otro lado, Meta también ha confirmado la llegada a todos los mercados de una función denominada 'Llama a un voluntario' que anunció por primera vez en septiembre del año pasado como parte de una asociación con la organización Be My Eyes y que se desplegó en el mes de noviembre de forma limitada en Estados Unidos, Canadá, Reino Unido, Australia e Irlanda. "Se lanzará en los 18 países en los que Meta AI es compatible a finales de este mes", ha confirmado la empresa.

Gracias a esta función, los usuarios ciegos y con baja visión que utilicen las gafas inteligentes Ray-Ban de Meta pueden conectarse a una red de más de 8 millones de voluntarios videntes para obtener ayuda en tareas cotidianas, como pueden ser seguir una receta o localizar un artículo en una estantería de casa. Para ello, basta con decir "Oye Meta, sé mis ojos", para que un voluntario pueda ver el entorno del usuario a través de una imagen en directo de la cámara de las gafas y ofrecer descripciones o ayuda a través de los altavoces abiertos.