Silvio Savarese, profesor de Stanford y jefe de AI Research en Salesforce.

Silvio Savarese: “La inteligencia artificial no necesita parecerse a los humanos para transformar el mundo empresarial”

El profesor de Stanford e investigador de Salesforce defiende el concepto de inteligencia general empresarial por encima de las quimeras sobre las promesas de futuros distópicos de algunos actores de la IA.

Más información: De robots polifuncionales a la 'inteligencia de la Tierra': el futuro digital según los analistas

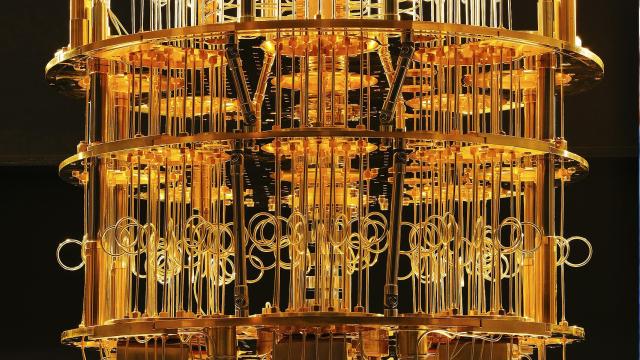

Mucho se habla de la posible llegada de una inteligencia artificial general que supere en capacidades a los humanos. Incluso hay quienes presumen de que ese escenario está casi a la vuelta de la esquina. Y, sin embargo, los involucrados en el desarrollo tecnológico no hacen sino alejar esas pretensiones, incluso acuñando conceptos alternativos con otras metas, como su implantación real en el tejido empresarial.

Es el caso de la inteligencia artificial empresarial (EGI, por sus siglas en inglés). Una terminología de nuevo cuño que no es más que el reflejo de cómo adaptar las herramientas actuales de IA y sus derivadas, como los agentes autónomos, a entornos reales de empresas y organismos públicos. Y, desde ahí, comenzar una verdadera revolución a hombros de esta tecnología.

"Esta EGI, no tiene que ver con hacer poesía como Shakespeare o pasar exámenes universitarios, sino con operar con consistencia en los flujos de trabajo reales de sectores como la banca, la salud o el marketing”.

El que defiende esta idea no es otro que Silvio Savarese, actual profesor adjunto de Ciencias de la Computación en la Universidad de Stanford, antiguo profesor de Ingeniería Eléctrica y Computación en la Universidad de Michigan, además de estar involucrado en el mundo privado como Chief Scientist y Head of AI Research en Salesforce.

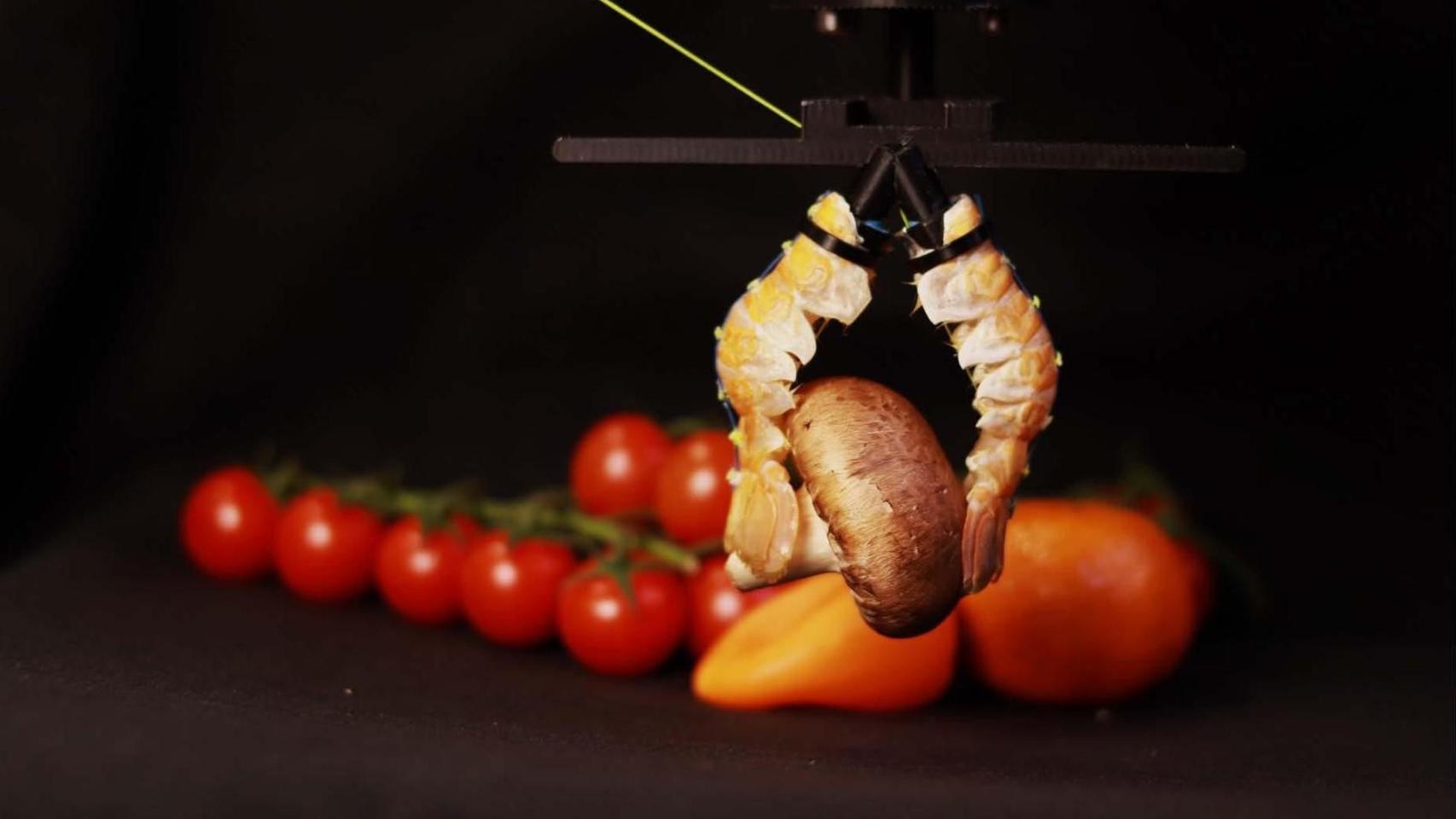

En esa línea, Savarese ha dedicado los últimos años a investigar cómo dotar a los agentes de IA de capacidades útiles en escenarios empresariales complejos. Según él, el desarrollo de estos agentes atraviesa tres grandes olas, desde la predicción hasta la autonomía física. “La primera ola fue la IA predictiva, basada en modelos de clasificación, regresión y segmentación. Después vino la generación de contenidos, con la irrupción de los modelos generativos como ChatGPT. Ahora estamos entrando en la tercera gran ola: la de los agentes inteligentes que ejecutan tareas por sí mismos”, señala.

Pero para Savarese, un agente no es simplemente un modelo de lenguaje como los que han copado titulares desde 2022. “Un agente es un sistema complejo con cuatro componentes clave: memoria, cerebro, actuador e interfaz”, explica el investigador. “La memoria permite persistencia y acceso al contexto; el cerebro planifica y razona; el actuador ejecuta las acciones; y la interfaz permite la interacción multimodal con el mundo. Y todos estos elementos tienen que trabajar de forma coordinada para que el agente no solo entienda, sino que actúe con sentido y de forma segura”.

La inconsistencia de la inteligencia artificial

Uno de los conceptos más interesantes que introduce Savarese es el de la inteligencia jagged, una forma elegante de nombrar la inconsistencia que caracteriza a muchos modelos actuales. “Hay modelos que hoy te resuelven un problema complejo y mañana fallan en tareas triviales. Esa inconsistencia es inaceptable en entornos empresariales. No puedes tener un agente que un día planifique una campaña de marketing y al siguiente cometa errores básicos con los datos del cliente”, advierte Silvio Savarese.

El profesor ha desarrollado un curioso gráfico conceptual para ilustrar este paradigma: una matriz con dos ejes —capacidad y consistencia— en la que solo los agentes situados en la esquina superior derecha serían aptos para entornos críticos. “Muchos modelos hoy se sitúan en zonas intermedias: o son consistentes pero poco capaces, o muy capaces pero impredecibles. El objetivo de la EGI es superar ese dilema”.

Llegamos así a la pregunta del millón: ¿cómo se consigue esto? Savarese apuesta por entrenar agentes en simulaciones realistas que reflejen los desafíos de la vida real. En otras palabras: olvidarnos de los tan manidos y populares benchmarks, y poner a la inteligencia artificial a trabajar en escenarios complicados, con datos incompletos, contradicciones y ambigüedad. “Igual que una aerolínea no pone un avión en vuelo sin probarlo en condiciones extremas, una empresa no puede desplegar un agente sin saber cómo va a reaccionar ante situaciones críticas”, sentencia.

Los ecosistemas multiagente

En cualquier caso, ni para este experto ni para nadie con dos dedos de frente cabe la posibilidad de que estos agentes actúen de forma aislada o en paralelo a los humanos. Aunque la telaraña que pueden crear por sí solos pueda incluso anticipar estos escenarios distópicos.

“La forma más básica es tener varios agentes que ejecutan tareas específicas. Pero lo que viene es aún más interesante es cuando logremos agentes personales que actúan como jefes de personal capaces de coordinar a otros agentes, entender tus preferencias y adaptarse en tiempo real a tus objetivos”, dice.

Y más allá de eso, apunta a un futuro en el que esos agentes personales colaboren con otros agentes ajenos a la organización, formando redes de cooperación autónoma: “Imagina que necesito alquilar un coche. Le pido a mi asistente que lo gestione. Él contacta con el agente de la empresa de alquiler, negocia precios y opciones, y me presenta la mejor alternativa. Todo sin que yo tenga que hacer nada más. Esto puede aplicarse al mantenimiento de electrodomésticos, a solicitar una hipoteca, o a agendar una cita médica”.

Eso sí, no será fácil. Esta clase de modelos multiagente plantean nuevos retos de gobernanza, interoperabilidad y, sobre todo, seguridad. “Hay que construir protocolos de interacción seguros. No es descabellado pensar en agentes maliciosos intentando piratear a otros para obtener información confidencial o desviar acciones críticas. La seguridad debe ser una prioridad desde el diseño”.

La IA como 'disrupción silenciosa'

En todo caso, lo que subyace al discurso de Silvio Savarese es un pragmatismo claro e inmediato, una apelación a alejarnos de las grandes y lustrosas promesas de la inteligencia artificial general y su supuesta llegada inminente. Él apela, en cambio, a las "disrupciones silenciosas", a los avances no tan notorios desde el punto de vista de la gran masa pero que son los que albergan la verdadera transformación económica y social.

“No hace falta que la IA tenga conciencia. Basta con que sea útil, predecible y adaptable. Las verdaderas revoluciones suelen ser silenciosas”, afirma el investigador. “Por eso la EGI no es un ejercicio académico ni una quimera futurista. Es una nueva categoría de sistemas que ya están empezando a funcionar. Son capaces de entender objetivos de negocio, adaptar sus acciones, aprender de la retroalimentación y coordinar tareas complejas. Lo verdaderamente transformador no es que parezcan humanos, sino que actúen con inteligencia en entornos reales”, concluye.