Robbie Litchfield, cofundador de Novodisq.

Silicon Valley halla nichos de negocio entre las ‘costuras’ de la digitalización

"Hay algunos vacíos en el sistema de almacenamiento y tratamos de cubrirlos", dice Supramani Sammandam, fundador de una de las startups visitadas por DISRUPTORES.

Más información: Se innova en la seguridad del dato, pero "sin una nube europea no hay soberanía".

Mientras los gigantes tecnológicos se dan codazos, para ponerse por delante en la carrera digital y abarcar lo más posible todos los ámbitos de la nube, la inteligencia artificial y la supercomputación, da la sensación de que se multiplican las compañías más pequeñas (algunas son startups, otras tienen un largo historial) que encuentran su nicho de negocio en ‘mejorar’ la eficiencia, la precisión, facilidad de uso y mejores precios de lo que ofrecen los grandes.

Y si bien esos gigantes, cada uno por su lado, parecen ofrecer el paquete completo, con todo lo necesario para que cualquiera pueda operar en la nube, o aplicar lo último en IA (tal vez con ayuda de una consultoría, por el grado de especialización requerido), da la sensación de que, mientras tratan de pillar el mayor trozo del pastel, se van dejando cabos sueltos y espacios en los que queda mucho por aprovechar. Se expanden, engordan y al traje se le abren las costuras.

Así lo ha podido apreciar DISRUPTORES - EL ESPAÑOL, durante una visita organizada por IT Press Tour, junto con varios colegas de prensa especializada internacional, al mítico epicentro de la innovación.

Las propuestas de las compañías con las que nos encontramos en Palo Alto, San José, Santa Clara, Mountain View… van más allá de ser meros intermediarios, asesores o personalizadores de producto para clientes finales. Véanse algunos casos:

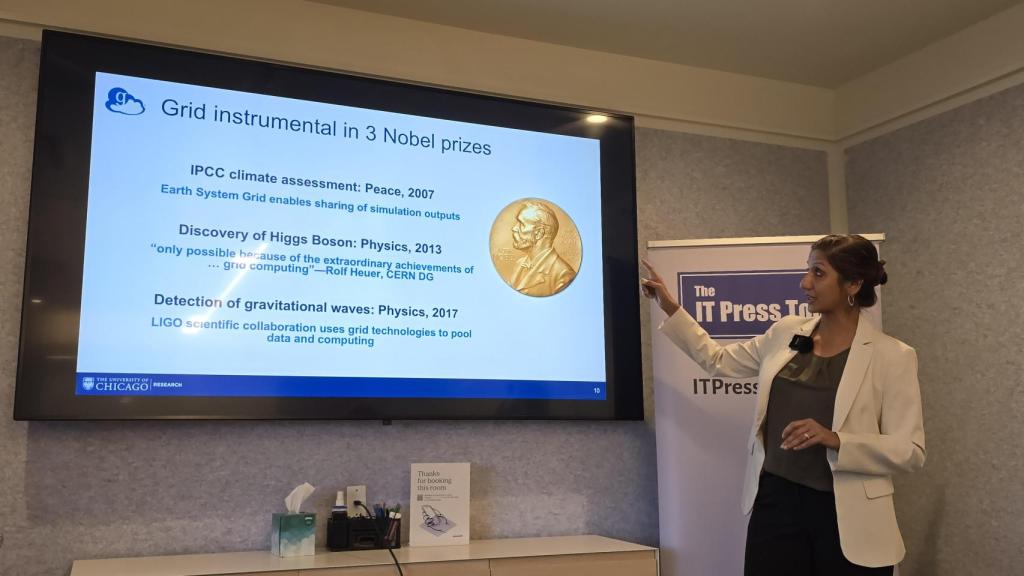

Globus, una organización sin ánimo de lucro auspiciada por la Universidad de Chicago, gestiona una red de ámbito mundial para facilitar recursos IT para el desarrollo de investigaciones científicas y la colaboración multiinstitucional con grandes equipos científicos de todo el planeta. Y también para pequeñas investigaciones. Es un concepto diferente a la nube, compatible con usar todas las nubes públicas o privadas. Una tecnología ‘grid’ que presume de haber sido utilizada en tres investigaciones premiadas con el Nobel, incluido el descubrimiento del bosón de Higgs y la observación de ondas gravitacionales.

Rachna Ananthakrishnan, directora ejecutiva de Globus.

La directora ejecutiva de Globus, Rachna Ananthakrishnan, expone que son ya 30 años de un servicio que ha evolucionado desde kits de herramientas de computación en grid a una “plataforma de investigación híbrida SaaS/PaaS, sostenible, escalable y segura”, para la transferencia e intercambio de conocimiento, búsqueda de metadatos, cálculo y automatización de datos con alto rendimiento.

El servicio de transferencia de datos es uno de sus pilares, “el usuario mueve los datos de aquí a allá… el propio dato sólo se mueve directamente de origen a destino, nunca pasa por nosotros”, incide Ananthakrishnan. El protocolo utilizado es GridFTP, para asegurar integridad y reinicios automáticos en caso de fallo. Los investigadores comparten carpetas o archivos con colaboradores externos usando credenciales institucionales, sin replicación de datos ni necesidad de nuevas cuentas.

También ofrece computación distribuida y automatización, permitiendo ejecutar funciones (principalmente en Python) con recursos distribuidos. Y un servicio de automatización (“flows”) que permite definir flujos de trabajo para tareas repetitivas, facilitando la adopción y participación comunitaria incluso en instituciones pequeñas.

La estructura se orienta a políticas de organización por sectores de interés común, en entornos descentralizados y multiinstitucionales, con un servicio global de gestión e identidades federadas. Además, invierte en asuntos punteros con los agentes IA. Es decir, se trata de una formidable red mundial de contactos e intercambio de conocimiento para el desarrollo científico.

Investigación sobre la covid

Por afinar en el ejemplo, este periódico preguntó a Ananthakrishnan si tuvo un papel esa estructura en la acelerada búsqueda coral de vacunas para la pandemia de 2020: “Fue mucho. Con esto quiero decir que fueron varios aspectos. Una de las primeras cosas que hicimos fue eximir las suscripciones. Cualquiera que investigara sobre la covid podía usar Globus gratis. Muchas universidades y laboratorios nacionales estaban investigándolo en ese momento. Hay un laboratorio virtual nacional que se creó como un laboratorio rápido para reunir a personas que usaban Globus para mover y compartir datos”.

Pero no se pone medallas. Bromea diciendo que ellos hacen “fontanería”, atendiendo cuando algo falla. En cuanto a confidencialidad, se queja un poquito: “Conseguir que la gente nos cuente historias de éxito no es una tarea fácil. Así que, si eres suscriptor o investigador, puede que nunca sepamos exactamente lo que haces. No te exigimos que nos lo digas. Normalmente lo descubrimos haciendo divulgación…”.

Afirma que Globus cumple con normativas como NIST y GDPR, permitiendo el uso de datos sensibles (PHI, PII) bajo acuerdos específicos. Y también aclara, sobre la suscripción, que el modelo es freemium: “Las funciones básicas son gratuitas para investigación sin ánimo de lucro… Pero las suscripciones de pago proporcionan características mejoradas”.

Helikai se propone automatizar las tareas IT con agentes de inteligencia artificial basados en los grandes modelos que mejor puedan adaptarse a cada caso de uso. Al contrario que Globus, esta es una auténtica startup recién creada (el año pasado) y centrada en una tendencia de lo más actual: automatizar procesos mediante agentes IA extremadamente especializados, a los que los cofundadores Jamie Lerner y Ross Fujii denominan “micro AI”.

Ross Fujii y Jamie Lerner, fundadores de Helikai.

Lerner explica que su aproximación nace de la experiencia de que los proyectos de IA suelen fracasar cuando intentan abarcar demasiado: “Pasamos de estas ideas muy grandes y elevadas a dar pasos muy, muy pequeños. Ese el núcleo de nuestro enfoque de micro IA”. El resultado, asegura, son agentes especializados que realizan una sola tarea, aunque con precisión 100% empresarial.

El extraño nombre de la compañía es uno de esos juegos de ingenio que suelen gustar a los emprendedores: “Pensando en la idea de iluminar, tomamos Helios, el dios griego del sol. Kai en hawaiano es el mar, el océano, así que quisimos simbolizar las profundidades de tus datos y negocio”, explica Fujii.

Muchos modelos IA

Pero lo importante es el modelo de su infraestructura, un RAG (Retrieval‑Augmented Generation) capaz de usar muchos modelos IA simultáneamente: “Puede ejecutar 20 o 30 modelos simultáneamente. Puedes preguntarle qué diría OpenAI, qué diría Gemini, qué diría Grok…”, subraya Lerner. “Lo que hace a nuestro servidor RAG bastante único es que está construido para la empresa, con control de acceso profundo, trazabilidad completa y loging de cada decisión”.

Helikai posee un catálogo de cerca de 200 agentes, cada uno para tareas extremadamente específicas como validar direcciones, leer órdenes de compra, calcular impuestos, interpretar imágenes médicas... aunque Lerner precisa que “hacen una sola cosa, pero podemos combinarlos en pipelines. Y podemos insertar interacción humana en cualquier punto. Si ve un descuento anormal, le pide al gerente que lo revise”.

Y lo más peculiar de su modelo de negocio es que, por cada tarea que hacen estiman la equivalencia en tarea humana, y cobran el resultado de descontar un 15% a lo que sería el precio de ese trabajo humano. “Somos humano menos el 15%”, bromea Lerner.

InfoScale promete protección en tiempo real para cualquier aplicación, ayudando a aislar los datos del usuario y garantizando sistemas de backup.

Presentación de Infoscale.

La historia de InfoScale, que asume la cuestión de la “resiliencia” de los datos como clave de supervivencia para las empresas, está llena de referencias de cambios de nombre y dependencias (Arctera, Symantec, Veritas), en las que sus responsables se han fajado cuarto de siglo. Y justamente acaba de ser adquirida por Cloud Software Group (CSG), un conglomerado de software empresarial formado en 2022 por la fusión de Citrix y TIBCO. Al celebrarse este encuentro todavía no se había comunicado oficialmente esa compra.

El director de producto, Joe D’Angelo, no espera que la compra cambie la orientación de su actividad, aunque sí se anuncia ya un cambio de comercialización, estableciendo una única SKU con todas las funcionalidades de InfoScale y uso ilimitado.

“Hemos visto la transición del mundo físico al virtual, de almacenamiento directo a SAN, la adopción de la nube, contenedores, hiperconvergencia y virtualización… hemos ido de la mano con nuestros clientes en estos puntos de inflexión. Nuestra solución busca resiliencia para tu negocio, resiliencia para tu empresa”, dice D’Angelo.

Considera que es fundamental identificar la creciente heterogeneidad de los entornos y la necesidad de resiliencia frente a amenazas como ciberataques y caídas de servicios en la nube. “No basta con tener copias de seguridad… se trata de tener resiliencia operativa, lo que implica orquestación, cargas de trabajo y servicios. Protegerte y garantizar capacidades RPO [Recovery Point Objective] y RTO [Recovery Time Objective]”. Es decir, cuánto es el máximo de datos que te puedes permitir perder, lo que define la frecuencia de las copias de seguridad y, por tanto, el punto al que se puede retroceder para la recuperación; y, el RTO, cuánto tiempo se puede permitir un servicio estar fuera de operación.

Resiliencia del futuro

“La resiliencia del futuro no es reactiva, es predictiva… Serán sistemas verdaderamente resilientes por diseño, que se adaptan continuamente incluso cuando el entorno cambia”, asevera.

También habla de copias de seguridad la neozelandesa Novodisq, en comunicación por teleconferencia para presentar un enfoque basado en hardware propio, con una bandeja 2u (que ocupa dos unidades del rack) Novoblade. Plantea una optimización del servidor basada en tres principios: se necesita más capacidad de almacenamiento, consumir menos energía y dejar que el cliente (suyo) lo experimente sin compromiso.

Robbie Litchfield, cofundador de la compañía, explica que usan una arquitectura de almacenamiento de ultra alta densidad, con muy bajo consumo energético y diseñada desde cero para resolver los límites físicos actuales del mercado. Las bandejas y discos SSD son de diseño propio y promete modularidad extrema, con escalabilidad desde cientos de terabytes hasta múltiples exabytes.

Litchfield muestra un prototipo para explicar que lleva 144 terabytes de NAND en bruto gestionados por firmware desarrollado en PCBs, y un SOC FPGA versátil ARM, para redes de alta velocidad. “Somos una empresa que construye hardware muy eficiente energéticamente y altamente modular para resolver el problema de densidad y consumo en almacenamiento de datos”.

Asegura que su sistema reduce el consumo energético a una décima parte. “Estamos hablando de un presupuesto de energía de una décima parte de la media de nuestros competidores”, insiste, para que quede claro que la reducción es del 90%. Subraya que “la capacidad de los centros de datos está limitada por la energía disponible… nuestro enfoque permite mayor densidad sin aumentar requisitos de infraestructura”.

Su negocio por ahora es “vender hardware. Después añadiremos soporte y más adelante software”, indica Litchfield, que no ve inconvenientes para poder “diseñar y fabricar en cualquier país que lo requiera, incluso marcas blancas”, y modular el tamaño de los elementos según necesidades específicas.

Computación y virtualización en el 'edge'

Otra compañía recién sometida a un proceso de adquisición es Scale Computing, de Mountain View, comprada por la texana Acumera, que en cierta medida podría considerarse su competencia. Ambas trabajan en gestión de redes, virtualización, seguridad y computación en el Edge.

La vicepresidenta de marketing, Marlena Fernández, tiene una explicación muy sencilla para el movimiento: “Tenían una posición financiera mucho más fuerte y aportan el capital que necesitábamos. La fusión tenía sentido porque ambos ayudamos a ejecutar aplicaciones en el edge donde no hay personal de TI”.

Marlena Fernández CMO de Scale Computing.

Aparte, establece una diferencia y una lógica: “Reliant [producto de otra compañía que también compró y ofrece ahora Acumera] es edge computing como servicio; nosotros somos edge computing on premise. Ahora podemos preguntar al cliente: ¿qué prefiere?”.

Craig Theriak, vicepresidente de producto, habla de su foco principal en “el comercio, que el 90% va por canal, y muchos que quedaron fuera del programa de VMware vinieron a nosotros”. Su producto estelar es AcuVigil, que “aporta servicios de red gestionada con visibilidad completa y cumplimiento”. La propuesta es visualización y gestión unificada con una misma aplicación y en una única pantalla. También aplica el concepto de ‘Zero-Touch’ para despliegues masivos, “desde desempacar un nodo hasta ejecutar aplicaciones sin intervención local”.

Para empresas sin personal TI

Scale plantea cuestiones como que muchos de sus clientes no tienen personal de TI. Matt McPhail, senior manager, lo ejemplifica de manera práctica, mostrando un dispositivo (no tiene un nombre concreto) que es lo que instalan en comercio: “Es un entorno que no tiene TI; sólo existe este pequeño dispositivo. Puedo entrar directamente al dispositivo del cliente y ver todo lo que ocurre. Hacemos escaneos de seguridad internos y externos para garantizar que funciona y si algo falla se puede desactivar automáticamente. Si se cae la conexión, el sistema cambia automáticamente a un módem celular…”.

Ese dispositivo, fundamental en su estrategia, puede conectarse con sensores y dispositivos IoT: “Detecta niveles de combustible en gasolineras y los expone a los equipos adecuados”. Es un concepto que definen como Edge-as-a-Service. “El usuario final nunca ve esta interfaz; todo lo manejamos nosotros. Se pueden aplicar cambios a miles de sitios desde una única consola. Y es muy fácil desplegar contenedores o máquinas virtuales en cientos de nodos. Puedes perder un nodo entero y las máquinas virtuales continuarán ejecutándose”.

VergeIO, con sede en Michigan, quiere dejar atrás a VMware y poner en la red una arquitectura de sistema operativo por igual en la nube pública o privada. Es otra de las compañías que compiten por el mercado de la virtualización, medio abandonado por VMware al centrarse en grandes clientes tras ser comprada por Broadcom en noviembre de 2023. Dice su jefe de marketing, George Crump, que estaban en ello “desde mucho de su venta”, con una versión de su producto en el mercado desde 2019.

Su producto principal es VergeOS, un sistema operativo para la nube privada que facilita a organizaciones y proveedores de servicios ofrecer infraestructura autónoma. Sus tres mercados clave son esos proveedores de servicios cloud y gestionados. Clientes que buscan modernizar su infraestructura privada (especialmente migraciones desde VMware). Y la modernización de hardware VxRail, para reutilizar hardware existente con mejor rendimiento y eficiencia.

Competencia de VMware

Crump pone énfasis en la diferencia entre el enfoque tradicional de la “pila IT” (múltiples capas y equipos) y la solución de VergeIO, integrando todo en una sola base de código. Con esto mejora la eficiencia, hay menos duplicidad y mejor rendimiento, incluso en hardware antiguo. “Es una única base de código que controla todo, y es una experiencia muy unificada… Si puedo entregar las mismas funciones en una fracción de líneas de código, seré más eficiente”.

Y en la competencia por el espacio de la virtualización, asegura ofrecer un servicio mucho más barato que VMware, con una única licencia por servidor físico: “No penalizamos al cliente porque tenga cuatro procesadores y 200 núcleos… No cobramos por la capacidad que tengan”.

En cuanto a la migración y compatibilidad desde entornos VMware, aprovecha la API de backup del propio VMware para transferir configuraciones y datos casi perfectamente. “Cuando un cliente migra, apunta su entorno VergeOS al entorno vCenter y este piensa que somos un producto de backup. Nos da todo… y podemos convertirlo casi perfectamente”, se ufana Crump.

Destaca la eficiencia en deduplicación global de datos del software de VergeIO, que permite transferencias y almacenamiento optimizados y escalar a cientos de nodos y miles de “tenants” (espacios aislados dentro de una plataforma compartida) virtuales. “La deduplicación está integrada en el núcleo del sistema operativo… Podemos transferir datos entre nodos sin tener que ‘rehidratarlos’”, afirma el jefe de marketing.

Crump introduce el concepto de IO Guardian, un servidor dedicado que replica datos y permite recuperación instantánea en caso de fallo catastrófico, sin necesidad de restaurar todo el entorno. “En tiempo real, el sistema operativo negocia con el servidor IO Guardian qué datos necesita y los recupera… El entorno del cliente no experimenta ninguna interrupción ni pérdida de datos”.

Y añade otra peculiaridad de la virtualización extrema: “Convertimos el centro de datos entero en un archivo, y puedes moverlo donde quieras”. Rematando con toque propio de su despeño como responsable de marketing: “Desde la compra de VMware, somos aproximadamente un 80% menos costosos que ellos”.

Almacenamiento nativo en la nube

Zettalane, con sede en Santa Clara, anuncia un “almacenamiento nativo” en la nube, redefinido y que mejora las prestaciones naturales ofrecidas por las superescalares. Es una startup creada en 2018 por el emprendedor Supramani Sammandam, que se dedica a el almacenamiento de datos corporativos en la nube, con los objetivos de mejorarlo y simplificarlo.

Sammandam reprocha que los proveedores llevan arquitecturas antiguas a la nube sin rediseñarlas. “Traen su stack completo que antes corría on prem… Y eso no es realmente nativo de la nube”. Además, resulta costoso y obligan a empezar con tamaños grandes, sin adaptarse a pequeños consumidores, reprocha. “Los pequeños jugadores quedan fuera… ¿qué pasa si alguien quiere solo cuatro gigabytes?”.

Su propuesta se basa en dos productos principales, un sistema de almacenamiento de ficheros basado en ZFS (Zettabyte File System) híbrido y Maya Scale, con bloques de almacenamiento NVMe que ofrece “más de dos millones de IOPS y es extremadamente más rápido que el block storage nativo”.

En cuanto a su aplicación de ZFS (un sistema de archivos y gestión de volúmenes que fue creado en 2001 por Sun Microsystems), detalla que guarda los metadatos en NVMe/SSD y los datos en Object Storage. “No usamos caché; los datos se escriben directamente en el object storage y se pueden alcanzar rendimientos de cuatro gigabytes por segundo”, proclama Sammandam.

En su resumen, condensa que su producto no requiere conexión ni telemetría de la empresa, es más rápido que soluciones nativas del cloud y más económico, con “ahorro del 70%” en almacenamiento de alto throughput. Añade escalabilidad modular, utilizando pares HA independientes “para evitar cuellos de botella en el controlador de almacenamiento”. Confiesa preferencia por Google Cloud porque “tiene mejores redes y condiciones” y “AWS no prioriza a startups pequeñas”. Su precio lo fija “por CPU. Unos pocos centavos por CPU. No se ha basado en capacidad”.

“Hay algunos vacíos en el sistema de almacenamiento y tratamos de cubrirlos”, concluye Sammandam.