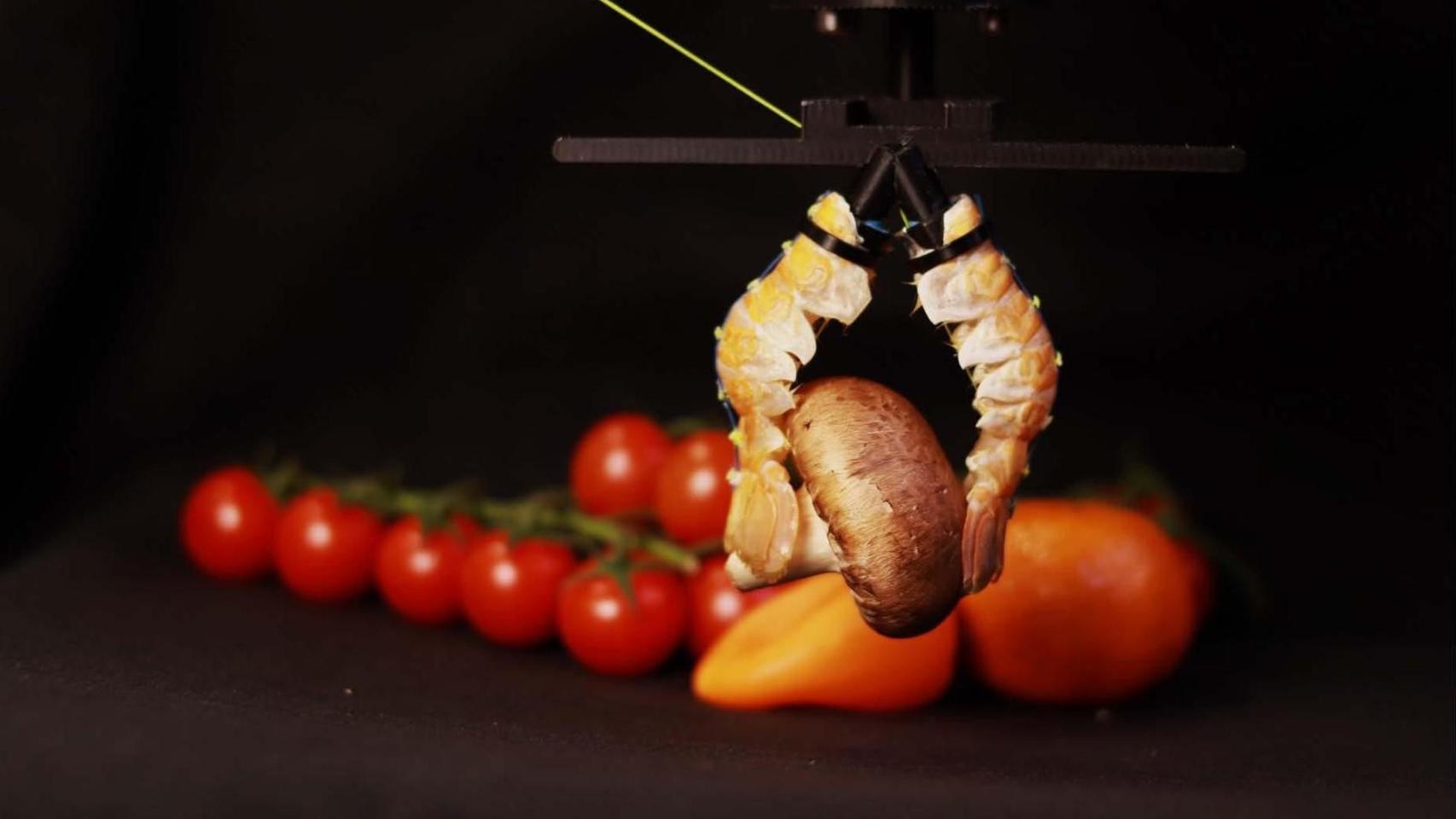

Efectos de un bombardeo sobre la Casa de las Flores. BNE

Las guerras lo destruyen todo a su paso y con inteligencia artificial podremos medir la devastación desde el cielo

El CSIC usará las imágenes de satélite y redes neuronales para encontrar edificios derribados con artillería en guerras como la de Siria.

Noticias relacionadas

Es una de las imágenes más habituales que vemos durante una guerra, sin importar dónde se esté produciendo la crisis en cuestión: los edificios destruidos por la artillería enemiga. No en vano, la destrucción de edificios durante una guerra es una forma específica de violencia particularmente dañina para los civiles y comúnmente utilizada para desplazar poblaciones.

Sin embargo, los datos suelen ser escasos e incompletos, lo que limita la capacidad de reacción y la respuesta de ayuda humanitaria. Por eso, cada vez se emplean más las imágenes de satélite en alta resolución, pero no hay métodos eficientes automatizados que ayuden en esta tarea y el margen de error es muy elevado. Y esa barrera es la que hace que organizaciones como las Naciones Unidas, el Banco Mundial y Amnistía Internacional, que usan imágenes por satélite para evaluar los daños de las guerras, siempre complementan la teledetección con la clasificación manual humana.

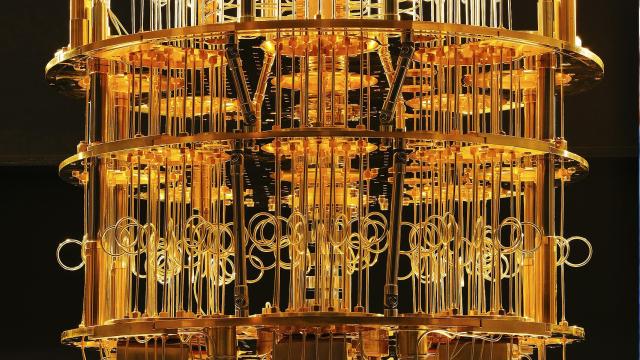

Pero los científicos del CSIC quieren dar el salto de calidad que necesita esta técnica tan urgentemente. En ese sentido, un equipo de sus investigadores ha desarrollado un algoritmo que permite monitorizar la destrucción causada por conflictos armados a partir de la comparación de imágenes de satélite.

El método, desarrollado en un proyecto coliderado por Hannes Mueller, del Instituto de Análisis Económico del CSIC (IAE-CSIC), y Andre Groeger, de la Universitat Autónoma de Barcelona (UAB), se basa en redes neuronales que han sido entrenadas para detectar en imágenes de satélite características de destrucción de ataques con armamento pesado (artillería y bombardeos), como los escombros de edificios derrumbados o la presencia de cráteres de bombas.

Los investigadores creen que “el etiquetado manual humano de todo nuestro conjunto de datos costaría aproximadamente 200.000 euros y las repeticiones adicionales de imágenes aumentarían este coste casi proporcionalmente. Con un método automatizado como el nuestro, una mayor frecuencia de imágenes ayuda a mejorar la precisión y el coste adicional es pequeño”.

Probado en Siria

En el trabajo, publicado en la revista Proceedings of the National Academy of Sciences (PNAS), los científicos han aplicado este método para monitorizar la destrucción de seis de las principales ciudades de Siria (Alepo, Daraa, Deir-Ez-Zor, Hama, Homs y Raqqa), azotadas por un conflicto bélico desde hace más de diez años. Los resultados muestran que es muy eficiente en la monitorización. “Nuestro enfoque”, dicen los científicos, “se puede aplicar a cualquier área poblada siempre que se disponga de imágenes satelitales repetidas de alta resolución”.

“Un elemento esencial del desarrollo”, puntualiza Mueller y autor principal del artículo, “es que la red neuronal superpone y compara imágenes sucesivas de un mismo lugar contrastándolas sobre una línea temporal que incluye siempre una primera imagen antes del conflicto bélico”.

Otra novedad es la incorporación de información espacial y temporal, es decir, aquella información que da contexto a la observación de destrucción. Asimismo, la herramienta incorpora un método novedoso de etiquetado de las imágenes: el sistema es capaz de hacer suposiciones razonables utilizando la información contextual y entrenar el algoritmo con la información de destrucción alrededor de un edificio.

Lidiar con los falsos positivos

Los métodos automatizados deben ser capaces de detectar la destrucción en un contexto donde la gran mayoría de imágenes no aparentan destrucción. Pero a menudo interpretan como derribados edificios que realmente no lo están, dando lugar a una elevada tasa de falsos positivos.

Incluso en Alepo, ciudad fuertemente castigada por la guerra, solo el 2,8% de todas las imágenes de áreas pobladas contienen un edificio que fue confirmado como destruido por el Programa de Aplicaciones Operacionales de Satélites de las Naciones Unidas (UNOSAT, en sus siglas en inglés) en septiembre de 2016, donde hacen una clasificación manual.

La precisión baja es “un problema muy grave”, explica Mueller. Incluso en ciudades fuertemente castigadas por los conflictos, solo el 1% de los edificios son destruidos. “De ahí que su detección sea como buscar una aguja en un pajar. Si tenemos falsos positivos en las imágenes, el margen de error se dispara rápidamente. En este caso, la precisión de un 20%, por ejemplo, quiere decir que, si un algoritmo dice que algo está destruido, sólo el 20% de lo que dice está realmente destruido”, detalla.

El estudio demuestra que el algoritmo entrenado es capaz de identificar daños en zonas de la ciudad de Alepo que no forman parte del análisis de UNOSAT. También evidencia que su método es capaz de identificar bombardeos en las seis ciudades.