Los ponentes en la primera de las mesas organizadas por la UC3M. De izquierda a derecha: Carlos Balaguer (catedrático de Ingeniería de Sistemas y Aeronáutica), Victoria Pavón (catedrática de Lengua Española) y Paloma Martínez (catedrática de Ciencias de la Computación e Inteligencia Artificial).

El español, 'combustible' para una inteligencia artificial que sepa de emociones y que genere valor para nuestro país

Investigadores de la UC3M y portavoces de la Biblioteca Nacional, Ametic o Telefónica exponen los retos y oportunidades de 'educar' a la IA en español.

Con alrededor de 600 millones de hispanohablantes en todo el mundo, el idioma español es uno de los grandes activos con que contamos en la carrera digital. Actualmente, los principales sistemas de inteligencia artificial están entrenados y modelados en inglés o chino, luego siendo adaptados al resto de lenguas del mundo. Ello no sólo trae consigo sesgos e ineficiencias en su funcionamiento, sino que limita enormemente la capacidad emprendedora y científica en estas lides.

Para revertir esta situación existen numerosas iniciativas que buscan situar el español en primera línea de la contienda tecnológica. Sin ir más lejos, las iniciativas LeIA o MarIA, con el objetivo de desarrollar amplios corpus lingüísticos que puedan ser usados en estos modelos, o del más amplio PERTE de la Nueva Economía de la Lengua, dotado de 1.100 millones de euros regados con fondos europeos.

Con objeto de analizar los retos, pero también las oportunidades, en torno al uso del español en la inteligencia artificial, la Universidad Carlos III de Madrid organizó esta semana un evento en su Campus de Puerta de Toledo. En él, el Vicerrectorado de Política Científica hizo público un mapa de capacidades con los principales grupos de trabajo e investigación de esta institución en la materia, muchos de cuyos expertos participaron -junto a representantes del ámbito privado- en sesiones de discusión en el marco de esta misma cita.

La jornada, dentro del marco de los Retos de I+D+I que cofinacia la Comunidad de Madrid con fondos Feder, fue inaugurada por Cristina Gallach, Comisionada Especial para la Alianza por la Nueva Economía de la Lengua. La dirigente explicó las iniciativas del Ejecutivo en torno al PERTE que lleva el mismo nombre, partiendo de la riqueza que aporta el español y el resto de lenguas cooficiales y su potencialidad para conformar "el combustible" que alimente el motor de próximas generaciones de inteligencia artificial y otras muchas aplicaciones, también en el ámbito audiovisual.

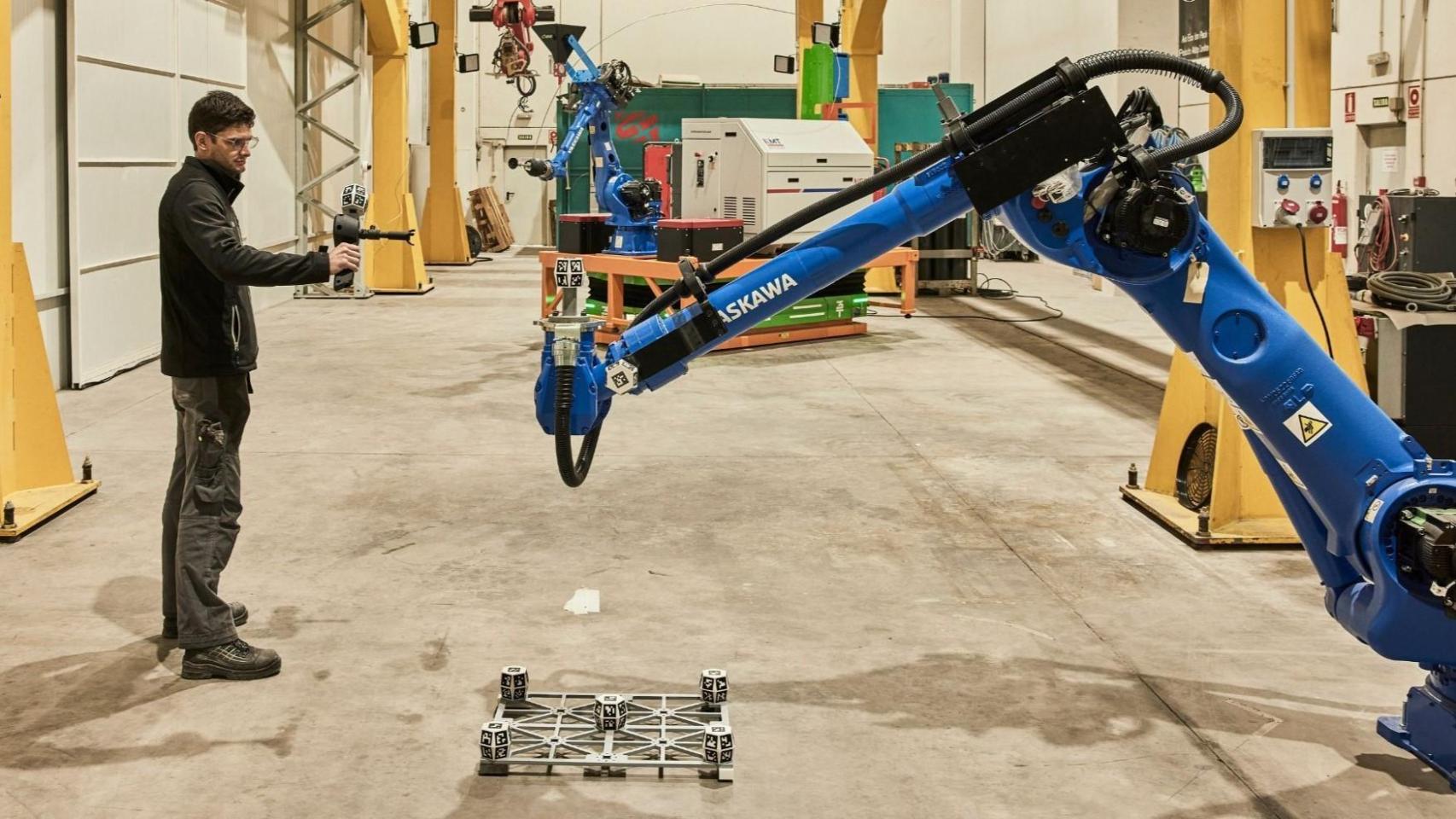

Tras su intervención, fue el turno de algunos de los grandes investigadores de la UC3M en la materia. Entre ellos, Carlos Balaguer, catedrático de Ingeniería de Sistemas y Automática, codirector del grupo de investigación Laboratorio de Robótica (Robotics Lab) de esta universidad y coordinador del Madrid Robotics Digital Innovation Hub RoboCity2030.

Balaguer se ha mostrado optimista sobre las posibilidades del uso de la lengua en la arena tecnológica ("hay un gran nicho en la robótica y en las comunicaciones, porque no podremos competir con Siri o de tú a tú con las 'big tech'") aunque con puntualizaciones: "El enganche emocional es fundamental en la relación entre máquinas y personas, especialmente pacientes o gente mayor. Y los sentimientos no se transmiten sólo por las palabras. Y luego hay otro debate sobre la privacidad de muchos de estos sistemas, en concreto hacia aquellos que pueden no ser perfectamente conscientes de lo que dicen en un momento concreto, como los enfermos de Alzhéimer".

Coincide en ese diagnóstico Victoria Pavón, catedrática de Lengua española e investigadora del grupo Gramática, Léxico, Discurso e Historia, reconoció que la "enseñanza de la lengua está muy ligada a la inteligencia artificial, ya no sólo en esta clase de aplicaciones, sino también para facilitar el conocimiento de nuevos idiomas. La propia voz nos puede permitir muchas cosas, incluyendo el estado de ánimo o su origen". La experta adelantó que, para continuar con los avances en esta particular confluencia, debemos "aunar la lingüística computacional con la tradicional".

Y esa apelación tocaba directamente a Paloma Martínez, catedrática del Área de Ciencias de la Computación e Inteligencia Artificial, directora del Departamento de Informática UC3M y codirectora del grupo de investigación Human Language and Accessibility Technologies (HULAT).

"La comunicación con las máquinas es muy importante, pero es necesario hacerla sin fricciones ni tener que adaptar nuestro lenguaje al suyo. Y eso implica muchas tecnologías de tratamiento de texto, modelos de IA y de 'deep learning', etc. que deben integrarse en las distintas aplicaciones", explicó. Martínez reconoció, no obstante, que "estamos en manos de las grandes tecnológicas que entrenan sus sistemas en inglés" y que falta incorporar a estas apps "conocimientos específicos para casos de uso concretos más allá del idioma".

Un panorama innovador muy real

Estas premisas, surgidas de la Academia, son luego traducidas en traslaciones reales y pragmáticas en el ámbito empresarial y comercial. En el evento organizado por la Universidad Carlos III de Madrid y moderado por Alberto Iglesias Fraga, subdirector de D+I, pudimos oír algunos de estos testimonios de la mano de sus propios protagonistas.

Es el caso de Mar Pérez Morillo, directora de la división de Procesos y Servicios Digitales de la Biblioteca Nacional de España, institución que lidera junto con el Barcelona Supercomputing Center el desarrollo del proyecto MarIA: el primer modelo de IA masivo de la lengua española.

De izquierda a derecha: Alberto Iglesias Fraga, subdirector de D+I, Mar Pérez Morillo (Biblioteca Nacional de España), Enrique Serrano (Ametic) y Richard Benjamins (Telefónica).

"Nosotros tenemos el material, debido a nuestra misión de conservar todo el patrimonio documental en español. Contamos con 3,5 petabytes de información, de los que alrededor de 1 Pb es contenido nativo digital y el resto procede de la digitalización de otros archivos. Hacemos recopilaciones masivas de los dominios '.es' y queremos, con la colaboración con el BSC, convertir este conocimiento en cosas que puedan ser aprovechadas tanto por ellos como en nuestros propios servicios", explicó.

Cómo democratizar las aplicaciones de IA en español al tejido empresarial es uno de los asuntos pendientes que quedan por resolver. En ese sentido, Enrique Serrano, presidente de la comisión de Inteligencia Artificial y Big Data de la patronal Ametic y miembro de la comisión ejecutiva de Gaia-X, reconoció que "el estado del arte cambia muy rápidamente, cada pocos meses, y eso no ayuda a que la pyme conozca cómo utilizar esta innovación o que sepa cómo puede mejorarle su cuenta de resultados". Apela, por tanto, a la formación para romper esta barrera, a "sacar la investigación del armario" en formato 'open source' y a seguir peleando por una normativa que ayude a su expansión responsable. "Nos quedan cinco años para que la regulación madure", anticipaba Serrano.

Por último, Richard Benjamins, Chief AI & data strategist en Telefónica y experto externo del Observatorio de IA del Parlamento Europeo (EPAIO) y miembro del proyecto LeIA, puso sobre la mesa una mirada más crítica afirmando que "la gente cada vez entiende más lo que estas tecnologías del lenguaje pueden hacer. Pero el español en digital está dominado por empresas extranjeras que utilizan sus propios corpus, basados en modelos que no sabemos cómo funcionan. Y eso implica que hay problemas en la unidad del idioma, en la diversidad del idioma o en su misma riqueza. Al final el español en un mundo digital está siendo cada vez más pobre si no hacemos algo".