Así es Chat with RTX de NVIDIA NVIDIA El Androide libre

Nvidia va directa contra Microsoft: así es su chatbot que no necesita internet frente a Copilot y ChatGPT

Ya puedes instalar Chat with RTX en un PC con Windows para tener todo un modelo de lenguaje mayor conectado a los datos que elige el usuario.

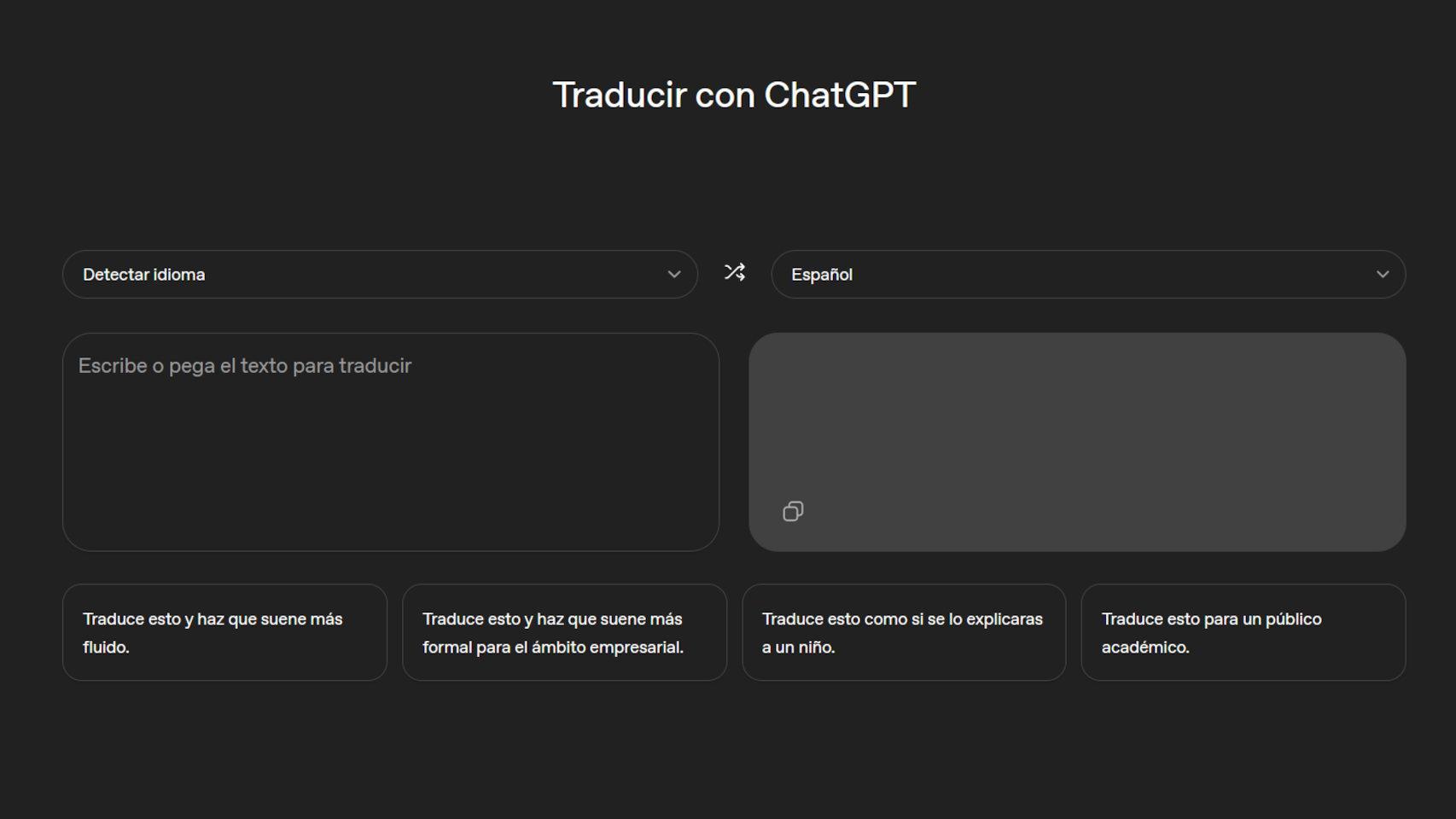

ChatGPT ya se puede usar en un móvil para interactuar con la voz, pero para su funcionamiento necesita conectarse a Internet, ya sea a través del WiFi o los datos móviles. La propuesta de NVIDIA con Chat With RTX es ofrecer a cualquier usuario la posibilidad de instalar en su PC un chatbot que funciona sin conexión para ser un modelo de lenguaje mayor que se conecta al contenido almacenado localmente.

Es decir, que 'extrae' los datos de lo que el usuario seleccione de su PC y en ningún momento se conecta a un servidor externo. Esta es la gran propuesta de NVIDIA a través de una demo que se puede instalar desde hoy mismo gracias al anuncio hecho. De hecho, NVIDIA lo denomina como un LLM local.

Y lo mejor de todo es que pone la privacidad como la gran protagonista en su experiencia, ya que el mismo usuario puede seleccionar las carpetas para que Chat with RTX se encargue de analizarlas y así reciba las consultas del mismo. Justo al revés que ChatGPT, Gemini o Copilot de Microsoft que exigen una conexión a Internet y el uso de los datos del usuario; hace poco se supo la decisión tomada por Google para leer los mensajes de la app Mensajes para entrenar a su IA.

Cómo funciona y qué necesita Chat with RTX

Lógicamente, al estar frente a un modelo de lenguaje mayor se necesitan una buena cantidad de recursos para poder utilizarlo y es aquí donde entran en juego las gráficas o GPUs de NVIDIA. Estos son los requerimientos necesarios para tener todo un chatbot local con algunas experiencias simplemente increíbles:

- Una GPU NVIDIA GeForce serie RTX 30 o 40 o NVIDIA RTX Ampere o Ada con al menos 8 GB de VRAM.

- RAM: 16 GB como mínimo.

- Windows 11.

- Controlador Geforce: 535.11 o superior.

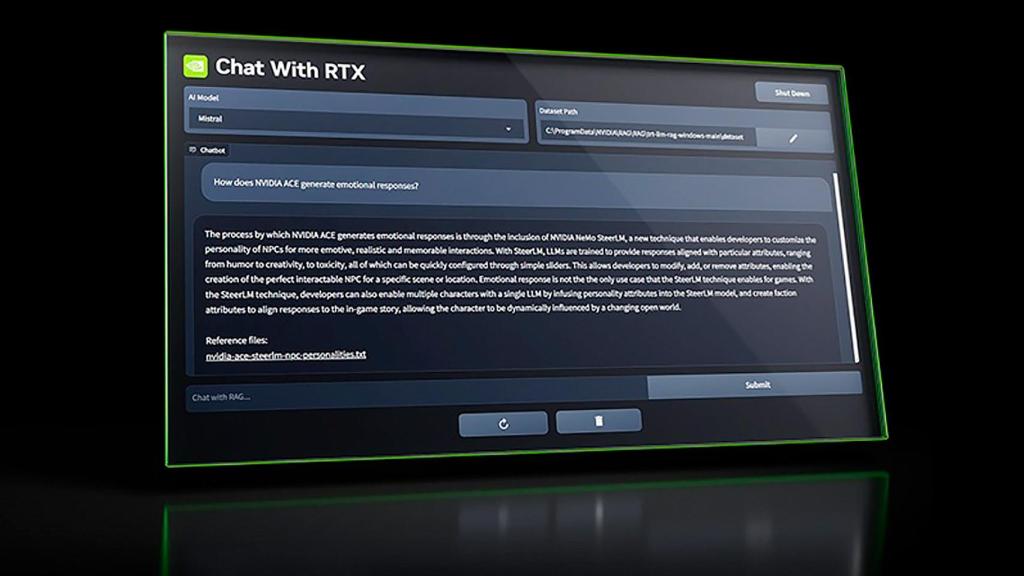

Imagen de una consulta hecha al Chat with RTX de NVIDIA NVIDIA El Androide libre

Una vez que esté descargado e instalado, se puede conectar la app Chat with RTX con el contenido almacenado localmente como documentos, archivos PDF, vídeos y más. Se puede incluso seleccionar los datos locales que quiere que el chatbot gestione para que así el usuario pueda realizar consultas sin tener que ir a través del contenido. Todo lo que aparezca en el contenido seleccionado por el usuario puede ser consultado como si se estuviera frente a ChatGPT o Gemini de Google.

También, tiene la opción de que Chat with RTX busque información en vídeos de YouTube. Lo único que hay que hacer es copiar la dirección URL del vídeo en la app y entonces realizar las consultas necesarias sobre el contenido del vídeo. Chat with RTX se encargará de proporcionar las respuestas adecuadas.

Create A Personalized AI Chatbot with Chat With RTX - NVIDIA

Y lo mejor de todo: una app LLM local como Chat with RTX no transmitirá ningún tipo de datos a los servidores cloud de la compañía para entrenar su propia IA u otra serie de objetivos. Lo único que se necesita es un PC bien potente que pueda manejar el chatbot como un modelo de lenguaje mayor. Chat with RTX se puede descargar a continuación con un tamaño de archivo de 35 GB:

NVIDIA, según NeoWin, ha marcado esta app como una demo técnica gratuita, lo que podría sugerir que planea en algún momento convertirla en de pago o pasar a una suscripción mensual con nuevas características. Lo que queda claro es que es una gran alternativa a Copilot en Windows 11, y más si cabe cuando la experiencia de Microsoft exige la conexión a Internet.