Un cerebro de neón. Wikimedia (PD)

Máquinas que aprenden como tú

Los humanos somos muy listos y necesitamos muy poca información para adquirir conocimientos. Ahora, un algoritmo es capaz de imitarnos para aprender a ser creativo.

Noticias relacionadas

El proceso de aprendizaje de los humanos es muy complejo y eficaz. Los niños aprenden a reconocer objetos a partir de muy pocos ejemplos, e incluso pueden imaginar otros conceptos que ni siquiera han visto. Por ejemplo, si viéramos por primera vez un patinete quizá no lo identificaríamos enseguida, pero sí sus partes: manillar, plataforma, ruedas. Y podríamos deducir su funcionamiento a partir de conocimientos previos. Ahora, investigadores de las universidades de Nueva York y Toronto y del MIT han desarrollado un algoritmo que trata de imitar ese proceso y hace que las máquinas no sólo aprendan, sino que puedan "aprender a aprender".

El trabajo, que aparece en la revista Science, supone un avance significativo dado que puede acortar drásticamente el tiempo que tardan los ordenadores en aprender nuevos conceptos y, además, abre la puerta a que estas máquinas realicen tareas más creativas.

Mientras que los seres humanos sólo necesitan unos pocos ejemplos para entender conceptos tales como un paso de baile, un objeto nuevo en la cocina o una letra de un alfabeto desconocido, las mayoría de las máquinas actualmente requieren de cientos o miles de ejemplos previamente programados para identificar y poner en orden estos conceptos.

"Hoy en día, sistemas de aprendizaje hay muchos", comenta a EL ESPAÑOL Óscar Fontenla Romero, secretario de la Asociación Española para la Inteligencia Artificial (AEPIA) y profesor en la Universidade da Coruña, que añade: "El problema suele ser extraer lo relevante de la información recogida, algo que tradicionalmente se realiza a través de patrones representativos".

Para acortar este proceso en ordenadores, los investigadores autores del estudio proponen un camino nuevo, bautizado Programa de Aprendizaje Bayesiano, más parecido al proceso de aprendizaje humano. En él, los conceptos se representan, a su vez, por programas sencillos probabilísticos. Es decir, al identificar una letra (la "A", por ejemplo) se genera un miniprograma que el propio sistema escribe sin necesidad de intervención humana, y que puede descomponer la grafía en sus partes esenciales y volver a componerla.

A diferencia de los programas comunes de ordenador, que reproducen lo que previamente almacenan en forma de colecciones de características o "patrones de reconocimiento", este camino permite a la máquina detectar las posibles variaciones del concepto aprendido, como por ejemplo las diferentes maneras en que la gente escribe a mano la letra "A".

"Nuestros resultados muestran que podemos desarrollar mejores algoritmos a partir de analizar cómo resuelve la gente un problema", explica Brenden Lake, investigador en el Centro de Ciencia de Datos de la Universidad de Nueva York y autor principal del artículo. "Por otra parte, este trabajo apunta a métodos prometedores para reducir la brecha que existe para ciertas tareas de aprendizaje automático", añade el experto.

Aprender a aprender

Es más, este modelo también "aprende a aprender"; es decir, mediante el uso de los conceptos elaborados previamente es capaz de acelerar el aprendizaje de otros nuevos. Por ejemplo, puede echar mano del conocimiento del alfabeto latino para aprender las letras del alfabeto griego.

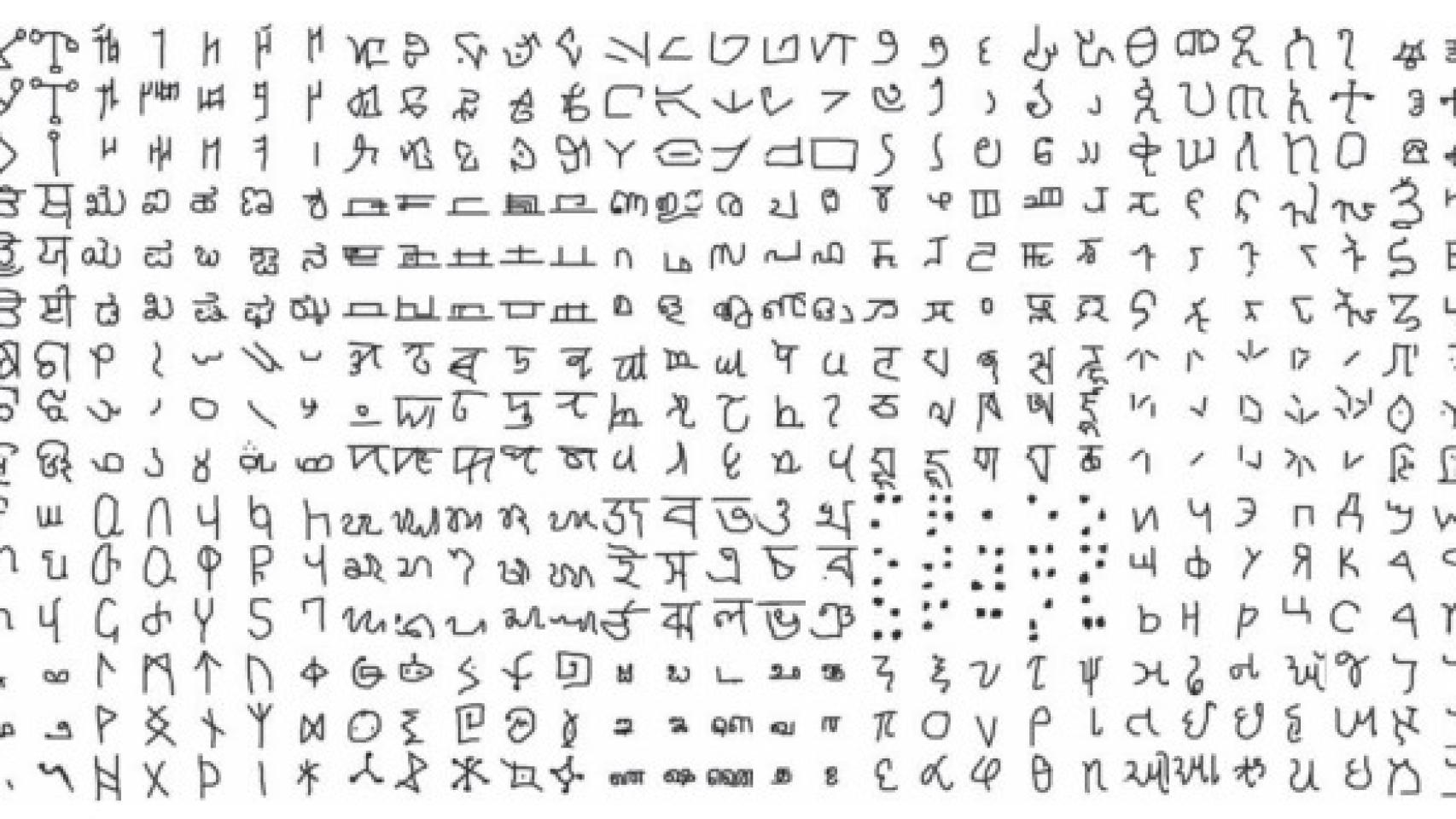

Los autores aplicaron su modelo a 1.623 tipos de caracteres escritos a mano en 50 sistemas de escritura del mundo extraídos de la enciclopedia online de alfabetos Omniglot.com como el hebreo, el griego, el coreano, el sánscrito, el tibetano e incluso letras inventadas, como las del lenguaje universal de la galaxia (ULOG) o las que aparecen en la serie de televisión Futurama.

Muestra de caracteres que se han usado en el estudio.

Para comprobar los resultados de este estudio, los investigadores organizaron una competición entre hombre y máquina: hicieron que varias personas y un ordenador con este algoritmo reprodujeran, cada uno, series de caracteres escritos a mano después de haber mostrado un solo ejemplo de cada. En algunos casos se les pidió que crearan nuevos caracteres del mismo estilo que aquellos que les habían mostrado.

A continuación, mostraron los resultados, junto con los caracteres originales, a varios grupos de evaluadores, y se les preguntó si eran capaces de identificar los símbolos escritos por el ordenador, en varios test de Turing (la prueba usada para medir la habilidad de una máquina) visuales. Si bien las respuestas variaron significativamente en cada test, el artículo muestra que menos de la cuarta parte de los jueces fueron capaces de determinar si quien produjo un conjunto de símbolos había sido una máquina o un ser humano, independientemente de los aciertos al azar. Es decir, los evaluadores tuvieron dificultades en general para distinguir el trabajo de los humanos y el del algoritmo.

"Por primera vez tenemos sistemas capaces de aprender una gran cantidad de conceptos visuales de una forma que resulta complicado distinguir del aprendizaje humano", comenta Josh Tenenbaum, profesor en el Departamento de Ciencias Cognitivas del MIT y coautor del estudio también junto a Ruslan Salakhutdinov, de la Universidad de Toronto.

Y aquí ya podemos hablar de auténtica inteligencia artificial (IA), o así lo piensa el profesor Fontenla Romero: "Si quien supervisa el resultado de un procedimiento no es capaz de distinguir entre hombre y máquina -a través de un test de Turing- entonces estamos dentro del campo de la IA, ya que estamos dotando a esas máquinas de la capacidad humana de razonar, aprender y generar nuevos conceptos". No obstante, reconoce que definir inteligencia artificial es algo "difuso".

Eso sí, queda mucho camino por recorrer para que los ordenadores "piensen" por sí mismos y que realmente aprendan como seres humanos, con toda la riqueza que implica esta experiencia, reconoce Lake. El investigador cree que se necesitará "algo más que grandes conjuntos de datos y ordenadores más rápidos". Pero también reivindica su trabajo como una muestra de las posibilidades de unir el estudio del aprendizaje humano y el poder de los programas probabilísticos para crear algoritmos más inteligentes y parecidos a los humanos.