modelizacion-universo-hacc

Las mejoras en los instrumentos para ver las estrellas y galaxias han permitido que podamos detectar objetos situados a millones de años luz, casi en los límites del universo observable. Imágenes de galaxias, quasars y otros objetos astronómicos que permiten a los científicos investigar acerca de la distribución de la masa a lo largo del espacio y de la influencia que tiene la energía oscura.

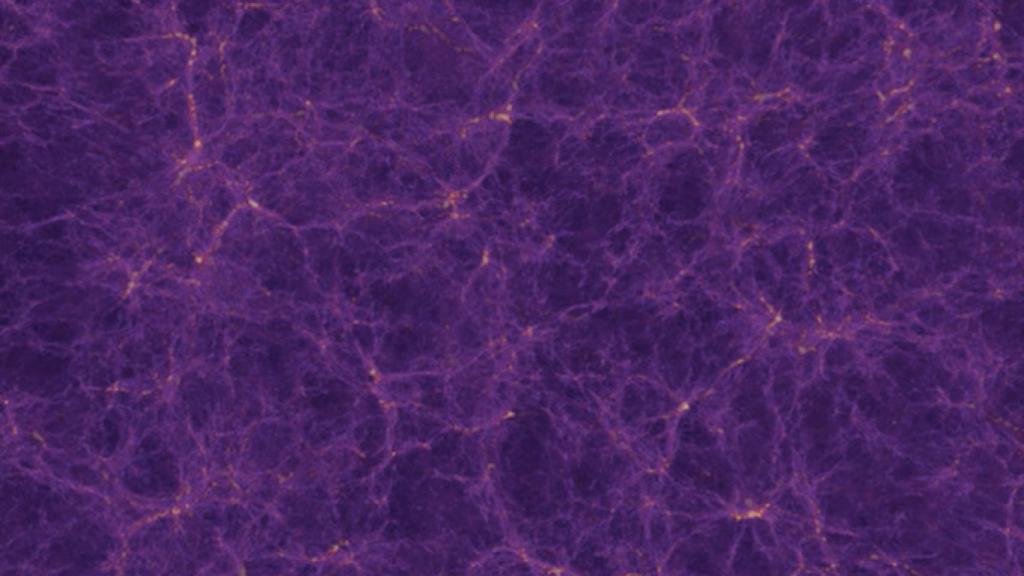

Para hacernos un modelo mental de un universo en expansión acelerada compuesto por billones de partículas necesitamos mapas o simulaciones que nos permitan conocer un poco más acerca del lugar donde vivimos, el laboratorio nacional de Argonne ha utilizado supercomputadores para realizar la más precisa simulación de la forma de nuestro universo y como se desarrolló. El proyecto se denomina Hybrid Accelerated Cosmology Code ( HACC ) y aproximadamente 1,1 billones de partículas se mueven, cohesionan e interactuan en los datos que utilizan. Una simulación de n-cuerpos cuatro veces más grande que la escala de las anteriores.

Para ello utilizaron tres de las supercomputadoras más poderosas del mundo: Titan en OCLF, Sequoia en el Lawrence Livermore Lab, y Mira en los Argonne Labs. Titan llegó a alcanzar una velocidad pico de 25 petaflops, números que casi ninguna otra supercomputadora puede manejar.

Katrin Heitmann, parte del equipo comentaba que el HACC es el mayor benchmark cosmológico jamas realizado.

El proyecto está separado en varios módulos que se pueden introducir en las distintas arquitecturas, pudiendo aprovechar los diferentes algoritmos siempre sabiendo que darán respuestas compatibles. Esto ofrece una versatilidad enorme. Ya que el número de supercomputadores accesibles es limitado el poder traspasar el trabajo realizado de uno a otro hace avanzar más rápido la investigación.

Se divide en dos niveles, por una parte tenemos el núcleo del framework, totalmente homogéneo. Y por otra tenemos la parte más computacional que trabaja partícula a partícula. Este método de trabajar al final no solo reporte versatilidad, sino una gran escalabilidad. HACC está preparado para saltar a la petaescala en un futuro próximo en el que los supercomputadores mejoren.

El objetivo de este proyecto es comprender mejor los patrones de la materia en el universo. La materia oscura representa un 25%, y con estos análisis los físicos podrán corroborar sus datos observacionales para poder seguir investigando sobre la estructura y los fenómenos que han ocurrido desde el Big Bang.

2MASS_LSS_chart-NEW_Nasa

Los investigadores siguen probando, poniendo a punto las capacidades de esta arquitectura. Y se espera que para enero puedan empezar a realizar simulaciones más grandes en el superordenador Titan.

Salman Habib, el líder del proyecto intenta explicar su trabajo. “La cosmología moderna no trata acerca de un único gran objeto. Es acerca de construir y trabajar con la estadística de billones de ellos.” Para ellos galaxias como la Via Láctea son los objetos más pequeños que introducen en sus simulaciones que llegan a distancias desde kiloparsecs hasta gigaparsecs (desde distancias entre galaxias hasta la distancia de todo el universo observable), ofreciendo resoluciones inabarcables.

La astrofísica y la computación van unidas de la mano desde hace mucho tiempo. En definitiva, es una buena noticia para los investigadores que trabajan resolviendo la historia del universo. La materia y energía oscura pueden complicar estas investigaciones, pero al final gracias a la tecnología conseguiremos un modelo bastante precisa del complejo universo en el que estamos.

Via OLCF