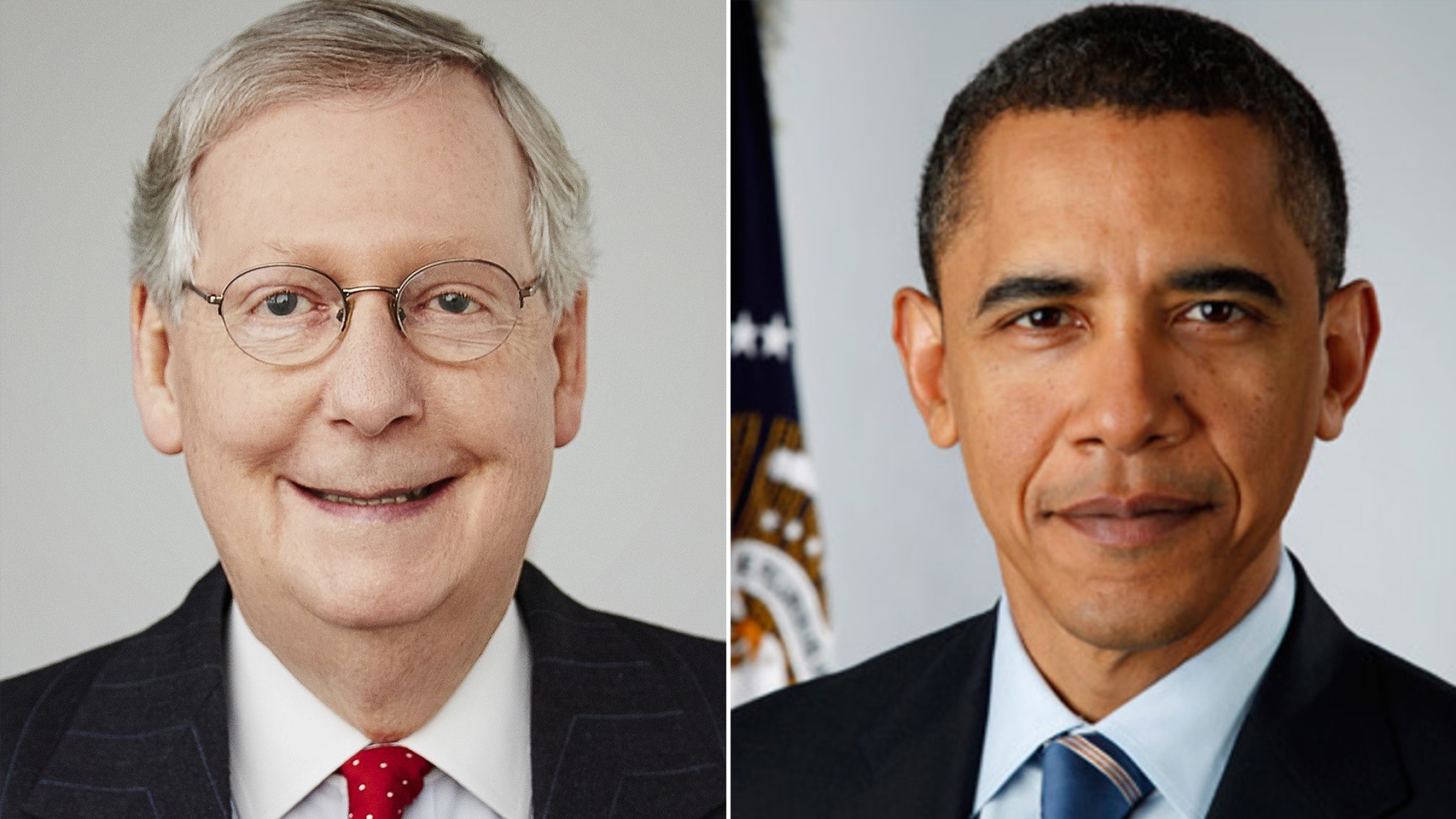

Si bien esta polémica se ha centrado en Estados Unidos, en España nos hemos hecho eco de ella. Puede que hayas visto un tuit bastante polémico en el que un usuario ponía a prueba los algoritmos de colocación de fotos en las vistas previas poniendo a Barack Obama y Mitch McConnell en la misma foto. El algoritmo, preferentemente, encajaba a la persona blanca.

Esto ha provocado la ira de los usuarios, calificando el algoritmo de Twitter de racista. Tal ha sido el revuelo que la red social de Jack Dorsey ha respondido y han asegurado que revisarán el recorte automático de imágenes y además de darnos más opciones para que los usuarios podamos recortarlas a placer, mejorará el algoritmo.

Eso no ha impedido que la red social se haya posicionado. Explican que tras sus análisis no han percibido "prejuicios raciales o de género", pero sí admiten que esto puede suponer un daño "potencial" para muchos usuarios.

Polémica en Twitter

El experimento lo llevó a cabo el usuario @bascule en Twitter. Tuiteó una imagen en la que salía Barack Obama, ex-presidente de los Estados Unidos y una persona blanca totalmente separados en los extremos por un espacio en blanco. Si Twitter detecta una imagen que no está bien encuadrada, la ajustará para que los usuarios puedan ver una vista previa de la imagen.

La idea de este tweet era ver por quién tenía preferencia el algoritmo. Los resultados fueron tristemente los esperados; en todas las ocasiones en las que el @bascule subía las imágenes, el algoritmo tenía preferencia por la persona blanca, Mitch McConnell, omitiendo por completo a Obama. El tuit en cuestión se ha hecho tremendamente viral.

No es ni mucho menos la primera vez que vemos sesgos raciales aplicados a Inteligencias Artificiales. Usualmente el problema reside en que se usan muchas menos fotografías de personas con piel negra para entrenar estos algoritmos que fotos de personas blancas, lo que provoca que estos tengan preferencias por dichas pieles.

Los modelos de IA funcionan partiendo de una base de datos que depende de una enorme cantidad de entradas de las cuale la IA tiene que 'aprender'. Por supuesto existen ejemplos como PULSE, un modelo que ha dado pie a acusaciones de racismo por sus incongruencias a la hora de reconocer personas no blancas.

Twitter actuará

En un comunicado Twitter ha asegurado que han realizado pruebas internas y que hasta la fecha "nuestros análisis no han mostrado prejuicios raciales o de género". Reconocemos que la forma en la que recortamos fotos automáticamente implica que existe un potencial de daño". La firma va a hacer pruebas adicionales y aseguran que se están explorando "formas de abrir nuestros análisis para que otros puedan ayudarnos a ser responsables".

Algo difícil de creer si tenemos en cuenta que otros usuarios tomaron el ejemplo del tweet viral e hicieron sus propios experimentos. Pasó exactamente lo mismo con imágenes de personajes de dibujos animados e incluso con fotos de perros de pelaje blanco y negro; la preferencia siempre era la misma.

Buscarán "disminuir nuestra dependencia" del recorte automático, introducido en 2018 y esperan dar "más opciones" a las personas para recortar imágenes y obtener una vista previa de cómo se verá la imagen una vez publicada.