La explosión organizada por AWS en Las Vegas para ilustrar el fin de la 'deuda tecnológica'.

Amazon Web Services abre paso al imperio absoluto de la IA con la ansiada demolición del legado tecnológico

AWS acelera en Las Vegas su ruptura con el legado tecnológico y despliega una estrategia integral que abarca silicio, modelos y agentes para reinventar la modernización a escala industrial.

Más información: Se viene récord de inversión en digitalización: seis billones de dólares en 2026 al calor de la inteligencia artificial

Es bien sabido que los estadounidenses gustan de golpes de efecto, de la sobreactuación. Tirar un servidor desde una grúa en pleno Strip de Las Vegas sobre varias cajas de explosivos bien puede encuadrarse dentro de esta afición por la pirotecnia y el márketing. Y eso precisamente es lo que a alguien de Amazon Web Services le pareció pertinente para dejar constancia del fin de la deuda técnica y el adiós a cualquier preocupación relacionada con el 'legacy' digital que arrastran muchas empresas de todo el mundo.

Anécdotas aparte, lo que AWS está denotando en el ReInvent 2025 (su principal evento global, con más de 60.000 personas acreditadas), es un cambio de tercio en la industria digital: del mantra de 'cloud-first' hemos pasado al de 'AI-first' y ahora al de 'agent-first'. Pero antes de construir cualquier menester ligado a estos conceptos de moda, es necesario resolver las ineficiencias y complejidades heredadas durante décadas.

Para muchos puede ser una revisión técnica sin demasiado lustre, pero quizás en ella se encuentre la respuesta a los problemas de implantación y escalado de muchos proyectos de inteligencia artificial en nuestros días. Puede que sea necesario prender fuego al legado tecnológico (mainframes, VMware, SQL Server, frameworks de otra era) y sustituirlos por fábricas de IA, chips de nuevo cuño y una capa de agentes capaces de reescribir código, gobernar datos y automatizar procesos críticos.

Matt Garman, CEO de AWS, lo dijo abiertamente durante su intervención en el congreso: "Vemos un futuro de billones de agentes, que ofrezcan valor, real, pero requiere reinventar toda la infraestructura, en todas sus capas, para poder hacer que funcionen".

Hay algunos motivos de peso para detenernos en esta cuestión. Según datos de la propia AWS, una organización tipo dedica en torno al 30% del tiempo de sus equipos a trabajo manual de modernización de sus sistemas antiguos. Una labor asociada a la deuda técnica necesaria, pero estéril y que drena recursos a la innovación.

Sobre esa cifra se construye el protagonismo de AWS Transform, presentado el pasado curso pero vitaminado ahora como el primer servicio de IA agéntica capaz de modernizar cualquier código y aplicación, incluyendo lenguajes y frameworks internos que solo existen dentro de una empresa. Un ariete contra el 'legacy' que, no obstante, está enfocado principalmente en aplicaciones .NET, mainframe y VMware.

En números: Transform ya ha analizado del orden de 1.100 millones de líneas de código y ha ahorrado más de 810.000 horas de esfuerzo manual. De acuerdo a la compañía, se podría llegar a acelerar la modernización hasta 5 veces y recortar hasta un 70% de costes de mantenimiento y licencias en entornos como Windows y SQL Server.

Matt Garman, CEO de Amazon Web Services, en ReInvent 2025.

En paralelo, el servicio incorpora un enfoque más agresivo para VMware, que continúa siendo la herramienta más denostada por los CIO tras el aumento de los precios de licencia, con herramientas de descubrimiento on-premise, planificación de migraciones basadas en contexto de negocio –incluyendo documentos, chats y reglas– y agentes de red que entienden configuraciones avanzadas con tecnologías como Cisco ACI, Fortigate o Palo Alto Networks.

Los casos de uso que exhibe AWS son deliberadamente masivos: Air Canada coordina con Transform la modernización de miles de funciones Lambda y logra una reducción cercana al 80% en tiempo y costes frente a un proyecto manual; mientras que Thomson Reuters ha anunciado en ReInvent que está migrando alrededor de 1,5 millones de líneas de código al mes, reduciendo su deuda técnica a la mitad.

Del 'legacy' al silicio de la IA

Una vez liberados de la pesada carga del legado tecnológico, AWS abre la puerta a la llegada industrializada y a escala de la inteligencia artificial, tanto generativa como en su vertiente agéntica.

Empezando, como no podía ser de otro modo, por la infraestructura que subyace a cualquier despliegue de esta índole. Además de presumir de acuerdos estratégicos con Nvidia (¿habrá alguna enseña que no haya sellado su rúbrica junto al proveedor de moda?), lo interesante del enfoque de AWS es la coexistencia de las GPU de la firma verde junto a sus propios desarrollos de chips.

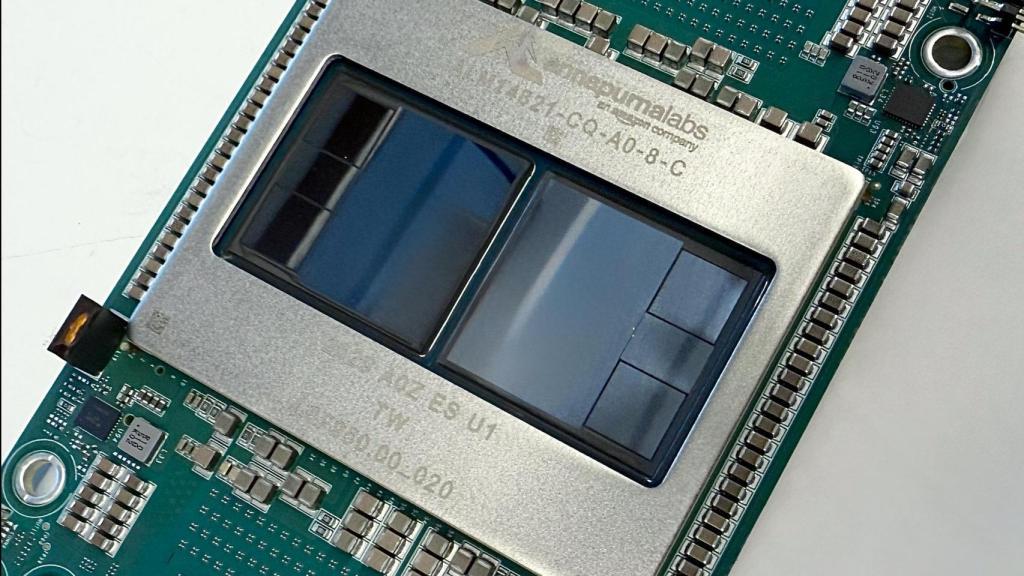

Imagen del nuevo chip Trainium 3 de AWS.

No en vano, y frente a la escasez y el coste de los H100 y sucesores, AWS lleva meses cortejando agresivamente a sus propios clientes para que prueben su silicio Trainium como alternativa más barata, llegando a situar su propuesta en torno al 25% del coste de algunos despliegues de entrenamiento e inferencia de IA equivalentes sobre Nvidia. Un millón de estos chips de marca propia ya se han desplegado hasta el momento, según desveló Garman en su intervención.

Hasta ahora la conversación la protagonizaba Trainium2, desplegado en las instancias Trn2, pero en Las Vegas el foco se desplaza claramente a la nueva generación, Trainium 3. Estos chips prometen hasta cuatro veces más capacidad de cómputo que la generación anterior, 3,9 veces más ancho de banda de memoria y cinco veces más tokens procesados por megavatio. Es decir, no sólo más potencia bruta, sino mejor aprovechamiento energético en un momento en el que el consumo eléctrico de los modelos fundacionales empieza a ser un problema técnico, político y social.

Recordemos que la generación anterior, Trainium2, ofrecía hasta 20,8 petaflops en precisión FP8 por instancia y escala hasta 83,2 petaflops en los UltraServers, donde 64 chips están interconectados mediante NeuronLink, con 6 TB de memoria HBM3 y 185 TB/s de ancho de banda, diseñados explícitamente para entrenar y servir modelos fundacionales de gran tamaño.

Pero AWS ni siquiera se queda ahí: en el escenario Matt Garman, CEO de la multinacional, ya marca el camino hacia Trainium 4, con el que la compañía apunta a un multiplicador de 6x en rendimiento, 4x en ancho de banda y 2x en capacidad frente a la generación que justo se acaba de presentar.

Los pasillos del AWS ReInvent 2025, en el hotel The Venetian (Las Vegas, EEUU).

No hay todavía ficha técnica pública, pero el mensaje debe entenderse en clave estratégica: estando como estamos en plena guerra sobre el cómputo de IA, AWS quiere dejar de ser uno de los grandes compradores de GPU de Nvidia para convertirse en un proveedor de silicio con hoja de ruta propia, empujando a clientes y socios a subirse a sus chips como vía para abaratar costes y contener la factura energética.

Los grandes (y pequeños) despliegues de IA

El chip es el componente más pequeño de una ingente cadena de valor que involucra la propia actividad de AWS como hiperescalar pero, también, de aproximaciones a pequeña escala, más personalizadas y que se atienen a los compromisos regulatorios de clientes diversos. En lo primero, Amazon Web Services ya ha comprometido inversiones que rozan los 50.000 millones de dólares para ampliar su infraestructura de IA y supercomputación para clientes del Gobierno de Estados Unidos, donde Trainium convive con hardware de Nvidia para dar soporte a cargas clasificadas.

Empero, en paralelo AWS está empezando a hablar de AI Factories casi con la misma naturalidad con la que antes hablaba de regiones.

Siguiendo el paso de rivales como Oracle o Microsoft, la compañía ofrece ahora infraestructuras dedicadas para clientes específicos, diseñadas, dentro de los centros de datos de los clientes pero operadas por AWS, integradas de forma transparente con otras infraestructuras y redes que ya tenga cada cliente. Una forma, en definitiva, de llevar los modelos de IA al perímetro de control de cada empresa, con sus reglas de soberanía y residencia de datos.

De los LLM de mercado a Nova

Una vez asentada la infraestructura, lo siguiente es detener nuestra mirada en los modelos de inteligencia artificial que se pueden desplegar en ella. AWS incluye en su vasto catálogo los principales LLM del mercado, 18 nuevos modelos de distintos proveedores, incluidos los últimos de Mistral AI: Mistral Large 3 y la familia Ministral 3 en tamaños de 3.000, 8.000 y 14.000 millones de parámetros, con disponibilidad prioritaria en AWS Bedrock según lo que se ha anunciado en Las Vegas.

Pero, más allá de sus integraciones con esos grandes nombres, el coloso de la nube cuenta con su propia familia de modelos fundacionales, Amazon Nova, presentada en 2024 con una primera hornada de sistemas multimodales: Micro, Lite y Pro, pensados respectivamente para latencia mínima y coste bajo, procesado multimodal rápido y tareas complejas que requieren mejor equilibrio entre precisión, velocidad y coste.

A ellos se suman modelos especializados como Nova Canvas para generación de imágenes y Nova Reel para vídeo.

Tal y como ha anunciado Garman, en 2025 la familia crece, se actualiza a su segunda generación y se densifica. Una de las piezas más relevantes es Nova Sonic, un modelo de voz a voz que permite mantener conversaciones naturales, en tiempo casi real, con voces expresivas en varios idiomas (incluido el español, con voces masculinas y femeninas añadidas este año), y que incorpora capacidades de moderación de contenidos, grounding con RAG y ejecución de acciones vía API. Sin olvidar a la joya de la corona, Amazon Omni, en particular, concentra muchas miradas: admite voz, audio, imagen, vídeo o texto como entrada y devuelve texto o imágenes, articulando un tipo de interacción que ya no está limitada al chat convencional.

En paralelo, Amazon ha lanzado Nova Multimodal Embeddings, un modelo de integraciones capaz de indexar y relacionar texto, documentos, imágenes, audio y vídeo en un mismo espacio vectorial, precisamente el tipo de ladrillo que necesitan los agentes de nueva generación para recorrer silos de información corporativa sin perder el contexto.

Industrializar los agentes

Todo este despliegue de chips y modelos sería tan anecdótico como la explosión cinematográfica con que abríamos esta crónica si no se tradujera en algo que funcione solo. Ahí entra en juego la palabra fetiche de esta re:Invent: IA agéntica. AWS no quiere que el cliente piense en prompts, sino en agentes que observan, razonan y actúan dentro de sus sistemas. Para eso la enseña atesora su herramienta AgentCore, la nueva capa dentro de Bedrock de ejecución y gobierno de estos agentes.

AgentCore agrupa en un mismo entorno las piezas que hasta ahora muchos clientes pegaban con cinta aislante: un modelo de base, un intérprete de código, un gateway para herramientas y APIs, observabilidad, memoria de largo plazo, gestión de identidad, capacidad de navegar por la web o por sistemas internos, y compatibilidad con estándares como MCP y patrones de agente-a-agente.

Matt Garman, CEO de AWS, durante su intervención en Las Vegas.

Sobre esa base se superpone una capa de gobierno, recién anunciada en ReInvent 2025: Policy in AgentCore, que define “barreras claras” para las acciones de los agentes (qué pueden hacer, dónde y en qué condiciones) y AgentCore Evaluations, con 13 evaluadores preconfigurados para inspeccionar continuamente la calidad, seguridad y comportamiento de los agentes en escenarios reales.

"Desplegar agentes autónomos es como gestionar la adultez de los adolescentes: debemos darles libertad para experimentar, pero al mismo tiempo controlar y establecer vías para evitar los escenarios más indeseables", remarcaba Matt Garman, padre precisamente de dos adolescentes.

Para culminar con la nueva frontera en estas lides: "Necesitamos políticas claras y que actúen antes de que los agentes accedan a los datos o las herramientas de las empresas. Sólo así es cómo las organizaciones podrán confiar en los agentes, porque sabrán que van a estar siempre dentro de las fronteras que establezcan".