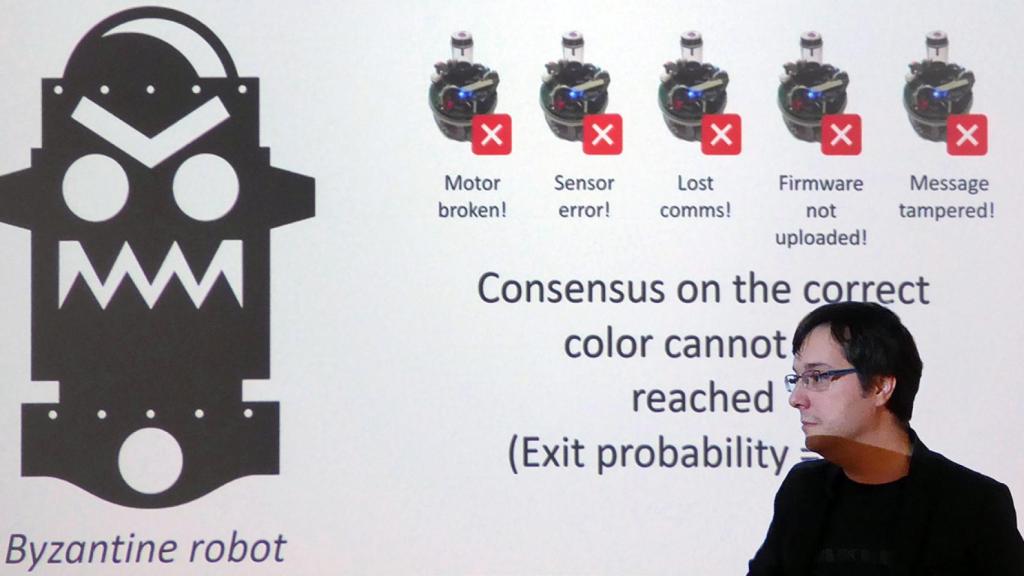

Un momento de la charla de Eduardo Castelló en su última visita a la UPV.

Robots que mienten, una amenaza no prevista que ya es real

Hiperconectividad y datos digitales permiten nuevas interacciones en una creciente complejidad global, pero surgen problemas como los robots ‘bizantinos’. Hablamos con jóvenes investigadores del grupo Human Dynamics del MIT Media Lab Labdel rn

La ciencia de datos, además de ser la profesión mejor pagada el año pasado, se ha convertido en una herramienta fundamental. En los últimos años, el volumen de datos digitales se ha incrementado exponencialmente, debido a la aparición de tecnologías disruptivas como smartphones, redes sociales o el IoT (internet de las cosas). Conceptos como el big data y sus tecnologías asociadas ya se aplican a la mayor parte de disciplinas científicas y campos de investigación, lo que unido al aumento de la capacidad computacional de la nueva informática dispara la capacidad de procesamiento, almacenamiento y análisis.

Con motivo de una jornada en la Universidad Politécnica de Valencia, relacionada con su nuevo grado de Ciencia de Datos, INNOVADORES dialoga con Eduardo Castelló, José Balsa Barreiro y Alfredo Morales Guzmán, tres investigadores del grupo Human Dynamics, que lidera en el MIT Media Lab el prestigioso Alex Sandy Pentland, pionero y referente mundial en la investigación del comportamiento social colectivo, a partir de datos agregados procedentes de información personal.

Eduardo Castelló investiga la inteligencia artificial (IA) que gestiona grupos numerosos de robots que interactúan entre sí, y ha descubierto que, en su seno, surgen ‘robots bizantinos’. Siempre hemos creído que los robots harán aquello para lo que están programados, serán ‘obedientes’ y se comportarán según su código de programación.

Pero resulta que ya hay robots capaces de mentir. "Se llama genéricamente robots bizantinos (byzantine robots) a los que son capaces de mentir, y muestran un comportamiento arbitrariamente defectuoso o malicioso".

Pero ¿son sus mentiras como las humanas? "Deberíamos crear un detector de mentiras para el mundo de los robots. En el fondo, un robot no es más que un ordenador con la capacidad de actuar con el mundo físico. Pero cuando tengamos robots en nuestras calles y casas, y empiecen a hacer lo que no deberían hacer, o lo contrario de lo que está previsto que hagan, el impacto sobre nuestra vida cotidiana será muy grande".

Estamos modelado una ‘sociedad’ de robots que hablan entre sí, el coche hablando con la casa, la casa con la agenda, la agenda con Alexa, ‘la’ asistente por voz de Amazon... no imaginábamos al robot mintiéndole al teléfono, éste a la casa y ésta a la nevera. ¿Las máquinas que mienten estaban previstas, o han surgido esta sorpresa al interactuar entre sí a gran escala? "Ya ha habido casos en los que infraestructuras robóticas clave han sido comprometidas, hackeadas, con muchas repercusiones. Y aún no hemos analizado lo suficiente el impacto que puede tener automatizar a gran escala muchas de nuestras infraestructuras clave. Me pregunto qué es lo que va a pasar cuando el próximo Fukushima lo cause un robot", dice Castelló.

'Bizantinos' en la Bolsa

Para evitar eso, insta a "poner en marcha tecnologías capaces de auditar, no solo un robot simple, sino una multitud de ellos que generan una ‘complejidad robotizada’, que va a convivir con nosotros". Hay aplicaciones informáticas en Bolsa capaces de realizar 2.000 operaciones por segundo. En el mercado bursátil si alguien miente con la información, lo meten en la cárcel. Pero imaginemos que algunos ‘robots de software’ -que funcionan a gran escala y cuya actividad hace subir y bajar las acciones y los valores en Bolsa-, se vuelvan ‘bizantinos’, y comenzaran a mentirse entre sí, y a los humanos.

La solución para evitarlo podría ser un sistema auditor tipo cadena de bloques. "Blockchain es una tecnología con muchísimo potencial", afirma el investigador del MIT. "Si un ‘robot de software’ actuara como los de la Bolsa, lo ideal sería que pudiera ser auditado a esa velocidad. El que esos robots pudieran verse a sí mismos y auditarse entre sí, quizá podría evitar los black swan [‘cisne negro’ o acontecimiento imprevisto con consecuencias económicas catastróficas] y parar la escalada de pánico que suelen provocar en la Bolsa y el mundo económico".

Según Castelló, si en un sistema que integra una multitud de robots emergen ‘robot bizantinos’, mentirosos, colapsa. "Hemos probado que si tienes un sistema distribuido de robots autónomos, o de software de IA, en el fondo, al tener redundancia, dispones de tolerancia a fallos. Es decir, si uno o dos, o más, fallan o se ‘caen’, el resto puede hacer su trabajo. Pero eso solamente es válido mientras los robots sean ‘no-bizantinos’, porque en el momento que tengas robots que se dediquen a envenenar las comunicaciones, o que estén influenciados negativamente por un ‘juego’ externo al conjunto, eventualmente, el sistema colapsa. Este es un tema aún no muy estudiado, muy preocupante, porque significa que, si tienes un grupo distribuido de robots y solamente hackeas uno y ése envenena las comunicaciones, esto se expande por la red por la que se comunican entre sí, se convierte en algo viral, y echa abajo el sistema".

Dice el investigador que "eso puede ocurrir por el propio diseño del sistema, cosa que en principio no podemos predecir totalmente, o porque alguien externo intente hackear o comprometer esas infraestructuras. La única diferencia es que, a día de hoy, hackear un ordenador implica perder datos o emails, y hackear un sistema, por ejemplo, el de los trenes automáticos que llevan pasajeros en los aeropuertos, o el que ya funciona en la ciudad de Tokio, significará que el tráfico se colapse o que suceda un problema peor".

'Confianza’ robótica

Sin duda, si un robot funciona con una programación, el que mienta también lo hará inducido por una ‘introducción externa’ fabricada desde lo humano. "La inteligencia artificial, hoy por hoy, está en disposición de ser lanzada al mundo y empezar a mentir", sentencia. Como Hal 9000, en la película 2001.

Una posible solución para estos casos en donde pueden surgir ‘robots bizantinos’ sería un ‘fabricador de confianza’. "En el mundo analógico, la confianza es bastante sencilla de entender. Pero en el digital, es un tema complicado. La tecnología e Internet no fue diseñada para transmitir confianza, sino para enviar información de un punto A, hasta un punto B, de manera eficiente, sin que tenga por ello que ser verdadera", dice el investigador español.

"Lo que el blockchain resuelve es que facilita el poder llegar a consensos, acuerdos, de manera descentralizada, sin ningún intermediario, y que nadie puede cambiar. Proporciona una transparencia [acountability] en las transacciones de mensajes que intercomunican a un grupo de ‘agentes’ de IA".

El resto los detecta

En su investigación con grupos numerosos de robots usa esta tecnología. "Hago que diversos robots hagan cosas complejas a través del proceso de cooperar y colaborar entre ellos, y que ‘encapsulen’ sus transacciones y sus mensajes a través de blockchain. Y consigo que ciertos ‘agentes’, cuando empiezan a mostrar ese comportamiento ‘bizantino’ o raro, empiecen a crear inconsistencias en el ‘libro’ o excel de cuentas de sus transacciones; y, por lo tanto, los demás robots, sin intervención de ningún de jefe o autoridad, lo detecten como un ‘agente’ que no es confiable y tiene un problema de software o de otro tipo, y decidan dejarlo apartado, fuera del grupo, al no confiar en lo que dice y hace".

La investigación de Balsa Barreiro, por otra parte, aborda la segregación y polarización socioeconómica. El big data se ha vuelto un término omnipresente. "Nuestras investigaciones para predecir el comportamiento social, están centradas en monitorizar y extraer datos digitales de comportamientos de los que antes no sabíamos nada. Tradicionalmente, todos los datos eran tomados en entrevistas o encuestas, e iban condicionados, sesgados; tenían una parte de ‘engaño’, o de opiniones y comportamientos subjetivos por parte de la gente. En cambio, los datos del big data fluyen de forma no obstrusiva [comportamiento y contenido separados], no están condicionados ya que los proporcionan directamente los propios dispositivos que usamos. Y son producidos por el comportamiento natural y real de las personas", explica.

"Hasta no hace mucho se parametrizaban cosas muy concretas, solo algunas variables, pero ahora estamos entrando en una fase mayor complejidad. No es la realidad total, que tiene muchas facetas. Pero ahora se monitorizan datos de comportamientos de forma casi continuada en el tiempo", añade Balsa.

Alfredo Morales Guzmán, por último se ha especializado en Ciencia de Datos y de la Complejidad. "Cuando hablamos de ‘complejidad’, no nos referimos a cosas complicadas, sino a diversidad o riqueza de comportamientos. Es decir, a diferentes tipos de conducta que podemos esperar de un individuo o un sistema de ellos. Para que un sistema pueda tener diferentes tipos de comportamiento, los individuos deben establecer relaciones entre ellos".

Nuevas interacciones

La clave es que en el mundo actual la información fluye en internet y también físicamente. "La hiperconectividad abre las puertas a nuevos comportamientos emergentes que antes eran prácticamente imposibles. Una protesta en China dispara otra que surge en México y Haití, y tumba a un presidente. Hoy suceden propagaciones ‘virales’ de cosas en el ámbito global. Eso ha creado también nuevos modelos de negocio, como Uber o Airbnb, que conectan a gente y generan nuevas interacciones que antes dependían de una entidad centralizada. Una persona tiene capacidad de explotar este tipo de facilidad y crear interdependencias para hacer negocio y aprender, entendiendo los comportamientos también como información", afirma Morales.

La creación de nuevas interdependencias genera oportunidades. "En el caso de Uber, usan recursos de información que podrían utilizar también los servicios de taxi para mejorar los servicios a su favor. Estas aplicaciones de Airbnb y Uber son la primera generación de una nueva economía en la cual ya no son necesarios los entes centralizados. Pero pronto podrás tener Uber sin Uber, y crear relaciones directas horizontales, peer to peer, entre conductor y pasajero, sin necesidad de pasar por ningún intermediario", afirma.

Estos cambios pueden eliminar viejos monopolios, o sustituir los viejos por otros de nuevo cuño. "Puede pasar de todo", señala, "pero llegan señales de que se va a ir eliminando viejos monopolios porque tenemos más capacidades. También se generan nuevas dinámicas sociales que tienden hacia la monopolización. El rico se hace más rico con ellas. Si no se anticipa la regulación, la nueva centralización puede llegar sola. Es necesario comprender estos cambios y nuevos principios, para diseñar un marco regulador, que pare la emergencia de estructuras abusivas".

Colonias de robots en minas o el mar

Hay un ejemplo que suele mostrar Castelló en el que un grupo de robots realiza funciones y coopera entre sí sin intervención humana y formando un sistema sostenible, que podría funcionar semanas, meses o años. «Debemos hacer un mundo en el que las máquinas no nos ‘consuman’, sino que nos ‘extiendan’. Deben hacer las cosas a las que ya no encontramos sentido. No creo que la minería del carbón dé sentido a la vida de un humano en el siglo XXII, o vivir en el fondo del mar».