Las claves

nuevo

Generado con IA

Distante ya de los años en que todo giraba en torno a los dispositivos personales o el entretenimiento, el CES 2026 de Las Vegas tiene este año apellido por derecho propio: inteligencia artificial. Por supuesto, dista de ser una sorpresa en estos tiempos en que todas las conversaciones giran sobre el mismo tema. Pero es relevante constatar la atención presente -y, especialmente, a futuro- que las enseñas tecnológicas prestan a este menester.

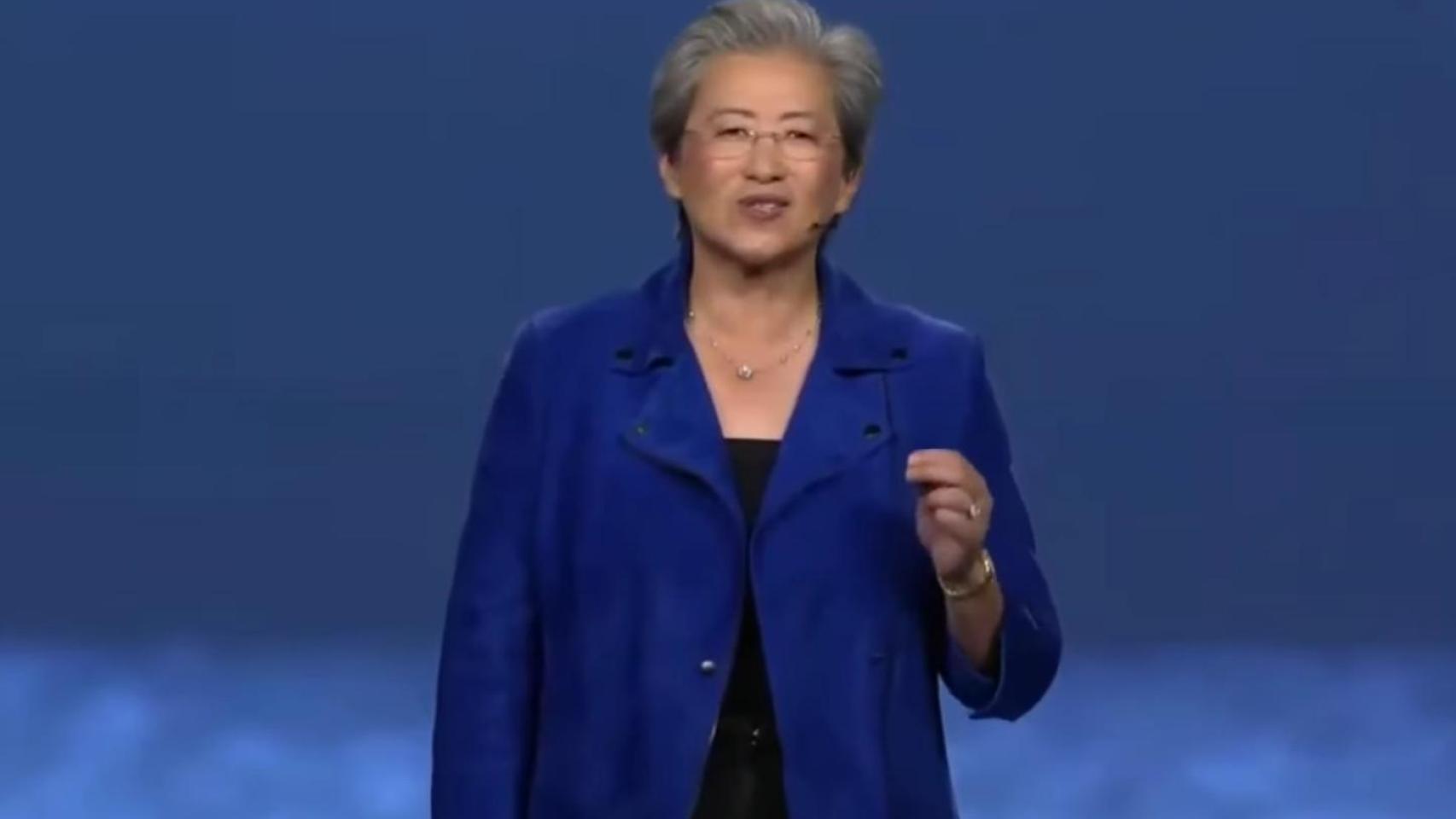

Es el caso de Lisa Su, consejera delegada de AMD, encargada de abrir las sesiones plenarias del mayor evento tecnológico del mundo. ¿Su mensaje básico? Que frente a los temores sobre una posible burbuja de la IA, apenas estamos rozando la superficie: “Aunque el ritmo y la velocidad de la innovación en IA han sido increíbles en los últimos años, el tema es que aún no habéis visto nada”.

“Sólo estamos empezando a darnos cuenta del poder de la IA. La inteligencia artificial es la tecnología más importante de los últimos 50 años, y puedo decir que es, sin ninguna duda, la prioridad número uno para AMD”, añadía a renglón seguido.

Una premisa que le sirvió para proyectar un escenario de adopción masiva. Según explicó la máxima ejecutiva de este fabricante de chips, la inteligencia artificial camina hacia un punto en el que superará los 5.000 millones de usuarios activos y se convertirá en algo verdaderamente indispensable en todas las facetas de la vida, del mismo modo que hoy lo son el teléfono móvil o internet. Un futuro que, en su opinión, tensiona como nunca la infraestructura tecnológica global.

Y es que nunca podrán cumplirse esas ni cualesquiera otras previsiones si no resolvemos el gran cuello de botella de la falta de cómputo, lo que a su vez provoca inversiones milmillonarias de difícil retorno y deudas financieras nunca antes vistas, como ya hemos denunciado en este medio.

“Lo que vais a escuchar esta noche de todo el mundo es que no tenemos ni de lejos suficiente capacidad de cálculo para todo lo que podríamos hacer”, advirtió Lisa Su. Para habilitar la IA en todas partes, sostuvo, será necesario multiplicar por 100 la capacidad de cómputo mundial en los próximos años, hasta superar los diez yottaflops en un horizonte de cinco años.

Un yottaflop, recordemos, es un uno seguido de 24 ceros y diez yottaflops equivalen a disponer de 10.000 veces más capacidad de cálculo que en 2022.

“Nunca, jamás ha habido nada parecido en la historia de la computación, y eso es porque nunca ha habido una tecnología como la inteligencia artificial”, reconocía Su.

Más allá de los obvios intereses de AMD en alimentar la industria que le da de comer, en ese contexto de escasez estructural la visión de Su aporta algo novedoso respecto a los discursos de la todopoderosa Nvidia e incluso de colosos como Google. Y es que, para ella, a cada carga de trabajo le vendrá mejor un tipo de computación u otro: GPUs, CPUs, NPUs o aceleradores personalizados. En otras palabras: no todo debe pasar por la omnipresencia y el monopolio de las tarjetas gráficas y sus disparatados precios.

Desplegar tecnología a escala 'yotta'

Empero, la presión sobre las capacidades de infraestructura es indiscutible. Su recordó que, durante la última década, el cómputo necesario para entrenar los modelos de IA líderes ha crecido más de cuatro veces cada año y que esa tendencia continúa. Pero subrayó que el verdadero punto de inflexión reciente está en la inferencia.

A medida que más personas utilizan sistemas de IA, el número de tokens procesados se ha multiplicado por 100 en apenas dos años, alcanzando lo que definió como un punto de inflexión claro.

"El verdadero desafío es cómo desplegamos infraestructura de IA a escala yotta”, planteó la ejecutiva, insistiendo en que no basta con ofrecer rendimiento bruto. Esa es, según explicó, la razón de ser de Helios, la nueva plataforma de racks de AMD pensada para la era yottascale. “Por eso construimos Helios, nuestra plataforma de racks de nueva generación para la era de la IA a escala yotta”.

Su se detuvo en describir una arquitectura pensada para funcionar como una única unidad de cómputo. Cada bandeja se conecta mediante enlaces de ultra alta velocidad que permiten que las 72 GPUs de un rack operen como un solo sistema, y a partir de ahí escalar conectando miles de racks Helios para construir grandes clústeres de IA.

En ese punto entran en escena los detalles técnicos de sus chips, el corazón mismo de esta revolución. “MI455 es el chip más avanzado que hemos construido nunca”, afirmó. Un procesador con 320.000 millones de transistores, un 70% más que su predecesor, que combina chiplets de computación en procesos de dos y tres nanómetros y 432 gigabytes de memoria HBM4 de alta velocidad. A su lado, Venice, el nuevo procesador basado en Zen 6, fabricado en dos nanómetros y con hasta 256 núcleos de alto rendimiento. “Duplicamos la memoria y el ancho de banda de GPU respecto a la generación anterior, de modo que Venice puede alimentar a MI455 con datos a plena velocidad, incluso a escala de rack”, explicó.

El resultado, según detalló Lisa Su, es que cada rack Helios integra más de 18.000 unidades de cómputo GPU CDNA5 y más de 4.600 núcleos CPU Zen 6, entregando hasta 2,9 exaflops de rendimiento.

Más allá del hardware, Lisa Su insistió en otro de los pilares históricos del discurso de AMD: la apertura. “Creemos que un ecosistema abierto es esencial para el futuro de la IA”, afirmó. A su juicio, la innovación avanza más rápido cuando la industria se alinea en torno a infraestructuras abiertas y estándares compartidos. “AMD es la única compañía que ofrece apertura en toda la pila: hardware, software y el ecosistema de soluciones”, defendió, citando ROCm como la pila de software abierta de mayor rendimiento para IA y su compatibilidad nativa con los principales frameworks y proyectos open source.