Las claves

nuevo

Generado con IA

La particular simbiosis entre la inteligencia artificial y el auge de su capa generativa con la termodinámica y la ingeniería civil era algo que pocos pudieran anticipar. Durante años, el debate se centró en los algoritmos y el cómputo; hoy, la contienda es otra: la infraestructura física y energética que los sostiene.

Los centros de datos han dejado de ser simples almacenes de información para convertirse en fábricas de generación de conocimiento, con un consumo intensivo de energía. Su voracidad ha roto las previsiones de consumo eléctrico mundial. Esto ha empujado a los gigantes tecnológicos a una conclusión inevitable: la red tradicional, dependiente de combustibles fósiles o de la intermitencia de las renovables, es incapaz de sostener la hiperescala -valga la paradoja- que exige el futuro digital.

El problema ya no es la capacidad de cálculo de las máquinas, sino la energía necesaria para mantenerlas operativas. Según las estimaciones de la Agencia Internacional de la Energía (AIE), el consumo eléctrico de los centros de datos podría superar este 2026 los 1.000 teravatios hora (TWh) frente a los 460 TWh estimados en 2022, una cifra comparable al consumo total de un país como Japón.

Con este cambio, compañías como Amazon, Google y Microsoft han asumido un rol inédito como promotores nucleares y han empezado a tomar decisiones que hasta ahora correspondían a los Estados. Sus planes abarcan desde la financiación de reactores modulares de fisión (SMR, por sus siglas en inglés) hasta el impulso de la promesa futurista de la fusión.

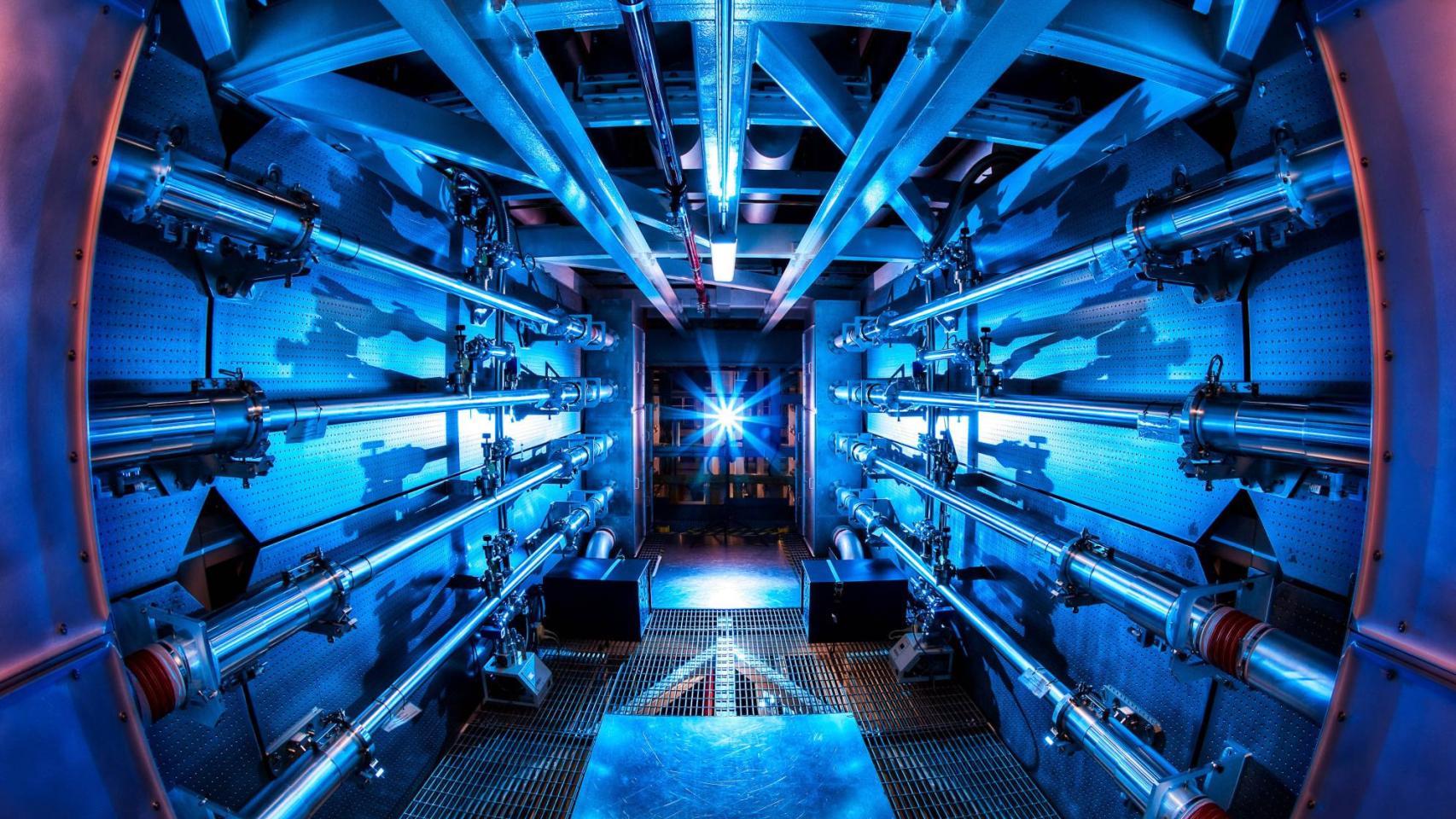

No son monedas lanzadas al aire. Su apuesta se apoya en el hito logrado en diciembre de 2022, cuando el Laboratorio Nacional Lawrence Livermore (EEUU) consiguió por primera vez una “ganancia neta” de energía en una reacción de fusión. Es decir, el experimento obtuvo más energía de la que se inyectó, un resultado que terminó de convencer a las Big Tech.

El consumo eléctrico de los centros de datos podría superar los 1.000 TWh en 2026

Sin embargo, tal y como advierten desde instituciones científicas, como el Laboratorio Nacional de Fusión, del Centro de Investigaciones Energéticas, Medioambientales y Tecnológicas (Ciemat), en Madrid, existe un abismo técnico entre las aspiraciones de la industria y las leyes de la física que rigen, nada menos, que el proceso de reproducir el encendido de una estrella en la Tierra.

A este análisis del nuevo tablero energético, en DISRUPTORES - EL ESPAÑOL hemos incorporado la voz científica del Ciemat, la perspectiva institucional de la Asociación Europea de Fusión y la visión empresarial de grandes tecnológicas como Microsoft.

El dilema energético

La magnitud de este movimiento tectónico solo se entiende observando el cambio de escala en la infraestructura. El responsable del proyecto de IA generativa en el Laboratorio Nacional de Fusión del CIEMAT, Augusto Pereira, lo ilustra para este medio con una sencilla comparación.

Mientras un centro de datos convencional opera con unas 500 CPU y consume 100 kilovatios (el equivalente al gasto de unas 40 viviendas), los nuevos centros hiperescalares integran más de 100.000 CPU y demandan entre 50 y 100 megavatios, equiparando su consumo al de una ciudad de 40.000 habitantes. Un salto cuantitativo que define los parámetros en los que operan estos sistemas.

Pero la proyección a corto plazo es aún más vertiginosa. OpenAI ya tiene previstas infraestructuras que alcanzarían los 1,4 gigavatios (GW) de potencia. Para entender la magnitud de estos movimientos, basta una nueva comparación: la central nuclear de Almaraz, en Cáceres, tiene una potencia total de 2 GW; es decir, uno de estos megacentros de IA requeriría prácticamente la producción exclusiva de una de estas plantas para operar sin interrupción.

Un despliegue de, por ejemplo, siete instalaciones de este tipo supondría una demanda energética equivalente a la producción de cinco centrales nucleares de gran tamaño funcionando a pleno rendimiento. Un escenario coherente con iniciativas como Stargate, el plan de infraestructura anunciado por OpenAI en Estados Unidos.

La fisión, solución inmediata

Ante la imposibilidad de construir centrales nucleares tradicionales en los plazos que marca la carrera de la inteligencia artificial, los hiperescalares han optado por la vía pragmática de la fisión avanzada. Todos los grandes actores tecnológicos han firmado acuerdos para nutrirse de este tipo de energía y plantean desplegar pequeños reactores modulares en sus nuevas instalaciones.

En este escenario, la presidenta de la Asociación Europea de Fusión y CEO de Gauss Fusion, Milena Roveda sitúa a los pequeños reactores modulares como un aliado para salvar el desajuste entre la demanda energética y la capacidad de generación disponible.

"La fisión es una tecnología puente que permite ganar tiempo mientras la fusión avanza hacia su madurez"

A preguntas de DISRUPTORES - EL ESPAÑOL, Roveda explica que los SMR pueden ofrecer una respuesta viable a corto y medio plazo para cubrir el crecimiento de la demanda eléctrica y “acercar la producción de energía a grandes polos industriales y urbanos”.

Desde Amazon Web Services confirman a este medio que ya están apostando por esta tecnología, por considerar que "ofrece energía libre de carbono, que es más rápida de crear, cuesta menos y genera beneficios económicos para las comunidades a través de empleos e ingresos fiscales". Al mismo tiempo, la compañía asegura que están avanzando en el desarrollo de "una tecnología segura y regulada que pueda ayudar a acelerar las soluciones de energía libre de carbono”.

En este momento de transición, la presidenta de la Asociación Europea de Fusión califica los SMR como una tecnología puente, que "permite ganar tiempo y estabilidad, mientras la fusión avanza hacia su madurez industrial", además de facilitar la futura integración de la fusión en la red eléctrica.

Los beneficios de los pequeños reactores nucleares son evidentes, principalmente ligados a su menor huella física, que permite instalarlos cerca de los centros de datos, evitando las pérdidas de transporte y los largos plazos de la obra civil nuclear clásica. Pero sigue siendo fisión nuclear, con los riesgos asociados a esta tecnología y los temores sociales ante posibles incidentes de seguridad.

La fusión nuclear, el Santo Grial

La industria digital ha puesto sus ojos en la fusión nuclear como si del Santo Grial se tratase. Google ha firmado el primer PPA (acuerdo de compra de energía) corporativo de fusión para adquirir 200 MW de la startup Commonwealth Fusion Systems (CFS) a principios de la década de 2030, mientras que Microsoft colabora con Helion Energy para obtener 50 MW a partir de 2028.

La finalidad de este tipo de acuerdos es asegurar la viabilidad financiera del proyecto, a cambio de un compromiso de compra por adelantado de la energía que producirán.

"La fusión tiene un potencial transformador, pero no está lista para alimentar de forma estable a la industria digital”

Desde el Ciemat, Pereira introduce una dosis de realismo. Califica estos acuerdos como “simbólicos”, pero nada más: “Respaldan financieramente a las startups de fusión y envían señales al mercado de que los grandes consumidores de energía por la IA quieren apostar por la inversión en tecnologías emergentes”.

Pero, puntualiza, "no se debe confundir hacer con lograr". “Hacer es un coste para la empresa inversora, mientras que lograr es un beneficio”. Así, aunque se integren en las carteras de renovables a largo plazo, Pereira insiste en que la tecnología de fusión nuclear sigue siendo “hoy por hoy, altamente experimental”.

Los tiempos de la ciencia

Un argumento que comparte la presidenta de la Asociación Europea de Fusión, quien considera que los plazos mencionados por las grandes tecnológicas son “extremadamente ambiciosos”. Y señala que “la viabilidad y velocidad en el desarrollo de la fusión como parte del mix de generación eléctrica dependerá de los recursos que se asignen a los proyectos”. Estima que “las primeras plantas requerirán entre 15.000 y 18.000 millones de euros para su construcción”.

Más allá de lo económico, Roveda también advierte sobre la brecha geopolítica: “Si Europa no quiere volver a quedarse atrás -como ya ha ocurrido en la carrera por la inteligencia artificial frente a EEUU o China-, tiene la obligación de liderar la industrialización de la energía de fusión”.

Asimismo, defiende que esta tecnología es clave para la “soberanía energética”, ya que “pocas infraestructuras son tan críticas como una red energética independiente y fiable”.

Esta premura contrasta con los tiempos que maneja la ciencia y la complejidad de los proyectos. La construcción de este tipo de reactores requiere que la física funcione, pero también integrar componentes, validar materiales o certificar los protocolos de seguridad.

Como ejemplo de este desajuste en los plazos, la directora de Centros de Datos de Microsoft España, Natalia Maeso, explica a este medio que el gran proyecto internacional ITER (International Thermonuclear Experimental Reactor), con el que colabora esta tecnológica y considerado el mayor experimento de fusión nuclear del mundo, prevé iniciar operaciones en 2033.

Mientras tanto, manifiesta Maeso, las compañías deben asumir un enfoque intermedio y multitecnológico, combinando renovables, almacenamiento y eficiencia. Admite que la fusión “tiene un potencial transformador, pero todavía no está lista para alimentar de forma estable a la industria digital”. Lo que, de momento, obliga a la convivencia de soluciones híbridas.

Las promesas frente a la realidad

Para que la fusión llegue a convertirse en una realidad comercial, capaz de alimentar tanto la nube como la IA, la ciencia debe resolver desafíos que Pereira cataloga como “supercríticos” y que van mucho más allá del capital riesgo necesario para su desarrollo. Es aquí donde se produce el choque entre las expectativas industriales y la complejidad del mundo físico.

El primero de ellos es el ciclo del combustible: el reactor debe ser autosuficiente, produciendo su propio tritio mediante un “manto” o blanket de litio líquido, un sistema complejo que aún no se ha demostrado a escala real y sin el cual no existe sostenibilidad posible. Sin este proceso, no sería viable un funcionamiento continuo.

"No es una tecnología ‘sin consumo’, desplaza la huella hacia refrigeración criogénica y energía eléctrica especializada”

A ello se suma la resistencia de los materiales, ya que los neutrones de 14 MeV generados en la fusión degradan las estructuras a una velocidad que exige nuevas aleaciones aún en desarrollo. En la práctica, los materiales disponibles hoy no están diseñados para soportar esta actividad a largo plazo.

Finalmente, está la barrera económica de los sistemas de confinamiento magnético, que requieren imanes superconductores. Cada uno de estos imanes es, por sí mismo, una pieza de alta ingeniería y exige inversiones de miles de millones de euros, aunque un aumento de la producción podría reducir estos costes en el futuro.

Maeso, por su parte, apunta que el reto crítico es “el ensamblaje del reactor, el control del plasma y la coordinación de miles de componentes”.

Paradójicamente, la inteligencia artificial no solo consume energía, también se está usando para mantener bajo control el plasma, el material extremadamente caliente donde ocurre la fusión, uno de los principales obstáculos históricos de esta tecnología.

El 'club' de la fusión

-

Microsoft y Helion Energy. Microsoft fue la primera tecnológica en firmar un PPA de fusión. Su socio, Helion, ha captado más de 1.000 millones de dólares para desarrollar sus primeros reactores comerciales

-

Google y Commonwealth Fusion Systems (CFS). Google ha comprometido la compra futura de 200 megavatios (MW) e inversión en CFS, spin-off del MIT, que ha levantado cerca de 900 millones de dólares para su reactor SPARC.

-

Amazon Web Services. AWS ha dado prioridad a la fisión avanzada y los SMR para cubrir su demanda actual, mientras evalúa la fusión a largo plazo.

-

China. Programas estatales y grandes tecnológicas como Huawei o Tencent impulsan la fusión como parte de su estrategia energética e industrial.

El portavoz de Microsoft confirma que ya están acelerando el desarrollo de la nuclear mediante el uso de IA, simulaciones avanzadas y tecnologías que "están ayudando a los científicos a analizar millones de documentos, modelar experimentos complejos y optimizar el diseño de los reactores"

Junto a los retos tecnológicos, Roveda subraya la necesidad de “organizar una cadena de suministro capaz de escalar componentes complejos” que deben operar en condiciones extremas. Históricamente, recuerda, la fusión ha sido experimental; ahora el objetivo es “producir electricidad con visión industrial”.

Entre lo nuclear y lo cuántico

A menudo también se cita a la computación cuántica como la salvadora de este dilema energético, como un posible entorno en el que explotar la IA de forma más eficiente. De nuevo, Pereira desmonta este mito: “No es una tecnología ‘sin consumo’, sino una que desplaza la huella hacia refrigeración criogénica y energía eléctrica especializada”.

No en vano, los ordenadores cuánticos actuales requieren sistemas de helio líquido o refrigeradores por dilución para operar cerca del cero absoluto, consumiendo entre 25 y 100 kW solo para mantener la estabilidad del sistema operativo, independientemente del cálculo.

Aquí surge un paralelismo técnico que conecta la IA del futuro con la energía del futuro. Tanto la computación cuántica como los reactores de fusión, como ITER, comparten un destino tecnológico común basado en la criogenia avanzada: ambos deben mantener condiciones de frío extremo para que sus componentes funcionen de forma estable y controlada.

ITER utilizará un sistema central basado en helio líquido en circuito cerrado para enfriar sus bobinas superconductoras, alejándose del modelo de consumo masivo de agua de las centrales térmicas. “Este helio circula por canales dentro de los conductores de los imanes, donde absorbe el calor residual. Por tanto, la mayor parte de la refrigeración de las bobinas de ITER será con helio líquido en circuito cerrado en vez de consumo de agua”, detalla el experto berciano del Ciemat.

De este modo, la eficiencia no vendrá de gastar menos energía física, sino de utilizar fluidos avanzados y soluciones algorítmicas que optimicen el cómputo.

Pero el dilema va más allá de la tecnología: ¿Hasta qué punto los recursos naturales disponibles podrán sostener el crecimiento de la inteligencia artificial? ¿Quién decidirá cómo dar prioridad de ese consumo: reguladores, Estado... o tecnológicas? Bajo esas reglas se escribirá el próximo capítulo de esta relación entre inteligencia artificial y energía.

El agua, nuevo cuello de botella

Mientras se espera esa era nuclear, la industria se enfrenta a tensiones crecientes por el uso de los recursos naturales. La eficiencia de los centros de datos ya no se mide solo por su potencia eléctrica: también entran en juego variables como el consumo de agua.

Casos como el proyecto de Meta en Talavera de la Reina (Toledo), para el que se estima un consumo de 600 millones de litros de agua potable al año, ilustran la tensión hídrica local que generan estas infraestructuras y la urgencia de buscar soluciones alternativas de refrigeración.

La directora de Centros de Datos de Microsoft España, Natalia Maeso, explica que ya están “liderando el rediseño de centros de datos con refrigeración directa al chip mediante placas frías y tecnologías de microfluidos, que disipan el calor con precisión y sin necesidad de evaporación”. El objetivo es extraer el calor exactamente donde se genera y evitar sistemas que dependan del agua como recurso.

Estas innovaciones, añade, permiten "aumentar la densidad de computación por rack” reduciendo drásticamente el impacto ambiental y el uso de agua, en línea con el compromiso de la compañía de ser water positive en 2030.