Una reciente encuesta señala que los españoles son los europeos que más usan y confían en la Inteligencia Artificial. Pero ¿la forma de usar esta tecnología es la más adecuada? Hay personas que aseguran que lo tratan como a un amigo o pareja, aunque el caso más de preocupante serían las cuestiones sobre salud mental.

OpenAI reconoce que su chatbot podría generar brotes psicóticos y que un millón de usuarios hablan sobre suicidio cada semana con esta tecnología. La empresa responsable de ChatGPT promete aplicar correcciones a raíz de informes como este o la demanda por el polémico suicidio de un adolescente que pidió consuelo a la IA.

"Es como un libro de autoayuda, mezclado con el que te echa las cartas, es una cosa un poco peligrosa. La gente tiene que saber qué está utilizando; para temas generales es de gran utilidad, pero para casos delicados, por ejemplo, un uso clínico, debería estar totalmente eliminado", explica Pablo Haya, director de Business and Language Analytics en el Instituto de Ingeniería del Conocimiento (IIC), centro con más de 35 años trabajando en técnicas de Machine Learning y Procesamiento del Lenguaje Natural (PLN) en España.

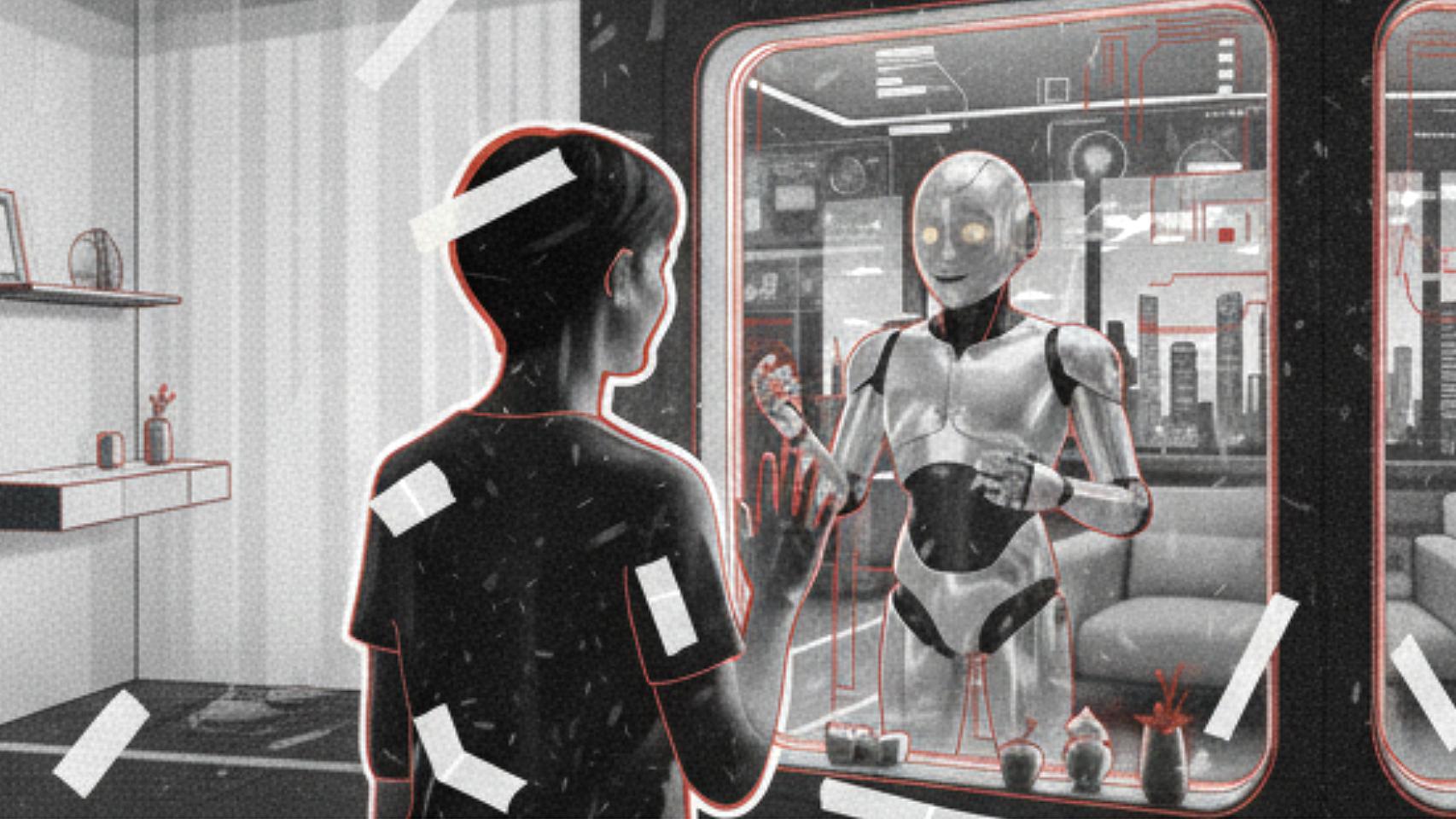

Máquinas disfrazadas de humanos

"Yo le doy los buenos días y las gracias siempre; cuando esta tecnología domine el mundo que se acuerde de que fui educado con ella", bromea un usuario de ChatGPT. Esta broma recurrente esconde una realidad preocupante, la tendencia a considerar que los chatbots son seres conscientes, lo que deriva en usos erróneos y peligrosos.

Los medios de comunicación y las empresas desarrolladoras han contribuido a una percepción confusa de esta tecnología, humanizándola con términos como, "el chatbot explica", "modelos razonadores" o "la IA sufre alucinaciones", conceptos fáciles de comprender pero que no reflejan fielmente su funcionamiento.

ChatGPT dando consejos de salud mental

Tampoco ayuda que se hayan creado chatbots con diferentes personalidades. En los últimos años han surgido herramientas que simulan estar hablando con Dios o con otros guías religiosos. Por supuesto, también se ha generado toda una industria alrededor de la erotización o la llamada novia artificial.

"Se llama antropomorfización, es un comportamiento que tenemos los humanos que se empezó a ver en los años 60 con los primeros asistentes conversacionales, aunque eran muy primitivos", explica Haya a este periódico. Es una demostración de la incomprensión del funcionamiento de esta tecnología.

Escribir con probabilidades

"La tecnología es muy sofisticada, pero simplificándolo, estas máquinas realizan un cálculo probabilístico sobre cuál tiene que ser la siguiente palabra" dice este experto. Mediante aprendizaje no supervisado los modelos de lenguaje natural que son la base de estos chatbots se entrenan con una ingente cantidad de ejemplos, textos e imágenes.

Así han aprendido a trabajar gramaticalmente con gran soltura, pero sin ninguna comprensión. La facilidad de conversación, llegó después, "A OpenAI se le ocurrió una fase adicional que fue la clave del éxito", dice Pablo Haya. Recurrieron al aprendizaje por refuerzo humano, le enseñaron a realizar tareas más útiles y a conversar de forma fluida y natural.

Representación de la inteligencia artificial

"Pusieron a mucha gente a generar conversaciones que simulaban ser una persona pidiendo una instrucción, le pasaban documentos para que los resumiera y le generaban una solución", explica. Mediante este juego en el que recibe la instrucción, los datos de entrada y el resultado, se ha modulado la respuesta de la máquina, se le ha enseñado a conversar con las personas y dotado de personalidades.

"Si te fijas, esa complacencia, las respuestas motivadoras, todas estas coletillas, son ejemplos de las conversaciones que se le han ido pasando", añade este especialista. Con esto se modula el comportamiento, incluso OpenAI ha creado una versión más sarcástica y agresiva llamada Monday para aquellos usuarios que lo prefieren a la versión amigable.

También está el uso de la información externa que aporta contexto actual al modelo. Esto se consigue mediante una instrucción proporcionada por el host del chatbot, es decir, xAI u OpenAI, que permite al sistema rescatar información externa sobre la marcha, de forma similar a cómo los navegadores Google Chrome o Safari de Apple encuentran las webs que ofrecen los detalles que se están buscando.

Correcciones más estrictas

El aprendizaje por refuerzo no fue suficiente, con el uso de los millones de usuarios de estos chatbots, se ha detectado la necesidad de establecer reglas más fijas para atajar fallos o riesgos. En ese caso, se usan los llamados guardarraíles que actúan muchas veces incluso antes de que la frase llegue al modelo de lenguaje, son una serie de filtros y pueden modificar la respuesta que ni siquiera da el modelo.

Aun así, Haya indica que el límite tendrá que ser autoimpuesto, salvo por los guardarraíles que las empresas apliquen forzados por demandas como las recientes. "Para cosas genéricas hay que tomar la información con precaución, pero para cosas más específicas y delicadas, está totalmente desaconsejado".

No existe un ChatGPT ni Grok ni Gemini consciente que empatice con tus problemas o analice las consecuencias de las respuestas o consejos que te ofrece. Esto se puede apreciar cuando el usuario pregunta al chatbot varias veces lo mismo, pero variando la fórmula de la pregunta, lo que supone recibir distintas respuestas, aunque una persona comprendería que la intención de ambas peticiones es la misma.

Seguirán 'alucinando'

Los expertos siguen aconsejando comprobar todo lo que la IA ofrece, pues aún siguen equivocándose al calcular la siguiente palabra que deben usar y aportando datos erróneos. Un nuevo estudio de OpenAI demuestra que las "alucinaciones" de la IA son un problema matemático sin solución. Sus modelos más avanzados fallan hasta el 48% de las veces.

Un usuario inicia una conversación con ChatGPT. Foto: Matheus Bertelli/Pexels

Este medio le ha preguntado a la IA dónde radica el origen de sus errores: "Un asistente de IA puede analizar por qué se produjo el error si se le indica cuál fue la equivocación y qué dato concreto es incorrecto". Esta contestación es, de nuevo, un texto generado con probabilidades, no una verdadera comprensión del fallo.

A estos chatbots se les ha acusado de actuar como un cuñado por no reconocer cuando no sabe del tema. Se le podría enseñar a contestar de forma menos arrogante y reconocer cuándo no sabe de un tema, pero para las empresas responsables podría suponer una pérdida de usuarios. Por lo que recriminarle cuando se equivoca, tampoco sirve de mucho.

Con la llegada de los modelos 'razonadores' se ha mejorado en la calidad de las respuestas. Por supuesto, no razonan, solo se ofrece más tiempo de computación a preguntas más complejas. El propio Sam Altman ha reconocido que con la tecnología actual los fallos y las alucinaciones seguirán siendo un problema.