Son cada vez más los usuarios en España que aprovechan la inteligencia artificial generativa a tantos niveles que requieren usar sus modelos a nivel local, comprimiéndolos en hardware compacto.

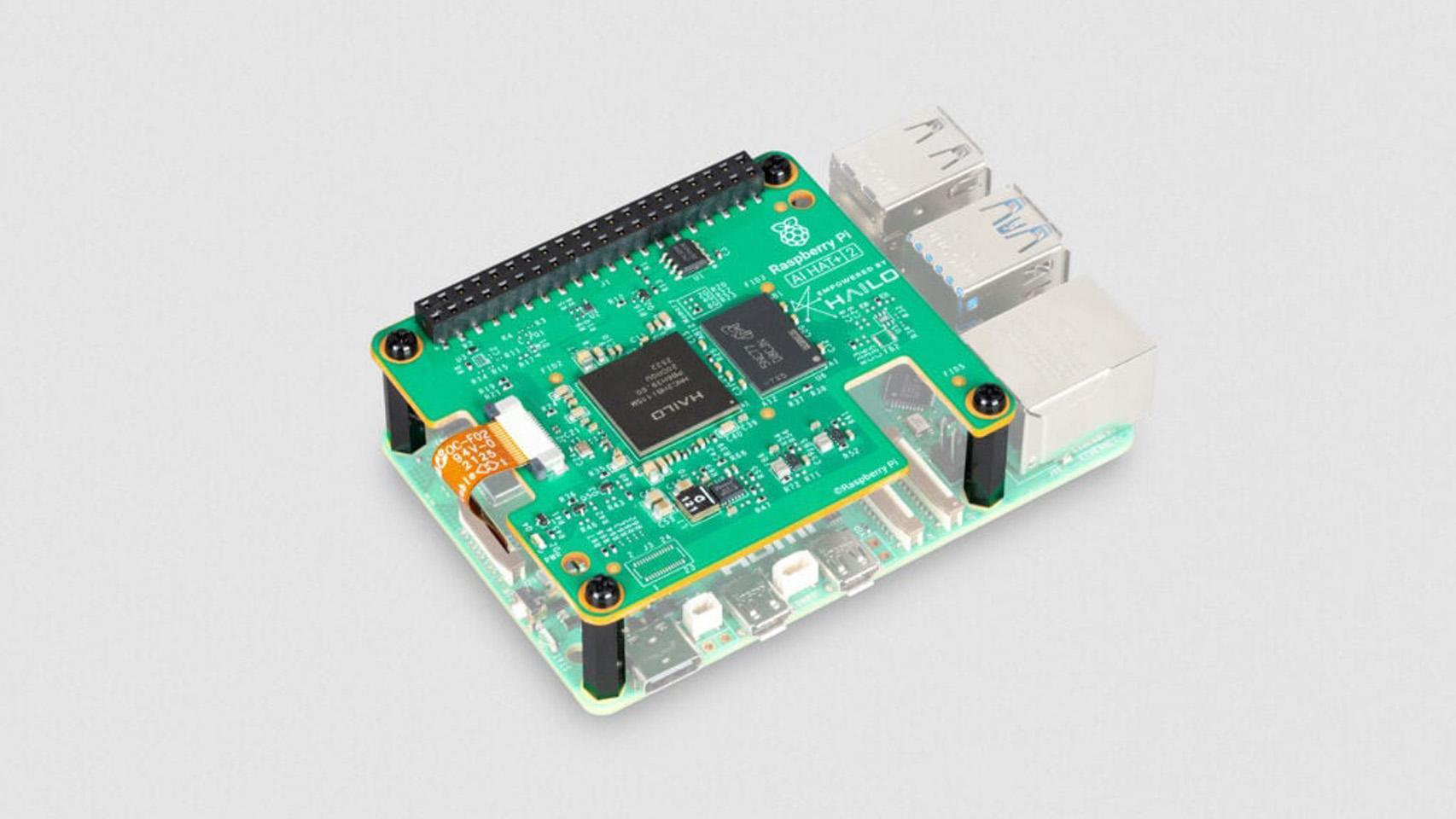

Raspberry, a sabiendas de este problema, ha presentado la Raspberry Pi AI HAT+ 2, una placa complementaria a Raspberry Pi pensada específicamente para la aceleración y ejecución de modelos de IA locales.

Como bien indica su nombre es una renovación de la Raspberry Pi AI HAT+, placa lanzada el año pasado con variantes de 13 y 26 Tera Operations Per Second (TOPS). Esta nueva versión sube la cifra a 40 TOPS.

La nueva Raspberry Pi AI HAT+ 2

El modelo predecesor de esta nueva placa ya era muy bueno para ejecutar ciertas tareas de IA gracias a sus aceleradores de redes neuronales Hailo-8 (26 TOPS) y Hailo-8L (13 TOPS).

El problema es que el avance de la IA es imparable y ahora mismo, esa placa es incapaz de ejecutar los modelos más populares de inteligencia artificial, por lo que esta nueva versión viene a solucionar este problema.

Raspberry Pi AI HAT+ 2 usando un LLM Qwen2:1 5b

Lo hace actualizando su acelerador de redes neuronales, que ahora es un Hailo-10H para lograr un rendimiento de inferencia en INT4 de hasta 40 TOPS, un salto bastante grande respecto a la placa anterior.

La idea de este salto cuantitativo no es otra que garantizar cargas de trabajo de IA generativa ejecutadas en una Raspberry Pi 5, sin problemas de rendimiento asociados.

Y es que al no tener una conexión de red determinando la ejecución de modelos de lenguaje grandes (LLM), aumenta la fiabilidad en el flujo de trabajo y se reduce poderosamente la latencia en estas IA sin nube.

Por otro lado, la Raspberry AI HAT+ 2 dispone de 8 GB de memoria RAM LPDDR4X integrada y dedicada en la misma placa, para gestionar modelos más grandes que antes.

Raspberry AI HAT+ 2.

Entre las aplicaciones que abarca el chip Hailo-10H se incluye la aceleración de modelos LLM, modelos de visión-lenguaje (VLM) y aplicaciones variadas relacionadas con la IA generativa.

Esta memoria RAM beneficia enormemente las tareas relacionadas con modelos basados en visión, como el reconocimiento de objetos o la segmentación de escenas; tareas que en la pasada generación se ejecutaban perfectamente.

Según Raspberry, la AI HAT+ 2 es "prácticamente equivalente" en lo que rendimiento refiere respecto a la versión de 26 TOPS lanzada hace poco más de un año. A esto le debemos sumar varios modelos de lanzamiento incluidos.

La compañía permitirá la instalación de varios modelos concretos que irán desde los 1.000 millones de parámetros hasta los 1.500 millones. Esta es la lista de modelos disponibles de lanzamiento:

- Qwen2

- Qwen2.5-Instruct

- Qwen2-5-Coder

- Llama3.2

- DeepSeek-R1-Distill

Por supuesto, se incluirán y prepararán más modelos y más grandes en forma de actualizaciones que, en palabras de la empresa, "deberían estar disponibles para instalar poco después del lanzamiento".

Raspberry recuerda que existen limitaciones, especialmente si tenemos en cuenta el auge de los modelos de IA generativos más allá de los modelos LLM habituales.

Ciñiéndonos a los modelos LLM, ChatGPT o Claude son los más populares, mientras que en imagen y vídeo tenemos DALL-E y Stable Diffusion. Los LLM basados en la nube suelen ser mucho más grandes.

Concretamente, los modelos de Anthropic, Meta u OpenAI en nube van desde los 500.000 millones de parámetros a los 2 billones de parámetros. Los modelos en borde de la AI HAT+ 2 se ajustan a la memoria RAM integrada disponible.

Raspberry Pi 5

Los LLM más pequeños como los que incluye de lanzamiento la placa no están diseñados para adaptarse al conjunto de conocimientos disponibles para los modelos más grandes.

Así, dice Raspberry, lo que deben entender los usuarios es la necesidad de "operar dentro de un conjunto de datos limitado". Unas limitaciones que se pueden superar ajustando los modelos para determinados casos.

En este sentido, AI HAT+ 2 permite un ajuste fino de los modelos usando el sistema de Adaptación de Bajo Rango (LoRA) para personalizar de forma eficiente y específica estos modelos para cada tarea, manteniendo la mayoría de sus parámetros base inalterados.