Estados Unidos y la inteligencia artificial

EEUU quiere regular la inteligencia artificial pero no sabe cómo: “Europa va por delante. Necesitamos liderar”

Analizamos en detalle de la audiencia del Senado estadounidense en la que testificaron Sam Altman, CEO de OpenAI, y otros expertos.

Un día histórico. Así se vivió la audiencia sobre la regulación de la inteligencia artificial (IA) en el Senado de EEUU este martes 16 de mayo. Tres intensas horas que muchos pasamos pegados a la pantalla del ordenador, escuchando las declaraciones y respuestas de Sam Altman, CEO de OpenAI; Christina Montgomery, vicepresidenta y directora de Privacidad y Confianza en IBM, y Gary Marcus, profesor emérito de la Universidad de Nueva York (NYU), ante los senadores estadounidenses.

La sesión dejó claro que estamos ante un cambio de era, cuyo objetivo es no repetir el laissez faire de los comienzos de internet y la ausencia de límites a las grandes plataformas digitales y las redes sociales.

Pasamos del “no me regules”, al “por favor, regúlame” de los gigantes tecnológicos, en este caso entonado por Altman; de los intentos del gobierno estadounidense por evitar cualquier medida que pudiera verse como límite al capitalismo salvaje, al deseo de posicionarse a la cabeza como potencia reguladora. “Europa va por delante de nosotros. Necesitamos tomar el liderazgo”, afirmó el senador estadounidense Richard Blumenthal, presidente del subcomité encargado de la audiencia.

[Europa regula la inteligencia artificial: un avance positivo y necesario, pero algo abstracto]

Algo que también quedó claro es que no saben cómo ni por dónde empezar. Sí emergieron varias ideas y posibles líneas de acción. Muchas de ellas son propuestas y buenas prácticas que investigadoras como Timnit Gebru, Emily Bender o Margaret Mitchell, y pioneras de la auditoría ética algorítmica, como Gemma Galdon, llevan años empujando por generalizar.

Entre ellas están la creación de una especie de ‘etiquetas nutricionales’ que identifiquen los ‘ingredientes’ (datos usados) y procesos de producción de la IA; la generalización del uso de ‘model cards’ o tarjetas modelo, que evalúan y comparan el uso de estos sistemas en diferentes condiciones en diferentes grupos culturales, demográficos, etc.; y las auditorías externas de los modelos de IA.

[Europa plantea límites a la vigilancia indiscriminada con IA y prohíbe el 'scoring' social]

Otro punto fuerte fue el debate sobre la creación de una agencia regulatoria de la IA. Se planteó tanto la idoneidad de hacerlo a nivel nacional para EEUU –una especie de Agencia del Medicamento al nivel de la FDA– como a nivel global. De las primera opción se criticó que es un tipo de organismo a menudo capturado por los intereses que se supone que deben regular, y acaba controlado por las personas a las que supone que debe estar observando.

Con respecto a la creación de una institución global, el mayor problema es quién, cómo y bajo qué sistema de gobernanza se impulsa, una pregunta a la que nadie supo cómo responder. Marcus propuso crear una institución como el CERN “global, internacional y neutral”, pero centrada en la seguridad de la IA.

También se expuso la necesidad de establecer un sistema de licencias previas que prevengan el desarrollo de tecnologías de IA de alto riesgo, de igual modo que no se construye un reactor nuclear sin obtener una licencia. Marcus puntualizó que dichas licencias deberían aplicarse tanto antes del despliegue de la tecnología como a posteriori. Altman también se mostró a favor de un sistema de licencias para “garantizar que los modelos de IA más potentes se adhieran a un conjunto de requisitos de seguridad”.

Manipulación masiva y personalizada

Hubo otras cuestiones clave en la sesión, que transcurrió con excesiva cordialidad salvo algunos momentos de tensión, como cuando la senadora Marsha Blackburn preguntó insistentemente al CEO de OpenAI sobre cómo planean compensar a los artistas, escritores, locutores y otros creadores de contenido de cuyo trabajo se alimentan herramientas como ChatGPT o Dall-e sin su permiso, ni conocimiento ni retribución a cambio.

El CEO de Open AI acabó reconociendo que las personas deberían poder decidir si quieren o no que sus contenidos se usen para entrenar estos sistemas. También dijo seguir en conversaciones con algunos artistas para tratar de ver cuál puede ser el modelo económico. Más elusivo fue cuando la senadora Amy Klobuchar vaticinó la desaparición de los creadores de contenidos (en específico, de noticias). Klobuchar aseguró que lo que “lo que necesitan es ser compensados por su contenido y que no se lo roben”.

[La Eurocámara aprueba imponer restricciones a ChatGPT y otros sistemas de inteligencia artificial]

No fue el único momento en el que el CEO de OpenAI escurrió el bulto. Dijo estar preocupado por el impacto negativo de la IA generativa, y sin embargo se mostró ajeno a la toma de responsabilidad al respecto ante preguntas como la de cómo afrontar el impacto de la IA en el empleo, que delegó en el gobierno. Eso sí, se mostró muy a favor de trabajar con el regulador para decidir cómo van a ser las normas que les afecten.

La preocupación por el desempleo estuvo muy presente en la sesión, al igual que el poder de manipulación de la IA como arma para la desinformación, que puede a ser usada en intentos de injerencia electoral y en cualquier otro contexto. El senador Josh Hawley citó un estudio reciente sobre cómo los grandes modelos de lenguaje (LLM) pueden predecir la opinión pública, y cómo eso puede usarse por parte de partidos o actores extranjeros en el contexto de las elecciones para obtener ciertas respuestas o comportamientos.

También las respuestas de ChatGPT pueden dirigir el voto de un ciudadano indeciso. “Es una de mis áreas de mayor preocupación. La capacidad más general de estos modelos para manipular y persuadir, para proporcionar una especie de desinformación de forma interactiva, uno a uno”, respondió Altman. El riesgo es en realidad peor: que los sistemas manipulen a las personas incluso sin proponérselo. Es la conclusión de un estudio que Marcus aseguró que publicará pronto.

En el marco de la desinformación y del fraude se habló también de la personificación de la IA, haciéndose pasar por personas reales, incluso clonando su aspecto y voz. Son las llamadas falsificaciones hiperrealistas o deepfakes. Una de ellas, de hecho, protagonizó los momentos iniciales de la sesión, con la reproducción de una falsificación de la voz de Blumenthal.

Privacidad, transparencia y rendición de cuentas

La privacidad, la transparencia y la rendición de cuentas fueron otros asuntos centrales. “Hemos fallado en los intentos por garantizar privacidad de datos, a pesar de que la industria nos ha pedido que la regulemos”, reconoció el senador Christopher Coons.

Otro senador, Jon Ossoff, mencionó el Reglamento Europeo de Protección de Datos y preguntó a Altman si cree que EEUU necesita algo así. “Creo que sería bueno (...) Creo que un mínimo es que los usuarios deberían poder optar por no permitir que empresas como la nuestra o las redes sociales utilicen sus datos. Debería ser fácil eliminar sus datos”, aseguró. Acto seguido repitió lo que había respondido a Blackburn sobre la propiedad intelectual: “Lo que creo que es importante (...) es que si no desea que sus datos se utilicen para entrenar estos sistemas, tiene derecho a hacerlo”.

Sobre la transparencia y la rendición de cuentas insistieron Montgomery y Marcus. La primera habló de la necesidad de transparencia para que sepa con qué y cómo se ha entrenado un modelo de IA, y para gestionarlo y monitorear continuamente su comportamiento y rendimiento durante su ciclo de vida. Sin embargo, puso matices en la necesidad de regulación. Hablo de “un enfoque regulatorio de precisión”. “Creemos que la IA debe regularse en el punto de riesgo”, afirmó.

“Hemos construido máquinas que son como un elefante en una cacharrería: poderosas, temerarias y difíciles de controlar. Todos estamos más o menos de acuerdo con los valores que nos gustaría que honren nuestros sistemas de IA: que sean transparentes, que protejan nuestra privacidad, que estén libres de prejuicios y, sobre todo, que sean seguros. Pero los sistemas actuales no se ajustan a estos valores.

No son transparentes. No protegen adecuadamente nuestra privacidad y continúan perpetuando el sesgo, e incluso sus creadores no entienden completamente cómo funcionan. Y, sobre todo, no podemos garantizar ni remotamente que sean seguros”, declaró el profesor de NYU.

Marcus criticó que “el plan preferido de la gran empresa tecnológica se reduce a pedir que confiemos en ellos”. “Pero ¿por qué deberíamos? Las sumas de dinero en juego son alucinantes”, añadió. Y puso el ejemplo de cómo la propia OpenAI se ha desviado de su misión original de hacer avanzar la IA de forma que beneficie a la humanidad en su conjunto, sin las limitaciones de la necesidad de rendir cuentas financieras. “Siete años después, están en gran parte en deuda con Microsoft”, dijo, y en parte envueltos en una batalla épica con otras grandes empresas tecnológicas.

La democracia, en jaque

Dicha batalla forma parte de una misión mayor: la supremacía tecnológica de los gigantes digitales, por una parte, y de EEUU como país, por otra. “Me preocupa mucho que las tecnologías de IA generativa puedan socavar la fe en los valores democráticos y las instituciones que tenemos. Los chinos insisten en que la IA que se está desarrollando en China refuerza los valores fundamentales del Partido Comunista Chino y el sistema chino. Y me preocupa cómo promovemos una IA que refuerce y fortalezca los mercados abiertos, las sociedades abiertas y la democracia”, aseguró el senador Christopher Coons.

Coons no fue el único en expresar la preocupación estadounidense por el creciente poder del gigante asiático y, en paralelo, también del uso de la IA por parte actores externos para intervenir en asuntos domésticos. En esa carrera por la supremacía tecnológica y por el control de los usos maliciosos de la IA, una preocupación latente es la del riesgo de que la regulación frene la innovación.

“Las salvaguardias sensatas no se oponen a la innovación. La rendición de cuentas no es una carga, ni mucho menos. Son la base de cómo podemos avanzar mientras protegemos la confianza pública; de cómo podemos liderar el mundo en tecnología y ciencia, pero también en la promoción de nuestros valores democráticos”, afirmó Blumenthal.

El senador lamentó no haber tenido tiempo durante la audiencia para abordar las “enormes implicaciones [de la IA] para la seguridad nacional”. “Han abundado las sesiones informativas clasificadas sobre este tema y las amenazas que plantean algunos de nuestros adversarios”, confesó. “Las fuentes de amenazas a esta nación en este espacio son muy reales y urgentes”, dijo.

Por supuesto, durante la sesión se mencionaron también los beneficios que la IA podría traer en ámbitos como la salud o el cambio climático. “Todo muy alentador y esperanzador”, dijo Blumenthal. Pero, de nuevo, estas posibilidades se ven eclipsadas por los impactos negativos, tanto los ya palpables como los que podríamos ver a corto, medio y largo plazo.

En la nueva era de la IA no nos podemos permitir cometer los errores del pasado. Los senadores hablaban de cómo EEUU ha fallado en regular a los gigantes digitales y a las redes sociales; en velar por la privacidad o prevenir y mitigar la discriminación. Sin embargo, no es tarde para hacerlo, y la aproximación de cómo abordar la regulación de la IA es una excelente oportunidad para ello.

La gobernanza digital, asignatura pendiente

Este es solo el principio de un largo proceso. Los senadores tendrán más audiencias con otras expertas y expertos (esperemos que provenientes de diferentes grupos de interés). Su nuevo objetivo es liderar la regulación de la IA y poner salvaguardas para garantizar que se desarrolle de manera que traiga prosperidad a todos, al contrario de lo que ha pasado con internet.

Sin embargo, creo que se olvida que la IA e internet son parte de una misma asignatura pendiente: la de la gobernanza digital. Ambas requieren de una aproximación global, de límites, de transparencia y rendición de cuentas, y de garantizar su seguridad y su desarrollo respetuoso con los derechos humanos, con las personas y con el medio ambiente. Requieren también de impulso a las oportunidades que ofrecen, fomentando la inversión de impacto.

Necesitamos -como propongo en Error 404- una Alianza Democrática para la Gobernanza Digital. A fin de cuentas, el centro del debate no debería ser la herramienta sino lo que queremos preservar. Si el foco es proteger la democracia y a las personas, y dirigir la digitalización y la automatización al bien público, en realidad no importa tanto de qué tecnología hablemos.

Sam Altman dice que su mayor temor es “que nosotros (el campo, la tecnología, la industria de IA) causemos un daño significativo al mundo”. El mío es que no nos pongamos de acuerdo para evitarlo.

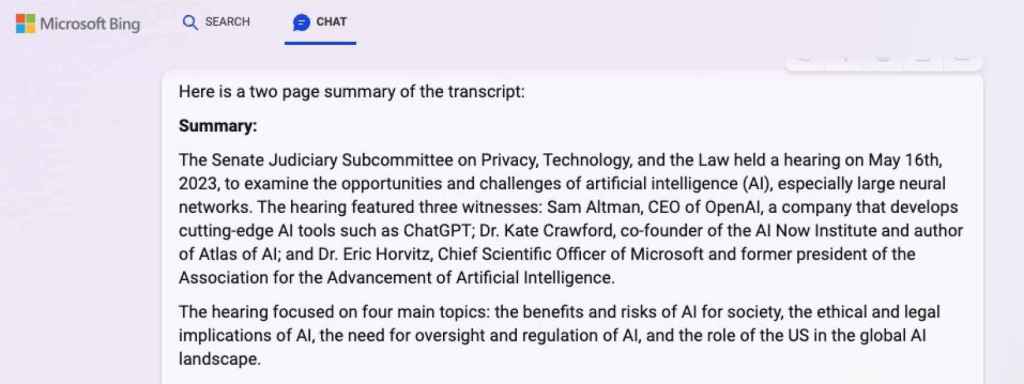

Resumen de ChatGPT de la transcripción de la audiencia en el Senado.

*** PD: Una nota de humor al asunto. Le pedí al ChatGPT del buscador Bing que me hiciera un resumen de la transcripción de la audiencia. ¿El resultado? En ella no participaron ni Montgomery ni Marcus, sino Cate Crawford, fundadora del Instituto AI Now, y Eric Horvitz, director científico de Microsoft.