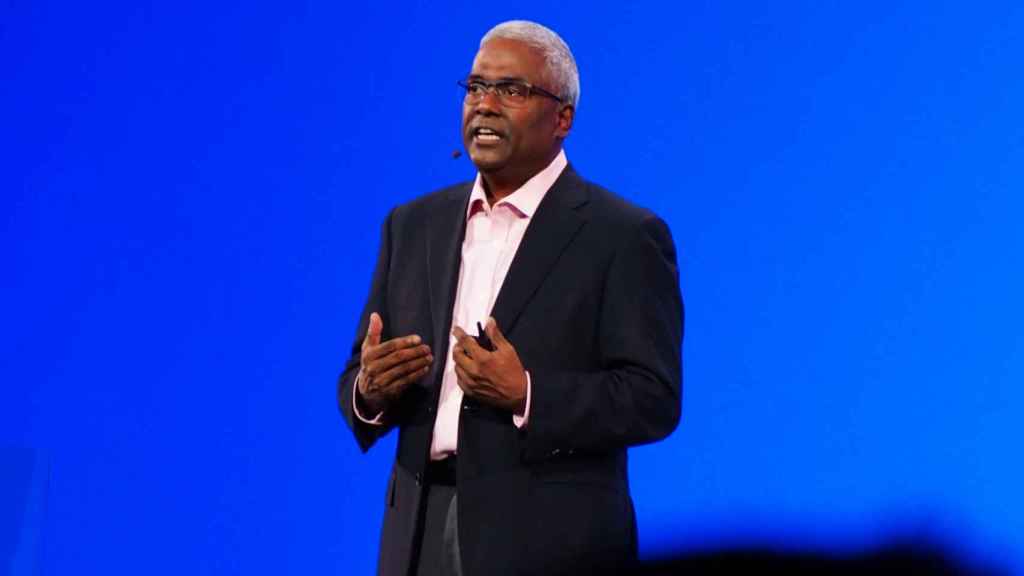

George Kurian, CEO de NetApp.

NetApp pide dotar de inteligencia artificial a las infraestructuras de datos para fortalecer su ciberseguridad

George Kurian, CEO de la firma de almacenamiento, propone unificar con idéntico software el almacenamiento "multicloud híbrido".

"Las organizaciones que se basan en los datos son más capaces de comprender la disrupción rápidamente y convertirla en una oportunidad", asegura George Kurian, CEO de NetApp, apoyando sus palabras en datos procedentes de un estudio del Boston Consulting Group.

No obstante, advierte, "funcionar basados en datos no es fácil. Requiere un planteamiento organizativo y estratégico y una plataforma tecnológica capaz de facilitar la flexibilidad para mover rápidamente partes de tu arquitectura, con la necesidad de integrarse y cohesionarse con otras partes, de manera que puedas conseguir un balance entre el riesgo y la continuidad"

Kurian expone sus argumentos en petit comité, ante un grupo en el que se encuentra D+I - EL ESPAÑOL, para llegar a su mensaje clave en la conferencia Insight 2023, celebrada en Las Vegas: "Hay que poner la inteligencia en la infraestructura para garantizar la seguridad del dato".

"La clave de este planteamiento es tener una infraestructura de datos inteligente que combine un almacenamiento unificado, libre de silos, integrada en todos los sitios donde tengas tus datos, tanto si en un centro de datos [propio] como si es las nubes", remata su primer alegato.

Kurian advierte de que "cuando se produce un ataque, no van contra tus ordenadores o tus dispositivos: atacan a tus datos".

"Los servicios avanzados de datos integrados empezaron incorporando protección. Ahora tenemos la seguridad, la privacidad y la gobernanza. Y, además, la capacidad de operar la infraestructura con observabilidad, monitorización y automatización", detalla.

"La infraestructura de datos inteligente se construye sobre la idea de un tejido de datos multicloud, que ya anunciamos en 2013", prosigue el CEO de NetApp. "Ahora añadimos que puede ser híbrido, además de multicloud, para la tarea de gestionar los datos, que puede ser lo más complicado en esos entornos. Hemos trabajado con los mayores proveedores de la nube para hacerlo posible".

Y así, Kurian concluye que "esta es la siguiente etapa del viaje y estamos emocionados de producir el próximo capítulo en la red, que es esta estrategia".

Evolución del software Ontap

El concepto que lanza NetApp se basa en la continuada evolución de su software de gestión Ontap, cuya primera versión vio la luz hace más de 30 años, explica a D+I - EL ESPAÑOL, Jaime Balañá, director técnico de NetApp Iberia y LATAM.

Hace ya años que NetApp proclamó la vocación de Ontap de ser el sistema operativo de la nube híbrida. "Ahora está en todas partes, siendo lo mismo. Tenemos la misma plataforma, funcionando igual, en todas las nubes y en los servidores on premise. Es la misma, con el mismo software, en un data center proveedor de servicios de cloud pequeñitos o en uno grande, como una Telefónica, [o las nubes de] Amazon, Google o Microsoft, para ser capaz de dar respuesta casi a cualquier tipo de carga de trabajo, independientemente de donde resida", subraya Balañá.

"Somos de los pocos o el único fabricante que tiene la misma plataforma disponible en todos los sitios", asevera.

[Villalgordo (Netapp): el paso a la cloud híbrida ya forma parte de la agenda de los CEOs]

Y, de esa manera, los clientes de NetApp que usan su software, unos 20.000 que utilizan block storage, pueden ver realmente sus almacenamientos como algo unificado ("sin silos, en una plataforma común", dice Kurian), aunque se repartan entre distintos sistemas.

En una breve demostración en vivo, un experto de la compañía enseña cómo con un sencillo drag and drop se mueven bloques de datos entre dos nubes hiperescalares (Google y Microsoft Azure, en este caso). "La única limitación es que haya espacio suficiente en el destino para los datos que se mueven", aclara.

Balañá precisa que, sobre todo, las novedades anunciadas completan "la solución" que ya existía, para contar ahora con "unas plataformas adaptadas a las necesidades de la inteligencia artificial, un paradigma que puede cambiar toda la industria".

"Al final se trata de traer los datos a donde tienes el cómputo. O, al revés, llevarte el cómputo donde están los datos. En todo lo que tiene que ver con la inteligencia artificial, cada vez hay más herramientas. Que no tienen por qué estar en el mismo sitio", añade.

Protección y ransomware

Es en ese sistema operativo, Ontap, en el que se integra "la inteligencia" de gestión y seguridad para que esté "en la infraestructura", en vez de preocuparse de tener que proteger "cada ordenador, cada laptop y cada dispositivo", dice Kurian, "añadiendo diferentes capas".

La inteligencia se integra en la base, con machine learning, para la gestión y la seguridad, pero sin entregarse a la nueva moda de la IA generativa. Y eso es lo que mejor puede explicar el lema de la conferencia, "El factor IT".

La cuestión de la seguridad, y en especial por la creciente amenaza del ransomware, es otro de los puntos clave, en las novedades presentadas por NetApp.

En este ámbito, la compañía con sede en San José (California) plantea una línea defensiva mediante su tecnología de snapshots (imágenes de la tabla de direcciones de los ficheros de datos) en Ontap, que facilitan una rápida recuperación en caso de un ataque de ransomware, regresando al momento en que el sistema estaba todavía "limpio".

La ventaja del procedimiento es que no hay que usar copias de seguridad de todos los datos para rescatarlos (independientemente de que sí convenga hacer backups con cierta periodicidad) mediante volcados masivos que pueden costar muchas horas.

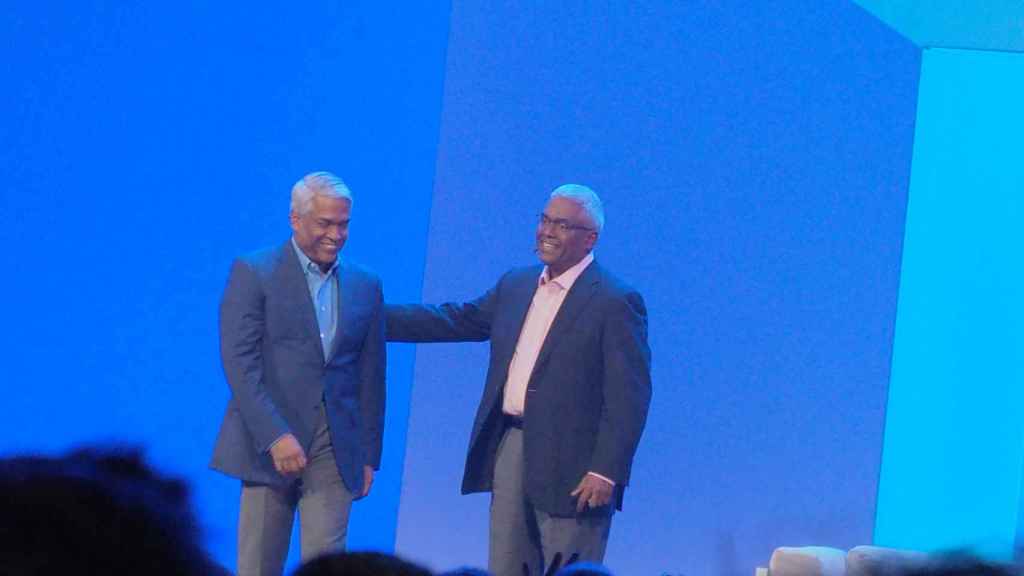

De izquierda a derecha: Thomas Kurian, CEO de Google Clud; y George Kurian, CEO de NetApp.

"El snapshot es una foto de lo que tenías en el momento en que lo hiciste y tenemos la capacidad de hacer muchísimos. Hay un límite, pero es muy alto", explica Balañá. Se pueden hacer con una frecuencia de pocos minutos.

"Cuando se modifica un fichero, lo que se hace es una copia. No se reescribe el fichero antiguo mientras haya sitio en el disco". De ese modo, cuando un ataque encripta los datos, lo que hace es crear un nuevo índice que apunta a esos ficheros encriptados. Si se recupera el último índice "limpio", este apuntará a los datos originales, guardados en el mismo disco y sin encriptar, que el ataque había dejado ilocalizables.

Con este procedimiento, la recuperación del sistema es extremadamente rápida, incluso tratándose de petabytes de información, cuyo volcado de un almacenamiento a otro costaría varios días.

El uso de inteligencia artificial en la propia plataforma básico facilita un control continuo que puede detectar un ataque, monitorizando patrones de actividad inusuales, para iniciar de inmediato las acciones defensivas y de recuperación.

Bloqueo de datos inalterables

El sistema cuenta, además, con una función denominada Snapshot Snapblock, que impide la modificación de datos designados por el administrador, hasta una determinada fecha futura. Lo utilizan algunas agencias del gobierno estadounidense para asegurar datos, e incluso para cumplir aspectos legales que exijan preservarlos tal cual.

La confianza en su sistema es tan elevada que la compañía ofrece una garantía de recuperación de ramsonware, que en esta conferencia ha sido extendida a todos las clases de sistemas de almacenamiento on premise con Ontap, complementada con un servicio de "seguro" sobre ese tipo de ataques.

"Si los datos [secuestrados] no se pueden recuperar por NetApp o uno de sus partners de confianza, NetApp ofrecerá una compensación", declara Sandeep Singh, vicepresidente responsable de almacenamiento empresarial.

Interpelado por este periódico George Kurian, sobre el riesgo que asume con esta incursión en tareas de compañía aseguradora, responde que "la ciberresiliencia es el gran asunto del que estamos hablando. A veces vemos que se pide un rescate en bitcoins, pero en el caso de organizaciones del sector público no lo vemos mucho. ¿Se imagina una llamada al gobierno de Estados Unidos pidiéndole el pago en bitcoins? Los modelos de seguridad que ofrecemos y la garantía de acceso a los datos son críticos, porque, ante un ataque, sea para pedir rescate o para destruir un negocio, lo decisivo es volver a poner operativo el sistema. Y estoy seguro de que nuestro aseguramiento es válido".

Otra parte importante de la conferencia es que NetApp ha vuelto a poner énfasis en su faceta de fabricante de hardware, que en los últimos años había oscurecido un tanto, reivindicándose de manera casi exclusiva como "una compañía de software".

En este Insight, los "hierros", como se ha definido tradicionalmente en muchos departamentos técnicos a los servidores, han tenido gran protagonismo con la presentación de dos nuevas familias de servidores de almacenamiento propios, los ASA A-Series y dos variantes de ASA C-Series, con discos flash de alta capacidad, que, según Singh, "redefinen el almacenamiento de bloques (block storage)".

Inteligencia artificial

En todos los casos, son "cajas" que incluyen el software de la compañía para obedecer a la definición que reafirma Kurian de un mundo empresarial basado en una infraestructura "multicloud e híbrida".

En ella que juegan su parte otras integraciones de servicios y aplicaciones como VMware y Keystone, un modelo de uso por suscripción del que el CEO asegura que "crece rápidamente". Y ahora añade también garantías de seguridad "sin costo adicional", dice el vicepresidente de producto Harv Bela.

Y aunque la aproximación de NetApp a la inteligencia artificial se haya centrado en su aplicación de algoritmos clásicos desde la infraestructura, tampoco puede permitirse el lujo de ignorar la tendencia de moda, la IA generativa, que pide paso en todo tipo de actividades.

El enfoque que aplica es facilitar la conexión de servicios de IA generativa mediante lo que denomina "pipelines", específicos para cada modelo de IA, que facilitan la conexión de los algoritmos con el flujo de datos. "Los científicos de datos no se preocupan de la infraestructura", sentencia el director de producto Russell Fishman.

El evento de NetApp en Las Vegas.

En la conexión entra en juego otro acuerdo de colaboración, para utilizar en este caso la plataforma DGX de Nvidia, con la que las empresas podrán poner sus datos al alcance de aplicaciones de IA generativa.

La demostración de esa conexión, durante la primera intervención de la conferencia, llevó al escenario al CEO George Kurian junto con el CEO de Google Cloud, su gemelo Thomas Kurian, una imagen nada frecuente.

El Kurian de Google, Thomas, presentó el funcionamiento de Vertex AI, una de las aplicaciones de inteligencia de su grupo, sobre la plataforma Ontap de su hermano George. Para explicar su integración en tareas generativas, y con un técnico al teclado, se vio crear una página web en un abrir y cerrar de ojos, a partir de una previa búsqueda de ficheros de datos, de los que elaboró resúmenes para la página html, añadiendo una ilustración producida ad hoc por la misma IA. Todo queda conectado.