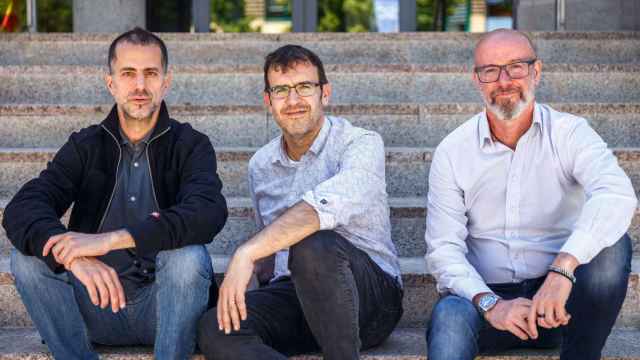

David Cox, director del MIT-IBM Watson AI Lab.

David Cox (MIT): "La inteligencia artificial actual usa automatizaciones que son demasiado laboriosas y caras"

El director del laboratorio sobre inteligencia artificial conjunto del MIT e IBM destaca el rol que van a jugar los modelos fundacionales en el futuro, la necesidad de parcelar esos sistemas y los avances en IA neurosimbólica.

30 junio, 2023 01:43Todo el mundo habla de inteligencia artificial, en tanto se ha convertido en el mantra de nuestros tiempos y en el concepto de moda, allende las fronteras del sector tecnológico. La irrupción en escena de ChatGPT ha puesto los focos sobre la IA generativa y, por extensión, sobre el potencial de esta innovación no sólo para el presente, sino también de cara al futuro más inmediato.

Una de las personas que más sabe sobre el tema es David Cox. A diferencia de los cientos de gurús que surgen en estos momentos al calor de la atención mediática, este hombre lleva desde hace cinco años al frente del laboratorio conjunto sobre inteligencia artificial del Massachusetts Institute of Technology con el gigante IBM. Un ente que coordina investigaciones multidisciplinares con una veintena de equipos de científicos en todo el MIT y cuyos trabajos cuentan con una financiación de 240 millones de dólares a diez años vista.

Cinco años pueden parecer pocos, pero si retrocedemos en su currículo nos encontramos con una trayectoria impecable en la no menos prestigiosa Harvard, donde fue profesor de Ciencias Naturales, Ingeniería y Ciencias Aplicadas. También ha sido colaborador del Foro Económico Mundial, profesor asociado al Centro Berkman-Klein para Internet y Sociedad y ha recibido varios galardones en investigación biomédica y de computación.

[De los años 40 a hoy: así ha madurado la inteligencia artificial]

Eso en su faceta docente e investigadora, porque David Cox también cuenta con un cierto bagaje en esto de emprender alrededor de la inteligencia artificial. De hecho, durante su etapa en Harvard, cofundó varias startups de IA como la célebre DeepHealth, adquirida posteriormente por RadNet.

Hablamos con David Cox, en entrevista exclusiva con D+I - EL ESPAÑOL, para conocer más sobre su persona pero, especialmente, sobre lo que podemos esperar y lo que no de los avances en inteligencia artificial.

Pregunta: Ha trabajado en diferentes universidades de prestigio, como Harvard o el MIT, también en varios institutos de investigación y empresas como IBM en este momento, sobre áreas tan diversas como ciencias de la computación, biomedicina, biología molecular o neurociencia. ¿Qué hay detrás de esa heterogeneidad y cuál es el punto en común de todas esas disciplinas?

David Cox: He tenido una carrera un poco ecléctica y a veces digo que soy un académico en recuperación porque estuve en Harvard durante diez años antes de unirme a IBM. La razón de esto es que aunque la inteligencia artificial parece un campo nuevo, hay aspectos de ella que son realmente antiguos. Lo distinto de la actualidad es que personas con muchas ideas diferentes de áreas muy diversas han entrado en esta tecnología. Por ejemplo, ahora es muy raro que alguien haga sólo biología o química, es más común que integre la inteligencia artificial en esos procesos de investigación.

Al principio me fascinó cómo funcionaban nuestros propios cerebros biológicos. Hay un viejo dicho de Richard Feynman que afirma que de lo que no entendemos, no podemos construir. Por eso me obsesionaba la idea de que no solo podíamos entender cómo funcionan nuestros cerebros, sino que también podíamos construir sistemas con algunas de las mismas habilidades. Por eso, cuando estaba en Harvard, tuve un laboratorio que hacía neurociencia y teníamos gente trabajando en experimentos biológicos en un lado del laboratorio, y otra gente construyendo algoritmos en el otro lado.

P: También tiene un perfil de fundador de startups relacionadas con ese campo, que quizás ha facilitado la transición a este nuevo rol entre la empresa y la Academia...

D.C.: Por el camino me interesé y comencé a cofundar algunas compañías. Fue ahí donde me di cuenta de que estos avances no sólo eran interesantes intelectualmente, sino que tenían la capacidad de mejorar la vida de las personas. Por eso cuando me propusieron liderar el laboratorio de inteligencia artificial del MIT e IBM supe que tenía la oportunidad de fusionar lo mejor de la Academia, con una institución de clase mundial como el MIT- con lo mejor de la investigación industrial de IBM Research, con más de 75 años de una larga historia de premios Nobel y Turing.

P: Un rol en el que lleva ya cinco años y que busca explorar las fronteras de la inteligencia artificial, entre otros propósitos. Esta tecnología data ya de los años 40 del pasado siglo, aunque se haya puesto de moda en los últimos tiempos, ¿cuál es el estado del arte presente y cuáles son las fronteras que quedan por conquistar?

D.C.: Es pertinente decir que la emoción actual en torno a la inteligencia artificial generativa no va a terminar pronto; hay mucho más que hacer desde el momento en que partimos de que la IA no sólo puede clasificar o predecir, sino también crear. En nuestro caso, desde el laboratorio del MIT-IBM, los profesores/investigadores se reúnen y se preguntan cuál sería la cosa más emocionante e impactante en que podrían trabajar en la frontera de esta tecnología.

Y, la verdad, es que hay multitud de frentes. Trabajamos con 21 departamentos y centros de investigación del MIT, incluyendo científicos informáticos, biólogos, químicos y cualquiera que pueda poner una buena idea sobre la mesa.

Eso sí, gran parte de nuestra cartera de investigación está centrada en los modelos fundacionales de la inteligencia artificial. Esto es, cómo entrenar modelos grandes que no sólo sean útiles para una cosa, sino que puedan ser reutilizados para múltiples tareas.

El problema con la automatización es que es demasiado laboriosa y cara, según la visión de la IA tradicional: había que recopilar una gran cantidad de datos, dotarlos de sentido y curarlos, para finalmente encontrar un caso de uso donde poder emplear esta tecnología. Y cuando se quería repetir el proceso con una tarea distinta había que comenzar desde cero, lo que obligaba a tener mucho cuidado con dónde y cuándo usabas la IA para que valiera realmente la pena.

P: Un proceso realmente frustrante...

D.C.: Como analogía, podemos pensar en un río de datos fluyendo a través de la empresa. Hasta ahora lo que veníamos haciendo eran presas aquí y allá, que sabemos que es algo muy costoso de construir y que no se puede hacer en cada arroyo o cada estanque pequeño, en este caso las pequeñas cosas y aspectos de nuestros trabajos que son tediosos o propensos a errores. Requiere mucho esfuerzo levantar cada presa y, además, la mayor parte del agua de la tierra en realidad no está en ese río.

"Lo que estamos haciendo ahora con la IA es poner presas en cada tramo del río, con los modelos fundacionales podremos aprovechar ese agua sin necesidad de construir todo de nuevo cada vez"

Los modelos fundacionales cambian esta aproximación por completo: podemos entrenar modelos enormes con datos ya trabajados sin ninguna necesidad en particular en mente. Lo único que le estamos pidiendo al sistema es que entienda el texto o el código, con un esquema muy simple de secuencias de palabras y predicciones lógicas. Podemos verlo como un juego de adivinanzas de niños, que puede parecer realmente trivial, pero que proporciona la base para entrenar algoritmos con grandes cantidades de datos sin tener que etiquetarlos. Una vez que tienes ese modelo fundacional, lo puedes aplicar en una variedad enorme de tareas, con tan sólo algunos ejemplos o instrucciones sencillas. E incluso combinarlo con las formas antiguas de IA para conseguir resultados incluso mejores.

P: Los modelos fundacionales son una de las grandes promesas para encarar esa segunda vuelta de la inteligencia artificial moderna. Sin embargo, y al igual que hay voces que defienden esa capacidad general como una bondad, hay expertos que critican su falta de calidad y precisión frente a los modelos tradicionales, los que han sido entrenados y pensados por y para un caso de uso concreto...

D.C.: Es una gran pregunta y creo que la respuesta está en algún punto intermedio entre ambas posturas, con muchos matices. Con los modelos que están diseñados para una sola tarea el problema radica en que, en muchas ocasiones, simplemente no hay suficientes datos para entrenarlo bien. Las empresas están muy limitadas en cuanto a lo que pueden hacer, porque el algoritmo necesita aprender sobre cómo funciona el lenguaje y otros aspectos básicos a los que no tienen acceso las compañías con sus propios datos.

Los modelos fundacionales, en cambio, amplían dramáticamente el conocimiento y los datos sobre los que poder construir valor. Es como subirse a los hombros de un gigante. Pero, por supuesto, también es importante que las empresas traigan sus propios datos y sus propias tareas, que son su joya de la corona y tienen un gran valor intrínseco.

Pero eso no significa simplemente acceder a esa información por medio de una API para conectarla con el modelo que todo lo sabe. Eso no aprovecha de verdad el valor de los datos. En este caso, por lo que apuesta IBM es por dar a los clientes herramientas para usar estos modelos fundacionales en sus propios términos, dándoles la base ya entrenada y que luego sean las empresas las que construyan sus propios modelos especializados. Las compañías deben participar en la creación de valor con la inteligencia artificial y, por supuesto, ser los propietarios de ese valor.

P: También podríamos ir hacia modelos fundacionales pero tematizados o especializados en determinados verticales muy específicos, ¿no?

D.C.: En ocasiones, los modelos especializados a menudo superan a los generalistas más grandes, que son de pura cimentación. Hay un ejemplo, donde un grupo de Stanford pudo construir un modelo útil para los investigadores, entrenando un modelo fundacional sólo sobre literatura biomédica, con 2.700 millones de parámetros. No es demasiado grande para los estándares de hoy en día, pero ese nivel de especialización sí le permite ser mejor que un sistema entrenado de manera general.

"Los modelos fundacionales diseñados para un determinado sector superan a los generales y, además, son más eficientes"

Si se me permite el símil, es como pedirle consejo a un experto o a la persona más inteligente que conoces. El listo puede saber muchas cosas, pero no puede igualar la experiencia de un experto en un dominio concreto. Por eso es clave poder hacer modelos fundacionales que sean específicos para una temática, como estamos haciendo desde el laboratorio de IBM y el MIT con sectores como las finanzas

Además, estos modelos más pequeños que están entrenados de forma muy especializada son mucho más eficientes a la hora de su ejecución. Por tanto, los costes de entrenamiento y de conseguir inferencias son mejores que con modelos más grandes y genéricos que obviamente aumentan los requerimientos. No olvidemos que GPT-3 necesitaba 1.000 GPU que consumen cientos de vatios de energía al mes, con su consiguiente impacto en emisiones de CO2. Por eso, habrá casos en que sean necesarios pero, para muchas de las aplicaciones empresariales, necesitaremos otros modelos fundacionales que se adapten mejor a las necesidades y los casos de uso inmediatos.

P: Y esto sólo en lo que atañe propiamente dicho a la inteligencia artificial generativa, pero también hay muchos avances en el campo del aprendizaje automático adversativo para ayudarnos a corregir muchos de los riesgos o incorrecciones que pueden producir estas tecnologías...

D.C.: Ciertamente, la IA generativa viene con muchos desafíos nuevos. En algunos casos, es difícil incluso medir nuestro progreso porque hay situaciones en las que es fácil decir si se trata de una tarea de discriminación de sí/no. Pero si estás generando respuestas en forma de texto, evaluar el resultado se vuelve más difícil. Por eso, un problema que tienen los modelos de IA hoy en día es que a veces generan resultados incorrectos, aunque parezcan correctos superficialmente.

Incluso los hechos básicos pueden ser un desafío para la IA generativa. Por ejemplo, le pedí a los chatbots que escribieran una biografía mía y acabó creando todo un alter ego de mi persona, con algunos datos correctos y otros inventados. Este ejemplo demuestra que aún hay mucho trabajo por hacer en la evaluación y mejora de los modelos de IA generativa.

Existen desafíos reales en el uso de la inteligencia artificial generativa en una configuración abierta, como en conversaciones informales. Ha habido casos en los que los abogados han solicitado jurisprudencia y la IA ha producido resultados convincentes, pero todos eran falsos. Por lo tanto, es importante limitar el conjunto de problemas en los que se usa la IA generativa para aprovechar su poder sin incurrir en tanto riesgo.

P: Casi parece que necesitamos protegernos de un ente con vida propia, esa tan publicitada inteligencia artificial general que algunos autodenominados gurús anticipan en un futuro próximo...

D.C.: La inteligencia artificial general es una noción interesante, pero no está claro siquiera si es necesaria para mejorar la vida humana. En este momento, hay mucho poder y mucho valor en la tecnología que ya tenemos, por lo que construir una máquina que pueda pensar o sentir por sí sola es una idea problemática y, claramente, no es nuestro objetivo.

P: Estos modelos de IA han sido entrenados con muchos datos diferentes que no sabemos exactamente cuáles son, lo que plantea diferentes problemas legales y éticos, como el sesgo y el uso responsable de la tecnología. También existe una discusión sobre la propiedad intelectual de los datos utilizados para entrenar los modelos y cómo se utilizan para crear nuevas cosas. No sabemos exactamente quién es el dueño de esos datos. ¿Cómo podemos dar garantías y confianza al respecto?

D.C.: Son problemas difíciles, pero que nos estamos tomando muy en serio. Una de las cosas que desde IBM se está haciendo es curar un gran conjunto de datos a escala de internet con mucho cuidado, evitando ciertos conjuntos de datos que podrían ser problemáticos por razones de derechos de autor o propiedad intelectual. Además, estamos aplicando filtros de odio o discriminación basado en IA en todo el conjunto de datos.

"Tratamos de entender cómo hacer que los modelos fundacionales sean más confiables, menos sesgados, más explicables y fieles a nuestros valores sociales"

Podríamos decir que estamos haciendo un conjunto de datos positivo y otro negativo. Por un lado, agregando cosas que sabemos que les importarán a las empresas, como finanzas y ciberseguridad, mientras eliminamos lo que no es apropiado. Actualmente, estamos apuntando a más de dos billones de tokens en datos, de los que ya hemos curado la mitad. Y, además, en un proceso continuo de mejora y de reevaluación según avance la regulación para sacar fuera lo que no deba estar en este 'set' de entrenamiento.

Por otro lado, tenemos un programa de investigación sobre cómo poner barreras en estos modelos, mientras tratamos de entender cómo hacer que los modelos fundacionales sean más confiables, menos sesgados, más explicables y fieles a ciertos valores que queremos que inculquen.

P: Confianza por diseño, no por defecto, que se suele decir...

D.C.: Exactamente, esa es una gran área de investigación en la que estamos inmersos.

P: Quiero preguntarle también sobre la inteligencia artificial desde la aproximación neurosimbólica, ya que es una de las tendencias o nuevas formas que tenemos para lograr una nueva ola de inteligencia artificial. Con esta técnica, los sistemas no solo pueden identificar símbolos, sino también asignar información semántica y lógica a estos símbolos. Me gustaría saber cuál es el estado del arte de esto, ya que esto podría crear algoritmos capaces de entrenarse para identificar y comprender de manera más profunda...

D.C.: Hemos estado trabajando en la IA neurosimbólica durante bastante tiempo, desde que comenzó el laboratorio. Existen muchas maneras diferentes de combinar la manipulación simbólica y la computación simbólica, que es la base de toda nuestra computación. Nuestra capacidad para escribir código y funciones que pueden tomar argumentos es una forma de manipulación de símbolos y es muy poderoso. Sin embargo, aprender de los datos también es muy poderoso y ha habido momentos en la historia de la IA en los que los enfoques simbólicos han dominado y otros en los que los métodos basados en el aprendizaje han dominado.