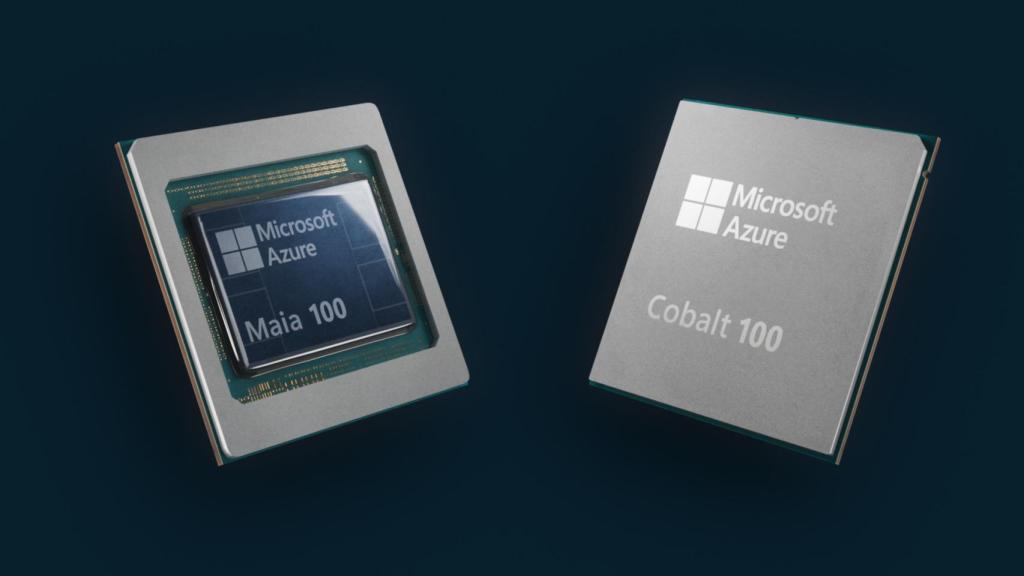

El nuevo chip Azure Maia 100, diseñado para acelerar las cargas de trabajo de inteligencia artificial. Imagen: Microsoft.

Microsoft se mete de lleno en el silicio para construir la plataforma física que dé vida a la inteligencia artificial

Los de Redmond lanzan dos nuevos chips diseñados para su nube Azure y que sirven de base para revisar y optimizar toda la infraestructura que soporta el despertar de la inteligencia artificial generativa.

Si bien la inteligencia artificial llevaba con nosotros desde los años 50, el causante de su extraordinaria popularidad en estos días tiene nombre propio: OpenAI y, más concretamente, su herramienta estrella, ChatGPT. Se trata sin duda del servicio de IA generativa que ha democratizado este concepto hasta ahora abstracto y ajeno, que lo ha traído a la primera plana de la actualidad y que, también, ha hecho revivir el espíritu de un sector tecnológico que en 2022 amenazaba con comenzar un período de ralentización y consolidación.

Nada más lejos de la realidad, porque los números hablan por sí mismos: 180,5 millones de usuarios en la primera mitad del año mientras nueve de cada diez empresas del Fortune500 utilizan ya ChatGPT en alguna forma. Son cifras de Gitnuz que se complementan con la visión más amplia de este mercado: Demandsage estima que la IA generativa moverá nada menos que 43.870 millones de dólares en 2023, ascendiendo hasta unos impresionantes 667.960 millones para finales de la década.

Un éxito masivo que no se ha producido de la noche a la mañana, pero que en parte sí ha pillado desprevenidos incluso a sus propios impulsores. Es el caso de Microsoft, el gigante estadounidense que se ha dado prisa en incorporar esta tecnología de IA generativa en prácticamente todas sus áreas de negocio, en dotarse de una marca reconocida como el estándar de consumo para la inteligencia artificial (Copilot) y, ahora, en reforzar la infraestructura física que debe dar soporte no sólo a las millones de interacciones que se producen con estos sistemas, sino también a su entrenamiento y perfeccionamiento.

Los chips Azure Maia 100 y Azure Cobalt 100.

En la conferencia Ignite 2023, Microsoft ha dado vida a dos nuevos chips diseñados por esta casa en sus propios laboratorios de Redmond (Washington). Se trata de Azure Maia, un chip acelerador de IA para entrenamiento e inferencia en la nube, especialmente adecuado para modelos de OpenAI, Bing, GitHub Copilot y ChatGPT; y Azure Cobalt, un chip nativo para la nube basado en la arquitectura ARM, optimizado para cargas de trabajo generales en términos de rendimiento, eficiencia energética y rentabilidad.

“Tenemos una visión clara de que para poder sacar el máximo partido de la inteligencia artificial debemos apostar por un enfoque en los sistemas, en toda la plataforma que permite su funcionamiento, desde el silicio hasta los racks, pasando por las redes, la refrigeración, la seguridad o el propio centro de datos”, explica Rani Borkar, vicepresidenta corporativa de Sistemas e Infraestructura Cloud de Microsoft, en entrevista con D+I – EL ESPAÑOL.

Revolución desde el silicio

¿En qué se traduce esta declaración de intenciones? En una revisión exhaustiva de cada uno de los componentes que conforman el hardware necesario -entregado desde la nube pública de la casa, como no podía ser de otro modo- para operar y evolucionar las tecnologías de inteligencia artificial, “aportando innovación en cada una de las capas y ofreciendo opciones tanto para nuestro propio uso interno como de cara a clientes externos”.

Rani Borkar, vicepresidenta corporativa de Sistemas e Infraestructura Cloud de Microsoft, con los nuevos chips para IA de la compañía. Imagen: Microsoft.

Así que los dos chips que ven la luz hoy no son una apuesta aislada, un hito de la ingeniería de un laboratorio de diseño de semiconductores de primer nivel. Hablamos, empero, de una pieza más -la central, sí, pero una más- de la obligada reimaginación de la infraestructura que nos permite seguir soñando con los límites plausibles de la inteligencia artificial generativa.

Entrando en detalles técnicos que puede adelantar este medio, Maia 100 es un chip acelerador de IA que ya está siendo utilizado con ChatGPT 3.5 “con grandes e ilusionantes resultados de rendimiento”, afirma Borkar, sin concretar datos por el momento… aunque añade: “Este chip nos permite sentar las bases para responder a las necesidades cambiantes que van surgiendo conforme desarrollamos la inteligencia artificial”. Hablamos de una pieza fabricada en un proceso de 5 nanómetros con 105.000 millones de transistores, uno de los mayores que se pueden fabricar con la tecnología actual.

A su vez, Cobalt 100 (el chip para cargas de trabajo generales, basado en el ARM Neoverse CSS de 64 bit, "el más potente de la nube", según Microsoft) está siendo testado en servidores SQL y en la popular herramienta de colaboración Teams, antes de su lanzamiento comercial previsto para el próximo curso. La innovación con este segundo silicio radica en su menor consumo energético y mayor rendimiento (hasta un 40% más que las actuales generaciones de servidores ARM de Azure), derivado de poder “controlar el rendimiento por cada uno de los núcleos del chip”. A 128 cores que monta este hardware, la granularidad que ofrece a la hora de equilibrar potencia y consumo se antoja inmensa.

Pero la visión de conjunto, esa aproximación al reto de la infraestructura como una plataforma holística y comprehensiva, implica que son necesarios más pilares para que llegue a buen término. Así pues, desde la fría Seattle se ha anunciado que Azure Boost, el sistema que acelera el almacenamiento y las redes trasladando estos procesos a hardware y software específicos, balanceando las cargas en local y en remoto, el cual había sido anunciado este año, pasa a estar disponible para todo el público.

Al mismo tiempo, Microsoft ha ampliado sus ya de por sí extensas alianzas con los fabricantes de componentes y hardware, muchos de ellos suministradores de su no menos ingente red de centros de datos en todo el mundo. En este sentido, la multinacional ha anunciado nuevas máquinas virtuales con el acelerador AMD MI300X en Azure, diseñadas para procesar cargas de trabajo de inteligencia artificial, y la serie NC H100 v5 Virtual Machine con GPUs NVIDIA H100 Tensor Core, específicamente pensadas para el entrenamiento de IA de rango medio y inferencia generativa. A sumar la serie ND H200 v5 Virtual Machine, optimizada también para la inteligencia artificial y que montará la próxima GPU NVIDIA H200 Tensor Core.

Instalaciones de prueba de los chips en el Silicon Lab de Microsoft en Redmond (EE.UU.).

Finalmente, la compañía ha anunciado el servicio NVIDIA AI Foundry en Azure, destinado a acelerar el desarrollo, ajuste y despliegue de modelos de IA personalizados sobre las tarjetas gráficas de este proveedor.

Jen-Hsun "Jensen" Huang, fundador y presidente de NVIDIA, explicaba en el mismo escenario que "la inteligencia artificial está trayendo consigo un importante desafío para los centros de datos, va a ser una revolución mayor que el móvil o internet. Hemos acelerado todo lo posible, especialmente en la parte de rendimiento, consumo energético e impacto medioambiental. Hemos puesto todas las mejores capacidades de supercomputación y, junto a Microsoft, hemos creado una plataforma completa en apenas unos meses; el tercer mayor supercomputador de todo el planeta y el primero diseñado para la IA".

Copilot para todo

Ignite 2023 ha sido inaugurada por la plana mayor de la histórica enseña, con su CEO Satya Nadella al frente y acompañado de otros grandes nombres como Rajesh Jha, Jared Spataro, Vasu Jakkal o Nastasha Crampont, esta última Chief Responsible AI Officer. Una conferencia, una de las dos grandes citas de Microsoft en el calendario, junto a su conferencia para desarrolladores Build, que este año está monopolizada por la inteligencia artificial como mantra de moda.

No es para menos, porque la firma también ha puesto de largo novedades en torno a Copilot, su paraguas de soluciones de IA dirigidas al usuario final. "Es el año de los copilotos, en todos los sectores", ha destacado el propio Satya Nadella, CEO de Microsoft, sobre el escenario del Seattle Convention Center. "Con Copilot somos capaces de acabar tareas mucho antes, hasta un 67% menos tiempo. Copilot va a ser la nueva interfaz de usuario para la era digital, un agente para actuar sobre el conocimiento de las empresas".

En concreto, este evento ha servido para conocer Copilot Studio, una herramienta de low-code para integrar datos críticos de negocios en forma de plugins, GPTs o aplicaciones personalizadas para casos de uso concretos, o Copilot for Service, diseñado para acelerar la transformación de IA en el servicio al cliente. Asimismo, Microsoft también está introduciendo Copilot en Dynamics 365 Guides, combinando IA generativa con realidad mixta para asistir a los trabajadores de primera línea, y Copilot for Azure, un compañero inteligente para los administradores de sistemas en la nube.

En el ámbito del desarrollo, la apuesta se llama Azure AI Studio y su propósito es brindar una plataforma unificada para explorar, construir, probar y desplegar aplicaciones de IA, pudiendo extraer el máximo partido que la imaginación permita al nuevo modelo GPT-3.5 Turbo y la vista previa pública del modelo GPT-4 Turbo, que verá la luz este mismo fin de semana en Azure.

Igualmente, y de cara al consumidor puro (el ciudadano), Microsoft eliminará las marcas de Bing Chat y Bing Chat Enterprise que hasta ahora venían recogiendo las capacidades de OpenAI en los motores de búsqueda de la compañía. Desde ahora, todo pasa a formar parte del paraguas de Copilot, con lo que tendremos que hacernos al uso de la enseña Copilot de forma independiente, disponible en Edge y Chrome y próximamente en forma de aplicaciones móviles.

Microsoft Fabric, la base de todo

Todos los modelos fundacionales en inteligencia artificial generativa de Microsoft necesitan de un ingrediente básico: datos. Por ello la compañía ha anunciado novedades alrededor de Fabric, una solución que permitirá perseguir ese sueño del dato único, a modo de plataforma unificada y sin fricciones para alimentarse de bases de datos diversas. Una vez sentado este lago de datos, su conectividad natural con herramientas de negocio como Dynamics o PowerBI pero también con Azure AI Studio hace el resto de la magia: decisiones o alertas en tiempo real, chats que dé contexto sobre ese aviso automatizado... El futuro es infinito.